Aby robot mógł poruszać się w zmieniającym się dynamicznie środowisku, musi mieć możliwość obserwacji tego środowiska. Ludzie realizują ten cel przede wszystkim za pomocą zmysłu wzroku – patrzymy na świat widzeniem stereoskopowym, co pozwala nam nie tylko dostrzegać otaczające nas przedmioty i innych ludzi, ale także lokalizować je w trójwymiarowej przestrzeni. Aby roboty mogły osiągnąć podobną świadomość otoczenia, wymagają zastosowania różnych sensorów i czujników.

Fabryki przyszłości wypełnione będą współpracującymi ze sobą ludźmi i maszynami, w postaci robotów przemysłowych, obrabiarek numerycznych i autonomicznych pojazdów transportowych. Dla każdego z tych urządzeń percepcja głębi i możliwość rozpoznawania widzianych przedmiotów to kluczowe umiejętności, zwłaszcza, gdy mówimy o współpracy z człowiekiem. O ile maszyny nie mają obecnie większego problemu we współpracy ze sobą, o tyle człowiek ze swoimi chaotycznymi i czasami nieprzewidywalnymi ruchami jest dla nich problemem.

Robot przemysłowy porusza się zaprogramowanymi wcześniej trajektoriami ruchu. Drugi robot bez problemu może wiedzieć, gdzie ten pierwszy będzie się znajdował. Nawet jeżeli oba systemy są w jakimś stopniu autonomiczne, to mogą się wymieniać danymi w czasie zbliżonym do rzeczywistego. Dzięki temu potrafią uniknąć takich zdarzeń, jak np. kolizja ramion. Człowiek nie porusza się po ustalonej trajektorii ani też nie jest w stanie cyfrowo przesłać informacji o tym, gdzie zamierza postawić kolejny krok. Na dodatek, jak wszyscy dobrze wiemy, ludzie nie panują w 100% nad swoimi ruchami. Każdemu z nas zdarzyło się upaść – to samo w sobie jest niebezpieczne, ale w sąsiedztwie szybko poruszających się autonomicznych maszyn może być przyczyną nawet śmiertelnego wypadku.

Percepcja głębi jest kluczowym aspektem dla świadomości otoczenia przez robota. To, co człowiek uzyskuje dzięki widzeniu obuocznemu, roboty mogą osiągać różnymi metodami. W dalszej części artykułu omówimy szereg technologii, pozwalających na percepcję głębi w systemach elektronicznych. Oprócz nawigacji, w dynamicznie zmieniającym się otoczeniu, systemy te wykorzystywane są także do skanowania trójwymiarowego czy zarządzania magazynami. Wiele tych systemów znajduje zastosowanie także poza przemysłem, na przykład w autach autonomicznych – one też są pewnego rodzaju robotami. Dzięki postępowi, systemy te oferują coraz większą precyzję i możliwość pracy w trudnych, przemysłowych warunkach.

Radary mikrofalowe

Systemy radiowego wykrywania obiektów i pomiaru odległości wykorzystują transmisję i odbiór fal radiowych do określania odległości, prędkości i kąta poruszania się obiektów w ich polu widzenia. Radar ma bogatą, 75-letnią historię i jest integralną częścią wielu technologii stosowanych m.in. w lotnictwie i obronności, automatyzacji przemysłowej i nie tylko. Współczesne radary, stosowane w robotyce, działają w paśmie fal milimetrowych. Typowym pasmem jest np. 24 GHz, stosowane w inteligentnej infrastrukturze miejskiej czy pojazdach autonomicznych.

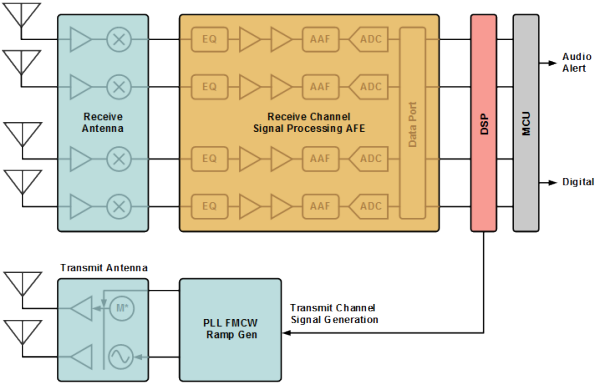

Typowy radar mikrofalowy to wielokanałowy system akwizycji, składający się z jednego lub więcej torów nadawczych (Tx) i wielu torów odbiorczych (Rx). Na rysunku 1 pokazano architekturę typowego systemu radaru mikrofalowego. Każdy z torów odbiorczych składa się z odbiornika mikrofalowego, gdzie znajduje się wzmacniacz niskoszumowy i konwerter częstotliwości, który redukuje częstotliwość sygnału z 24 GHz do niższej wartości, na ogół nie wyższy niż kilka megaherców. Sygnał ten przekazywany jest do front-endu analogowego, gdzie znajdują się filtry pasmowe, wzmacniacze i filtry antyaliasingowe, na końcu których wpięty jest przetwornik analogowo-cyfrowy, który digitalizuje sygnał i przekazuje go do wspólnego dla wszystkich kanałów odbiorczych procesora sygnałowego (DSP).

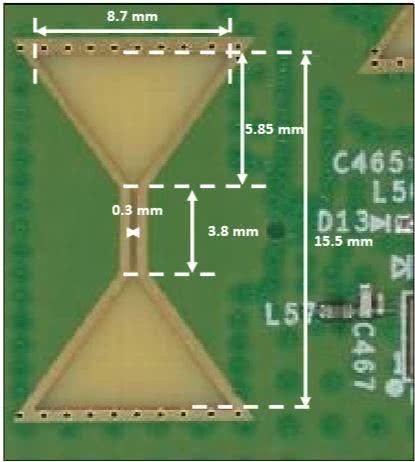

Radary mikrofalowe wykorzystuje się do analizowania i obrazowania przestrzeni. Dzięki możliwości integracji anten mikrofalowych na PCB (rysunek 2) systemy radarowe tego rodzaju mogą być bardzo małe. Istnieje ponadto szereg gotowych układów RF, które integrują w sobie wszystkie potrzebne elementy, do budowy tego rodzaju radaru. Komunikują się z wykorzystaniem typowych interfejsów cyfrowych, co ułatwia ich integrację z dowolnym procesorem aplikacyjnym w systemie.

LIDAR-y

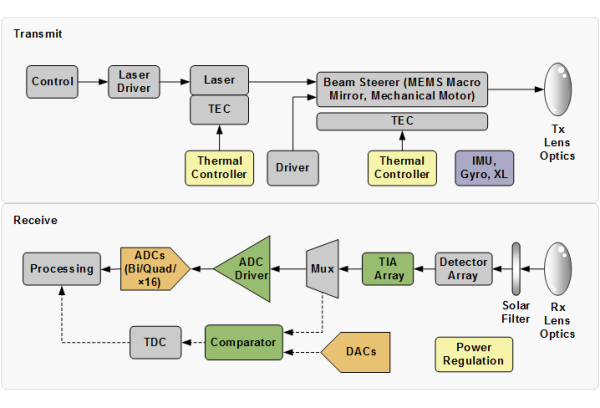

LIDAR to system, który mierzy czas przelotu impulsu światła, aby móc określić odległość między czujnikiem a obiektem. Zasada działania tego systemu jest bardzo prosta – układ emituje krótki impuls światła, najczęściej laserowego i czeka, aż odbije się od otoczenia. Odbite światło zbierane jest przez sensory wbudowane w układzie. LIDAR mierzy czas pomiędzy emisją impulsu a odebraniem odbitego światła. Znając prędkość światła – około 3×108 m/s, z czasu przelotu impulsu wyliczyć można odległość. Aby generować dane o relatywnie niewielkich odległościach, potrzebny jest niezwykle precyzyjny sprzęt – na pokonanie odległości jednego metra światło potrzebuje zaledwie ok. 3 nanosekund. Schemat budowy typowego systemu LIDAR pokazano na rysunku 3.

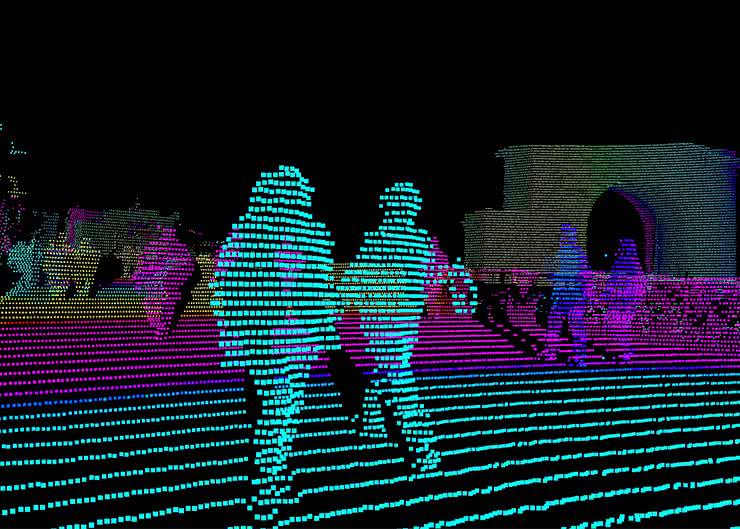

Aby utworzyć kompletne chmury punktów – mapę odległości – LIDAR musi próbkować w wielu kierunkach dookoła siebie. Aby możliwe było szybkie badanie całego środowiska, koniecznie jest wykorzystanie bardzo wysokiej częstotliwości próbkowania na poszczególnych emiterach i odbiornikach. Każdy z nich emituje dziesiątki lub setki tysięcy impulsów laserowych na sekundę. Oznacza to, że w ciągu 1 sekundy możliwe jest zbadanie odległości 100 tysięcy punktów. Duże systemy LIDAR mają wiele kanałów pomiarowych, złożonych z par nadajnik-odbiornik. Dzięki wielu kanałom system generuje ponad milion punktów danych na sekundę.

Jednak nawet wiele stacjonarnych kanałów to za mało, aby odwzorować całe otoczenie. Mogą one dać wystarczającą rozdzielczość, ale na niewielkim wycinku otoczenia. Aby było możliwe mapowanie całego środowiska, potrzeba ich dużo więcej. Niestety, zwiększanie liczby kanałów jest nieopłacalne i niepotrzebne zwiększa koszty systemu. Zamiast tego, wiele systemów LIDAR wykorzystuje obrotowe zespoły lub obracające się lustra, aby umożliwić kanałom omiatanie wiązkami całego otoczenia. Typowe strategie obejmują przechylanie każdego z emiterów i odbiorników powyżej lub poniżej poziomu, aby pokryć większą część środowiska w polu widzenia laserów. Na przykład 64-kanałowy system firmy Velodyne ma pionowe pole widzenia o kącie 26,8° i poziome pole widzenia równe pełnemu obrotowi. Dzięki temu z odległości 50 metrów LIDAR ten może zobaczyć szczyt obiektu o wysokości 12 metrów. Moduł pokazano na fotografii 1.

LIDAR-y są obecnie jednymi z najszerzej stosowanych systemów do analizy otoczenia. Ich głównymi wadami jest złożoność mechaniczna układów skanujących, co przekłada się na ograniczenia parametrów, a także miejsc, gdzie można je stosować.

Systemy pomiaru czasu przelotu w 3D

Systemy trójwymiarowego pomiaru czasu przelotu (3D ToF) to rodzaj LIDAR-u bez mechanicznego skanera, który również wykorzystuje impulsy optyczne o czasie trwania rzędu nanosekund do zbierania informacji o głębi i przestrzeni (zwykle na krótkich dystansach).

Kamera ToF mierzy odległość, aktywnie oświetlając obiekt za pomocą modulowanego źródła światła, takiego jak laser i czujnik, który jest czuły na światło o długości fali używanego lasera. Sensor ten wychwytuje odbite światło i mierzy opóźnienie czasowe pomiędzy wyemitowaniem impulsu a odebraniem go przez macierz sensorów. Opóźnienie czasowe jest proporcjonalne do dwukrotności odległości między kamerą a obiektem, podobnie jak w przypadku LIDAR-u.

Analogicznie, odległość tę można wyznaczyć, znając prędkość światła. Wystarczy znajomość czasu ∆T.

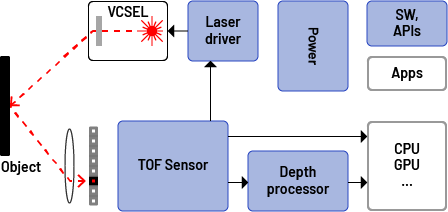

Istnieją różne metody pomiaru ∆T, z których dwie obecnie stały się najbardziej rozpowszechnione: metoda fali ciągłej (CW) i metoda impulsowa. Należy zauważyć, że zdecydowana większość systemów CW ToF, które zostały wdrożone i są obecnie na rynku, wykorzystuje czujniki CMOS, podczas gdy systemy impulsowe ToF wykorzystują czujniki inne niż CMOS (zazwyczaj macierze CCD). Na rysunku 4 pokazano przykładowy schemat blokowy tego rodzaju urządzenia.

Kamery 3D ToF często łączone są z klasycznymi kamerami operującymi w pasmie widzialnym. Przykład takiego urządzenia pokazano na fotografii 2. Moduł ten jest oparty na torze sygnałowym 3D ToF oferowanym przez firmę Analog Devices. Integruje w sobie dwie matryce – głębi o rozdzielczości 640×480 oraz do obrazowania o rozdzielczości 1920×1080. Wbudowany w system procesor zapewnia fuzję i synchronizację obu obrazów, co pozwala na podgląd danych 3D w systemie. Moduł wyposażony jest w interfejs USB, pozwalający na komunikację z komputerami wbudowanymi itp.

Widzenie maszynowe

Ostatnim, wartym omówienia, systemem, zapewniającym robotom wzrok, są oczywiście kamery wizyjne. Nie są to jednak zwykłe kamery, tylko całe złożone systemy tzw. widzenia maszynowego. Definiuje się to jako zdolność urządzenia do postrzegania i rozumienia swojego otoczenia – na ogół w sposób podobny jak człowiek, ale kamery mogą wykrywać zakres długości fal znacznie szerszy niż w przypadku człowieka. W niektórych systemach widzenia maszynowego używa się systemów wizyjnych działających w zakresie podczerwieni, ultrafioletu czy nawet promieniowania rentgenowskiego.

Niezwykle istotnym elementem systemu widzenia maszynowego, oprócz samych sensorów obrazu, jest jego przetwarzanie. Termin widzenie maszynowe jest używany do określenia technologii, w której komputer nie tylko digitalizuje obraz, ale też go przetwarza i podejmuje określone działania na podstawie otrzymanych wniosków.

Współcześnie, do przetwarzania obrazów bardzo często stosuje się algorytm uczenia maszynowego, który jest elementem sztucznej inteligencji. Taki system jest w stanie ulepszać swoje działanie poprzez doświadczenia – zupełnie jak ludzie. Systemy widzenia maszynowego obecnie korzystają z algorytmów uczących się – dostarcza się im zestaw danych o tym, np. jak wygląda jakiś obiekt, aby były w stanie go rozpoznawać na obrazie. Zaawansowane algorytmy widzenia maszynowego są w stanie rozpoznawać ludzi, zwierzęta, rowerzystów czy samochody na obrazie i śledzić ich ruch niemalże w czasie rzeczywistym. Systemy tego rodzaju często stosuje się obecnie w samochodach, także tych starających się o pewien stopień autonomii, do rozpoznawania otoczenia.

Oprócz obserwacji otoczenia systemy widzenia maszynowego mają obecnie kilka innych zastosowań. Używane są do wizualnej kontroli i zarządzania materiałami, pozwalają na odczyt kodów kreskowych czy ocenę produktów na różnych etapach procesu produkcji. Nawet producenci żywności i napojów stosują systemy wizyjne do monitorowania jakości. W medycynie systemy widzenia maszynowego są wykorzystywane w obrazowaniu medycznym i procedurach badawczych.

Podsumowanie

Na rynku jest obecnie dostępnych wiele systemów zapewniających robotom i innym systemom świadomość przestrzeni dookoła nich. W wielu rozwiązaniach stosuje się je wspólnie, łącząc je i wykorzystując tzw. fuzję sensorów do uzyskania optymalnych dla danej aplikacji rozwiązań.

Nikodem Czechowski, EP

Źródła:

Zaloguj

Zaloguj