Dogłębne zrozumienie niuansów środowiska pracy elektroniki kosmicznej stanowi podstawę merytorycznego arsenału każdego inżyniera aspirującego do branży space. Zdajemy sobie sprawę, że kompleksowe omówienie całości zagadnień w ramach pojedynczego artykułu jest całkowicie niewykonalne – dość powiedzieć, że na temat wpływu samego tylko promieniowania kosmicznego na elektronikę powstały całkiem obszerne monografie, silnie bazujące na fizyce ciała stałego – dlatego postaramy się pokrótce zasygnalizować wyłącznie najważniejsze zagadnienia, z jakimi na co dzień mierzą się inżynierowie kosmiczni.

Zasięg misji – rodzaje orbit okołoziemskich

Jednym z najistotniejszych założeń każdej misji kosmicznej jest jej zasięg. O ile przedsięwzięcia nakierowane na przestrzeń międzygwiezdną są naprawdę rzadkie – jak dotąd wysłano w kosmos zaledwie pięć sond które wleciały lub za pewien czas wlecą w tak daleki dla nas obszar kosmosu (Voyager 1, Voyager 2, Pioneer 10, Pioneer 11 oraz New Horizons – fotografia 1), o tyle zdecydowanie więcej satelitów i próbników znajduje się w obszarze Układu Słonecznego.

Bogata historia lotów mających na celu badanie Słońca, Księżyca, a także pozostałych planet Układu wraz z ich księżycami stanowi jednak – pod względem liczbowym – zaledwie niewielki ułamek wszystkich misji związanych z umieszczeniem sztucznych satelitów na orbitach okołoziemskich. W zależności od odległości, mierzonej od powierzchni Ziemi, mówimy o następujących rodzajach orbit:

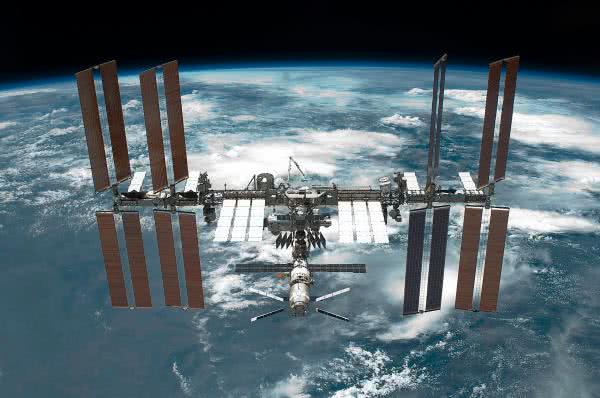

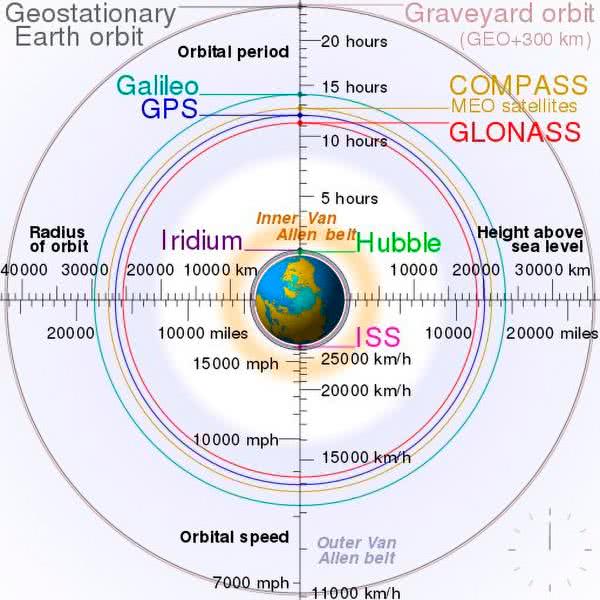

- LEO (Low Earth Orbit) – niska orbita okołoziemska; obejmuje orbity o wysokości w zakresie od 160 km do 1000 km nad powierzchnią Ziemi, choć w zależności od źródła można znaleźć także wartości krańcowe odpowiednio 200…300 km i 1600…2000 km. Warto dodać, że niezależnie od umownych granic, cała przestrzeń LEO leży już powyżej tzw. linii Kármána, która – przebiegając na wysokości 100 km nad poziomem morza – stanowi umowną granicę pomiędzy atmosferą ziemską, a przestrzenią kosmiczną. Sztuczne satelity umieszczone we wspomnianym obszarze (czyli zdecydowana większość tego typu urządzeń) są mimo wszystko narażone na opory aerodynamiczne, które – pomimo znacznego rozrzedzenia cząstek gazów w jonosferze – są w stanie doprowadzić do deorbitacji satelity w ciągu (zazwyczaj) kilku lat od momentu jego wystrzelenia. Okres orbitalny (tj. czas, w którym ciało na danej wysokości przelatuje jedno pełne okrążenie dookoła Ziemi) nie przekracza 90…128 minut, co sprawia, że satelita wykonuje około 11…16 obiegów naszej planety w ciągu jednej doby. Czas widoczności nad horyzontem waha się przy tym od około 5 do 20 minut (zależnie od orbity). Dokładna znajomość okresu orbitalnego jest zatem ważna m.in. dla ustalenia okien czasowych, w których możliwa jest komunikacja z sondą za pomocą stacji naziemnych. Warto też dodać, że w obszarze LEO znajduje się także Międzynarodowa Stacja Kosmiczna (ISS – fotografia 2), umieszczona na orbicie o wysokości około 430 km nad powierzchnią Ziemi, jak również słynny Kosmiczny Teleskop Hubble’a (około 530 km).

Umieszczenie satelitów na niskiej orbicie okołoziemskiej niesie ze sobą szereg korzyści: niższe wymagania związane z mocą nadawania (rzędu 500 mW) i wymaganą czułością odbiorników telekomunikacyjnych, mniejsze koszty wyniesienia w przestrzeń kosmiczną i łatwiejsze obrazowanie (stosunkowo niewielkich) obszarów powierzchni Ziemi z użyciem konwencjonalnej optyki to jedne z najważniejszych zalet LEO w odniesieniu do projektów satelitarnych. Spore znaczenie użytkowe ma też niewielkie opóźnienie w propagacji sygnałów radiowych (do kilku milisekund). Z drugiej zaś strony, intensywna eksploatacja niskiej orbity okołoziemskiej wiąże się z rosnącą lawinowo ilością kosmicznych odpadów, co stanowi obecnie jeden z najszerzej dyskutowanych problemów współczesnej inżynierii kosmicznej.

- MEO (Medium Earth Orbit) – średnia orbita okołoziemska: mianem tym określa się przestrzeń wokół naszej planety, rozciągającą się pomiędzy górną granicą LEO, a orbitą geostacjonarną, czyli od około 2000 km do 35786 km na poziomem morza. W obszarze MEO pracują przede wszystkim satelity systemów nawigacyjnych GPS, GLONASS, BeiDou oraz Galileo.

- GEO (Geostationary Earth Orbit) – orbita geostacjonarna – w przeciwieństwie do opisanych wcześniej LEO i MEO – nie obejmuje szerokiego zakresu wysokości nad powierzchnią Ziemi, ale jedną, ściśle określoną. Wyniesienie satelity na wysokość wspomnianych już wcześniej 35786 km n.p.m. umożliwia uzyskanie pełnego synchronizmu ruchu statku kosmicznego z częstotliwością obrotu Ziemi wokół własnej osi; dzięki temu, zgodnie z nazwą, satelita znajdujący się na orbicie geostacjonarnej pozostaje cały czas nad tym samym punktem Ziemi (leżącym na równiku). Dokładny okres orbitalny dla GEO to 23 godziny 56 minut i 4 sekundy (tzw. doba gwiazdowa).

Orbita GEO jest zajmowana głównie przez satelity telekomunikacyjne i meteorologiczne, a to dzięki możliwości nawiązywania stałej łączności z użyciem anteny kierunkowej, wycelowanej ze stacji naziemnej w stronę satelity. Wadą zastosowania GEO jest natomiast znacznie większa odległość, która wymusza stosowanie czulszych odbiorników i nadajników o wyższej mocy, w porównaniu do satelitów pracujących na LEO i MEO. Co ważne, GEO jest szczególnym przypadkiem tzw. orbity geosynchronicznej (GSO) – obiekty znajdujące się na niej także obiegają Ziemię w rytmie zgodnym z dobą gwiazdową, mogą jednak mieć inną inklinację [1] i ekscentryczność [2].

Warto dodać także, że 300 km nad GEO znajduje się tzw. orbita cmentarna (graveyard orbit), wyznaczona arbitralnie jako miejsce docelowego „spoczynku” satelitów, które zakończyły już swoją misję. Międzynarodowy Komitet IASDC (Inter-Agency Space Debris Coordination Committee), zrzeszający największe światowe agencje kosmiczne (amerykańską NASA, europejską ESA, japońską JAXA, rosyjską ROSCOSMOS i in.) w celu zaradzenia problemowi kosmicznych śmieci, opracował wytyczne dotyczące bezpiecznej i kontrolowanej utylizacji „zużytego” sprzętu kosmicznego. W myśl zaleceń, satelity powinny albo zdeorbitować i spłonąć w atmosferze (w przypadku LEO), albo udać się na wyższą orbitę cmentarną i pozostać tam w celu ochrony innych statków kosmicznych przed potencjalną kolizją. Choć problem zderzenia dwóch sztucznych satelitów wydaje się być dość groteskowy (biorąc pod uwagę aktualny stopień zaawansowania zarówno statków kosmicznych, jak i metod zarządzania oraz śledzenia ich ruchu), w rzeczywistości takie wypadki miały już miejsce w historii inżynierii kosmicznej – głośnym echem odbiła się w mediach kolizja satelitów: telekomunikacyjnego Iridium 33 oraz nieczynnego już, wojskowego Kosmos 2251, która miała miejsce 10 lutego 2009 roku. Rzecz jasna, przy prędkości zderzenia rzędu ponad 11 km/s obydwa urządzenia uległy całkowitej zagładzie, co spowodowało czasowe ograniczenia w dostępności usług telefonii satelitarnej obsługiwanej przez konstelację Iridium.

Schematyczne zobrazowanie wzajemnego położenia poszczególnych orbit okołoziemskich zaprezentowano na rysunku 1.

Normy dotyczące techniki kosmicznej

Dobrym punktem wyjścia do rozważań nad zagadnieniami branży space są materiały udostępnione przez agencję NASA na stronie https://go.nasa.gov/3HXfS11. Znajdujemy tam jedenaście kategorii norm dotyczących wszystkich obszarów techniki kosmicznej:

- 0000 – Documentation and Configuration,

- 1000 – Systems Engineering and Integration, Aerospace Environments, Celestial Mechanics,

- 2000 – Computer Systems, Software, Information Systems,

- 3000 – Human Factors and Health,

- 4000 – Electrical and Electronics Systems, Avionics/Control Systems, Optics,

- 5000 – Structures/Mechanical Systems, Fluid Dynamics, Thermal, Propulsion, Aerodynamics,

- 6000 – Materials and Processes, Parts,

- 7000 – System and Subsystem Test, Analysis, Modeling, Evaluation,

- 8000 – Safety, Quality, Reliability, Maintainability,

- 9000 – Operations, Command, Control, Telemetry/Data Systems, Communications,

- 10000 – Construction and Institutional Support.

Dla nas – elektroników – szczególnie interesujące są kategorie 4000 (elektronika, systemy sterowania, optyka), 7000 (metody testowania systemów i podsystemów), 8000 (zagadnienia bezpieczeństwa, jakości, niezawodności i utrzymywalności) oraz 9000 (telekomunikacja [3]).

Analogiczną listę norm opracowała także powiązana z ESA organizacja normalizacyjna ECSS (European Cooperation for Space Standardization) – pełną listę aktywnych standardów można znaleźć pod adresem https://ecss.nl/standards/active-standards/. Warto zwrócić uwagę na dokumenty oznaczone numerami:

- ECSS-E-ST-20C Rev.2 – Electrical and electronic,

- ECSS-Q-ST-70-12C – Design rules for printed circuit boards,

- ECSS-Q-ST-70-60C Corrigendum 1 – Qualification and procurement of printed circuit boards,

- ECSS-Q-ST-70-28C – Repair and modification of printed circuit board assemblies for space use,

- ECSS-Q-ST-60C Rev.3 – Electrical, electronic and electromechanical (EEE) components,

- ECSS-Q-ST-60-13C Rev.1 – Commercial electrical, electronic and electromechanical (EEE) components,

- ECSS-Q-ST-60-02C – ASIC and FPGA development.

Organizacja ISO również opracowała normy dotyczące testowania aparatury kosmicznej – zagadnienia branży space, jak i lotnictwa, mieszczą się w kategorii 49 klasyfikacji ICS, zaś bardzo szeroka podkategoria 49.140 o nazwie Space systems and operations obejmuje obecnie przeszło 270 obowiązujących standardów (i prawie 30 kolejnych w trakcie opracowywania). Szczególnie interesujące dla twórców małych satelitów są normy:

- ISO 19683:2017 – Space systems – Design qualification and acceptance tests of small spacecraft and units – dokument obejmuje minimalne wymagania dotyczące testów kwalifikacyjnych i akceptacyjnych małych statków kosmicznych oraz ich podsystemów, w szczególności zaś taktuje o mini-, mikro-, nano- i pikosatelitach, wprost odwołuje się też do klasy określanej jako CubeSat (więcej informacji na ten temat można znaleźć w artykule pt. Elektronika w przestrzeni kosmicznej – nowe podejście do branży Space).

- ISO 15864:2021 – Space systems – General test methods for space craft, subsystems and units – norma obejmuje podstawowe zagadnienia testowania podsystemów bezzałogowych sond i satelitów, któremu poddawane są gotowe elementy statków kosmicznych (tj. po zakończeniu procesu projektowania).

Warunki pracy elektroniki kosmicznej

Najistotniejszą częścią przygotowania statków kosmicznych do ich wystrzelenia są skrupulatne, w większości bardzo obciążające dla konstrukcji pojazdu oraz zainstalowanych na jego pokładzie podsystemów elektronicznych, testy środowiskowe. Praktyka pokazuje, że ogromne przeciążenia termiczne, mechaniczne, wibracyjne oraz narażenia na wysokoenergetyczne promieniowanie kosmiczne, są w stanie szybko i nieodwracalnie uszkodzić zarówno precyzyjną elektronikę, jak i elementy poszycia, uszczelnień czy też konstrukcji satelitów, sond i rakiet nośnych. Dlatego też tak ważne jest zrozumienie najważniejszych zjawisk, z którymi mają do czynienia układy elektroniczne w branży space.

Wibroakustyka

Zbytnim uproszczeniem byłoby stwierdzenie, że narażenie elektroniki na nieprzyjazne warunki środowiskowe ma miejsce tylko podczas orbitowania lub przemieszczania się w odległe zakątki przestrzeni kosmicznej. Paradoksalnie, znaczna część trudności wiąże się z etapem wynoszenia aparatury za pomocą rakiet nośnych – zarówno w momencie startu, jak i podczas przelotu przez kolejne warstwy atmosfery. Za powstawanie potencjalnie niszczących, bardzo silnych i – co gorsza – szerokopasmowych drgań, odpowiedzialne są zarówno wibracje przenoszone (przez konstrukcję statku i mocowania ładunku, np. satelity) dalej do elektroniki pokładowej, jak i efekty akustyczne, związane ze startem i dalszą pracą silnika, turbulencjami powietrza wokół rakiety oraz licznymi efektami rezonansowymi potęgowanymi dodatkowo przez konstrukcję samej rakiety czy też pobliskich elementów stanowiska startowego. Nie wolno także zaniedbywać roli wstrząsów powstających podczas oddzielania kolejnych członów rakiety nośnej czy też uwalniania satelitów w przestrzeń kosmiczną. Stąd też pojawia się konieczność wykonywania skrupulatnych testów:

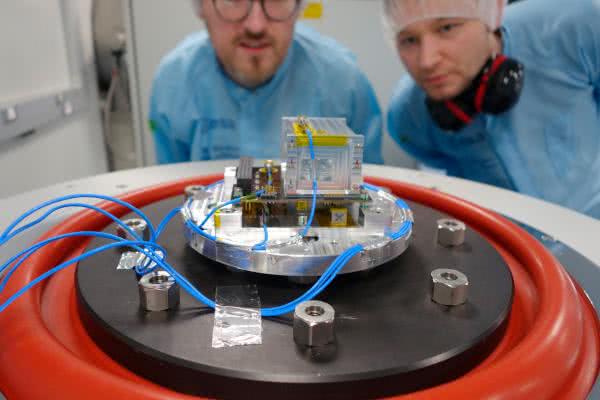

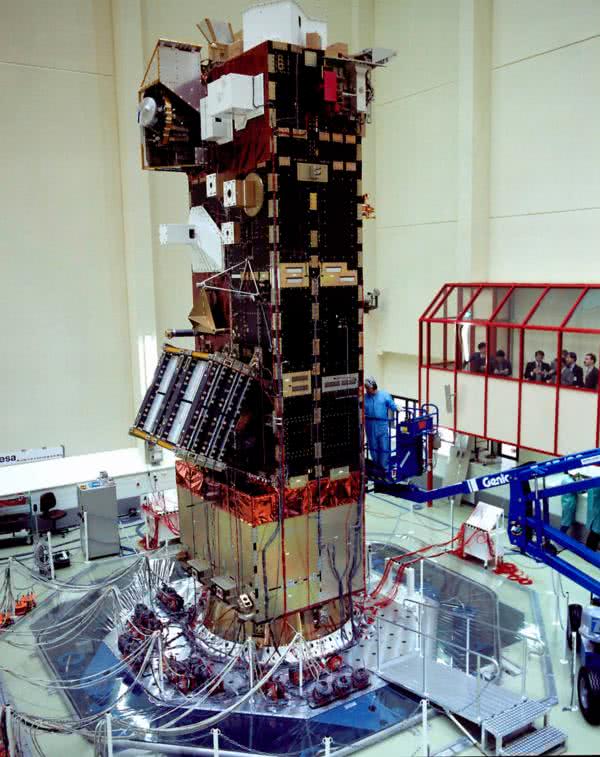

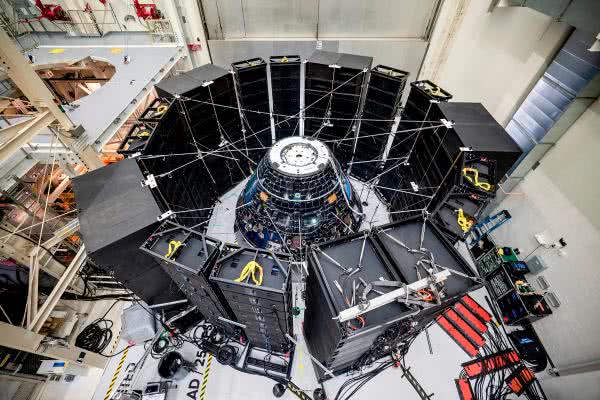

- wibracyjnych – za pomocą wytrząsarek z pobudzeniem sinusoidalnym, udarowym oraz losowym, w których do drgającej podstawy metalowej zamocowane są badane elementy statku kosmicznego (fotografia 3) lub nawet całość konstrukcji (np. kompletny satelita bądź sonda kosmiczna – fotografia 4),

- wibroakustycznych – poprzez ekspozycję badanego obiektu na silne fale dźwiękowe o częstotliwości od 25 Hz do 10 kHz i poziomie natężenia przekraczającym 150...160 dB (fotografia 5).

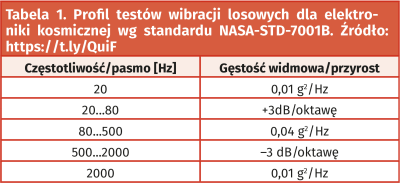

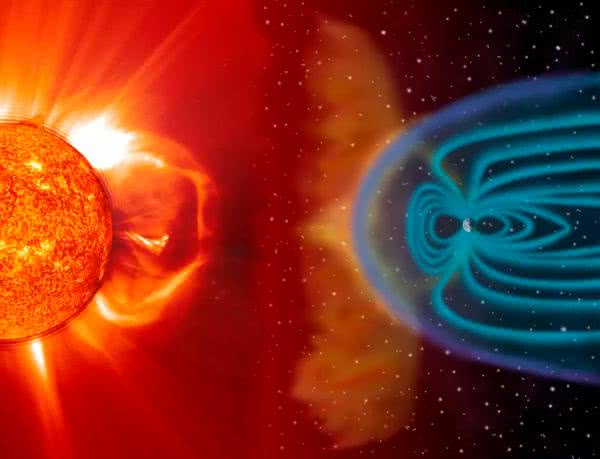

Co ważne, w przypadku testów wibracyjnych o charakterystyce losowej (Random Vibration Test) określa się widmową gęstość mocy [g²/Hz] dla poszczególnych przedziałów pasma. Przykładowy profil badania pod kątem potencjalnych słabych punktów w montażu podzespołów elektronicznych, elektrycznych lub elektromechanicznych, zaczerpnięty ze standardu NASA-STD-7001B, pokazano w tabeli 1.

Lewa kolumna określa częstotliwość lub zakres pasma, zaś prawa – gęstość widmową lub (w przypadku przedziału pasma) – zalecane nachylenie charakterystyki w funkcji częstotliwości (rysunek 2). Warto dodać, że standard określa wartość skuteczną poziomu drgań jako 6,8 gRMS. Co ważne, opisana powyżej obwiednia drgań powinna być stosowana do komponentów i podsystemów o masie poniżej 50 kg, jednak – z uwagi na ryzyko uszkodzenia – nie zaleca się przeprowadzania takich prób na delikatnej optyce bądź czujnikach, dla których test wiązałby się z nieodwracalnym zniszczeniem. Parametry zmieniają się też zależnie od rodzaju badania – przykładowo, testy w fazie kwalifikacyjnej powinny trwać 2 minuty (dla każdej z osi osobno), podobnie zresztą jak badania akustyczne.

Oprócz opisanych wyżej badań wibracyjnych z użyciem pobudzeń przypadkowych, w użyciu są także metody testów modalnych, mające na celu określenie częstotliwości rezonansowych konstrukcji. Stąd też laboratoria zajmujące się sprawdzaniem odporności na narażenia mechaniczne oferują testy z użyciem pobudzenia sinusoidalnego z przemiataniem częstotliwości (chirp) oraz pobudzenia udarowego (za pomocą specjalnego młota). Część testów może być ponadto wykonywana w komorach klimatycznych, co pozwala rozszerzyć procedury o aspekt termiczny.

Wśród standardów ISO także można znaleźć normy dotyczące testów wibroakustycznych – dla zainteresowanych Czytelników podajemy numery odpowiednich dokumentów.

- ISO 23670:2021 – Space systems – Vibration testing,

- ISO 19924:2017 – Space systems – Acoustic testing.

Warto dodać, że – choć niszczące wibracje są, jak już wcześniej wspomnieliśmy, powiązane ze startem rakiety nośnej oraz etapem wynoszenia statku kosmicznego na orbitę – to w otwartej przestrzeni kosmicznej należy również liczyć się z (wprawdzie nieporównanie mniejszymi) drganiami, spowodowanymi jednak głównie cykliczną zmiennością temperatur (o której za chwilę). Silne wibracje są także związane z powrotem na Ziemię (lądowaniem), co ma miejsce w przypadku lotów załogowych (dawniej realizowanych w dużej mierze za pomocą wahadłowców, dziś – kapsuł powrotnych).

Temperatura

Jednym z kluczowych czynników środowiskowych, które należy rozpatrywać projektując aparaturę kosmiczną, jest temperatura. Zakres temperatur niezbędny do uwzględnienia w przypadku zarówno satelitów krążących po orbitach okołoziemskich, jak i sond kosmicznych wysyłanych w kierunku Słońca lub odległych planet, okazuje się znacznie szerszy, niż w przypadku jakiegokolwiek systemu pracującego na Ziemi – stąd pojawia się konieczność zastosowania nie tylko odpowiednio wytrzymałych komponentów i materiałów, ale także rozmaitych technik projektowych oraz metod zarządzania przebiegiem misji na każdym jej etapie.

W przypadku sztucznych satelitów Księżyca, Ziemi bądź innych planet Układu Słonecznego, zakres zmienności temperatur – spowodowany cyklicznym przelotem przez obszar nasłoneczniony oraz ocieniony okrążanego ciała niebieskiego – zależy zarówno od odległości od Słońca, jak i szeregu innych efektów. Pod uwagę należy zatem brać również wpływ ewentualnej atmosfery, efekt promieniowania odbitego od powierzchni okrążanego obiektu, jak i jego własne promieniowanie termiczne (podczerwone). W przypadku najintensywniej eksploatowanej, niskiej orbity okołoziemskiej zakres temperatur wynosi od –150°C do +60°C, choć rozmaite źródła podają zupełnie odmienne wartości, przykładowo: od –170°C do +123°C lub od –65°C to +125°C. Diametralnie inna sytuacja panuje na orbicie geostacjonarnej – o ile warunki pracy przez większość czasu pozostają zbliżone do górnego przedziału temperatur dla LEO, to dwa razy w ciągu roku, przez czas rzędu 45 dni, satelita znajduje się w cieniu Ziemi – co powoduje znaczny spadek temperatury, ale znacząco utrudnia też zarządzanie zasilaniem aparatury (z uwagi na brak możliwości ciągłego doładowywania akumulatorów przez ogniwa słoneczne).

Niezwykle istotnym aspektem projektowania urządzeń kosmicznych jest odpowiednie zarządzanie przepływem ciepła. Z uwagi na wysoką próżnię panującą w górnych warstwach termosfery, jak i – tym bardziej – w otwartej przestrzeni kosmicznej, nie można liczyć na możliwość odprowadzania ciepła z elektroniki pokładowej przez zjawisko konwekcji. Pozostaje zatem głównie pasywne chłodzenie poprzez przewodzenie oraz promieniowanie. O ile większe statki kosmiczne mogą korzystać z zaawansowanych, aktywnych systemów termoregulacyjnych (chłodzenie kriogeniczne i termoelektryczne, zamknięte systemy chłodzenia cieczą, grzałki elektryczne i radioizotopowe, itd.), to w przypadku małych satelitów (np. CubeSatów) tego typu rozwiązania nie wchodzą w grę zarówno ze względu na ograniczenia masowe i wymiarowe, jak i bilans mocy podsystemu zasilania.

Między innymi z tego powodu tak ważne jest stosowanie odpowiednich osłon termicznych, wykonanych ze specjalnej, wielowarstwowej folii wzmacnianej siatką polimerową (fotografia 6). Tego typu „koc termiczny” nosi nazwę Multi-layer Insulation (MLI) i jest szeroko stosowany w niemal wszystkich rodzajach satelitów oraz sond kosmicznych. Dzięki metalizacji warstwami aluminium możliwe jest także uzyskanie efektu dość szczelnego ekranowania, co doskonale widać np. na przykładzie sondy Cassini (fotografia 7), w której 24-warstwowe (!) pokrycia termiczne zawierały – oprócz metalu – także szereg innych materiałów (Kapton, Mylar czy Dacron), zaś każda warstwa przewodząca została solidnie uziemiona w celu przeciwdziałania powstawaniu łuków elektrycznych podczas przelotu przez pasy radiacyjne Ziemi oraz Saturna. Co więcej – jak to zwykle bywa w branży kosmicznej – nawet tak pozornie drobny szczegół konstrukcyjny był przedmiotem obszernych badań i wielokrotnych ulepszeń.

Przykładowo, specjalna siatka wewnątrz „koców termicznych” ma za zadanie nie tylko wzmocnić całość pod względem mechanicznym, ale także – wraz z otworami w poszczególnych warstwach (fotografia 8) – ułatwić przepływ powietrza podczas startu w celu zapobieżenia przypadkowej perforacji.

Ważnym aspektem jest także dostosowanie przebiegu misji do warunków termicznych – przykładowo, nanosatelita na LEO, który nie jest w stanie pracować w temperaturach poniżej kilkudziesięciu stopni Celsjusza, może wykorzystać „ciepłą” część okresu orbitalnego na wykonywanie eksperymentów, komunikację ze stacjami naziemnymi i wszelkie inne procedury przewidziane programem misji, zaś na czas przelotu przez ocienioną stronę Ziemi przejść w tryb obniżonego poboru mocy.

Promieniowanie kosmiczne

Elektronika kosmiczna jest narażona na silne dawki promieniowania kosmicznego, pochodzącego zarówno z najbliższej nam gwiazdy, jak i z odległych galaktyk. Co więcej – o ile ilość cząstek o najwyższych rejestrowanych energiach (nawet rzędu bilionów MeV!), pochodzących z dalekich obszarów Wszechświata, jest stosunkowo niewielka, to za nieporównanie wyższą gęstość mocy odpowiada właśnie promieniowanie pochodzące od Słońca.

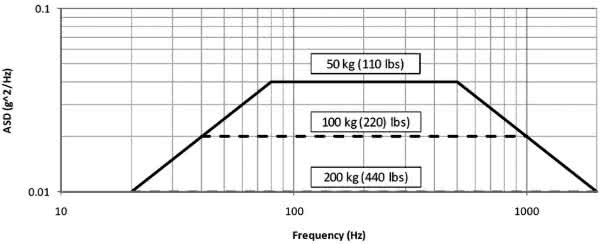

Słońce jest źródłem szeregu efektów, związanych z emisją promieniowania elektromagnetycznego oraz silnie przyspieszonych cząstek. O ile tzw. wiatr słoneczny (rysunek 3) – strumień relatywnie niskoenergetycznej plazmy opuszczającej Słońce – przeważnie jest znacznie słabiej odczuwalny przez aparaturę kosmiczną, to rozbłyski słoneczne i zdarzenia określane mianem CME (Coronal Mass Ejection – koronalny wyrzut masy) wiążą się z wyrzucaniem ogromnych ilości materii o bardzo wysokiej energii kinetycznej, zdolnej do uszkodzenia aparatury.

Sytuację dodatkowo komplikuje obecność atmosfery – o ile warstwy powietrza znajdujące się nad powierzchnią Ziemi skutecznie chronią nas (oraz ziemską aparaturę) przed cząstkami wysokoenergetycznymi i twardym promieniowaniem UV, o tyle w połączeniu z rozpędzonymi nukleonami bądź fotonami ultrafioletu o wysokiej energii ulegają one zjonizowaniu. To zaś powoduje utrzymywanie się plazmy w jonosferze oraz powstawanie tzw. wtórnego promieniowania kosmicznego.

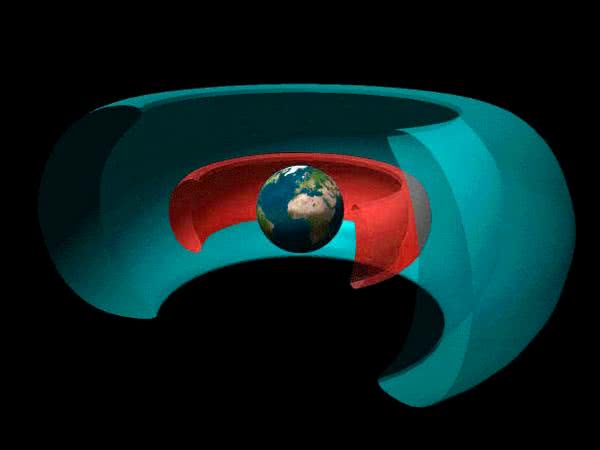

Zagadnieniem istotnym dla planowania przebiegu misji kosmicznych są tzw. pasy Van Allena – toroidalne chmury cząstek, które w wyniku działania ziemskiego pola magnetycznego zostały „uwięzione” wokół naszej planety (rysunek 4). Wewnętrzny pas Van Allena, znajdujący się na wysokości około 1200...6000 km nad powierzchnią Ziemi, zawiera głównie protony o energii ok. 10 MeV i elektrony o energii 1…5 MeV, zaś zewnętrzny – „umieszczony” w rejonie około 13000...60000 km n.p.m. składa się przede wszystkim z elektronów o energiach rzędu 10...100 MeV i jest bardzo podatny na aktywność słoneczną [4]. Obecność pasów została wstępnie potwierdzona już w ramach misji pierwszego amerykańskiego sztucznego satelity okołoziemskiego o nazwie Explorer-1, wystrzelonego w przestrzeń kosmiczną w 1958 roku.

Wtórnym źródłem promieniowania jonizującego może być także… sama struktura urządzeń zainstalowanych na pokładzie statku kosmicznego – przykładowo, niskoenergetyczne neutrony uderzające w atom boru 10B mogą doprowadzić do rozpadu promieniotwórczego, w efekcie którego powstanie cząstka alfa o energii 1,47 MeV i 840-kiloelektronowoltowy foton gamma – te zaś bez większego problemu są w stanie zaburzyć pracę układów scalonych, powodując np. przekłamania wartości bitów w pamięci. Co ważne – wbrew pozorom problem jest naprawdę spory, gdyż szkło na bazie boru (BPSG – boron-doped phosphosilicate glass) stanowi jeden z głównych surowców stosowanych w konwencjonalnym przemyśle półprzewodnikowym.

Wpływ promieniowania jonizującego na układy elektroniczne

Promieniowanie jonizujące, czyli (w przypadku branży space) także promieniowanie kosmiczne, oddziałuje na układy półprzewodnikowe na drodze rozmaitych mechanizmów, których podłoża należy szukać na poziomie fizyki ciała stałego. Ogólnie rzecz ujmując, mamy do czynienia z trzema podstawowymi grupami efektów:

- uszkodzenia spowodowane przyjętą dawką całkowitą (dose-effect),

- uszkodzenia spowodowane przyjęciem dużej dawki w krótkim czasie (dose-rate effect),

- uszkodzenia i tymczasowe efekty jednostkowe (single-event-effect).

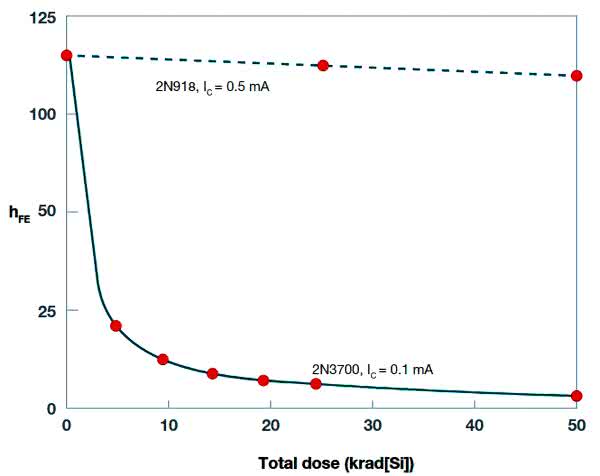

W przypadku efektów zależnych od całkowitej dawki pochłoniętej promieniowania jonizującego [5] (TID – Total Ionising Dose) mamy do czynienia ze zmianami na poziomie struktury półprzewodnikowej elementów dyskretnych lub układów scalonych, narastającymi podczas ekspozycji na promieniowanie. Proces ten odbywa się na drodze generowania, transportu oraz pułapkowania dziur w obszarach bramek tranzystorów polowych oraz tlenkowych warstw izolacyjnych. Zmiany te doprowadzają do istotnej zmiany parametrów pracy, a w skrajnych przypadkach – nawet do nieodwracalnego uszkodzenia układu. W komponentach wykonanych w technologii bipolarnej często spotykanym efektem pochłonięcia odpowiednio dużej dawki TID jest redukcja (nierzadko drastyczna) współczynnika wzmocnienia prądowego (hFE). Przykładowy wykres zależności hFE od dawki pokazano na rysunku 5.

Układy bazujące na strukturach polowych wykazują natomiast tendencje do wzrostu wartości prądu upływu, co przekłada się z kolei na stopniowe zwiększanie statycznego poboru mocy urządzenia. W skrajnym przypadku prowadzi to do nieodwracalnej awarii – po silnej ekspozycji całkowite wyłączenie tranzystora może wszak okazać się niemożliwe. Warto dodać – że wbrew pozorom – niektóre efekty (np. wspomniany spadek wzmocnienia prądowego tranzystorów BJT) są znacznie bardziej prawdopodobne w przypadku powolnego pochłaniania określonej dawki TID przez strukturę (LDR – Low Dose Rate), niż po przyjęciu dokładnie takiej samej TID, ale w krótkim czasie (HDR – High Dose Rate).

Uszkodzenia elementów elektronicznych w wyniku działania efektów TID obejmują zatem m.in. [6]:

- przesunięcie napięcia progowego tranzystorów MOS,

- obniżenie szybkości przełączania układów CMOS,

- wzrost statycznego prądu zasilania struktur CMOS,

- obniżenie hFE tranzystorów bipolarnych,

- błędy funkcjonalne układów cyfrowych,

- zmiany offsetów napięciowych i prądowych układów analogowych,

- spadek wzmocnienia układów analogowych,

- zwiększenie prądu ciemnego matryc CCD.

Co ważne, rozmaite rodzaje promieniowania (fotony, neutrony, protony, elektrony czy też cząstki alfa) uruchamiają inne mechanizmy prowadzące do powstawania defektów struktury półprzewodnikowej. Objętościowe uszkodzenia strukturalne, określane mianem DD (displacement damage) występują głównie przy ekspozycji na działanie protonów i neutronów, a powstają w wyniku „wybicia” atomu ze struktury przez poruszającą się cząstkę. W wyniku zderzenia elastycznego powstaje defekt, przyczyniający się do trwałego pogorszenia parametrów półprzewodnika. Warto podkreślić, że – w odróżnieniu od opisanych wcześniej uszkodzeń TID – mówimy tutaj o efektach niezwiązanych z jonizującym charakterem promieniowania, ale z czysto „mechanicystycznym” uszkodzeniem sieci krystalicznej.

Do uszkodzeń spowodowanych efektem DD można zaliczyć:

- obniżenie hFE tranzystorów BJT,

- zwiększenie prądu upływu i napięcia przewodzenia diod krzemowych,

- zwiększenie prądu ciemnego oraz uszkodzenia pikseli i kolumn matryc CCD,

- zwiększenie prądu ciemnego oraz redukcja czułości fotodiod,

- obniżenie mocy wyjściowej diod LED oraz laserów półprzewodnikowych,

- obniżenie sprawności ogniw słonecznych (spadek prądu zwarcia, napięcia jałowego oraz mocy).

Praktyczna ilość i natężenie uszkodzeń typu TID oraz DD zależy w dużej mierze od obszaru przestrzeni kosmicznej, w którym pracuje dany statek kosmiczny. W przypadku sztucznych satelitów Ziemi znaczenie ma nie tylko wysokość i inklinacja orbity (m.in. ze względu na położenie względem pasów Van Allena), ale także czas trwania misji i sposób zabezpieczenia elektroniki (ekranowanie na poziomie obudowy, konstrukcji satelity, a nawet samych układów scalonych).

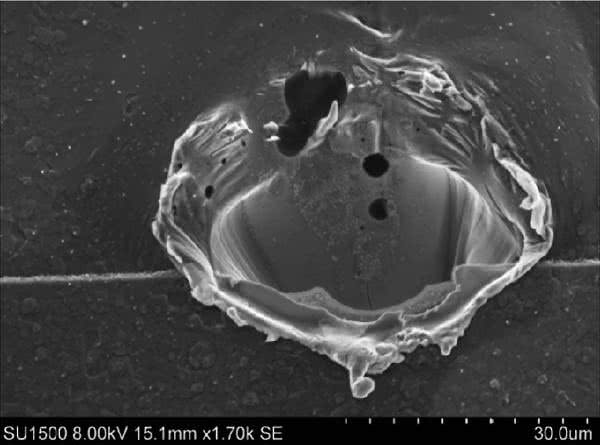

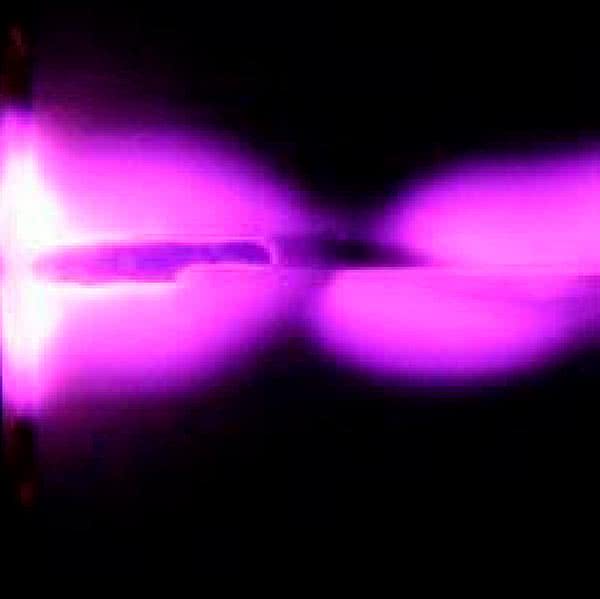

Bardzo szeroką grupą efektów są zdarzenia z grupy określanej mianem Single Event Effects (SEE). Jak sama nazwa wskazuje, wiążą się one z przejściem pojedynczej cząstki przez strukturę danego elementu (fotografia 9), zaś o praktycznym efekcie takiego zdarzenia decyduje zarówno rodzaj i energia cząstki, jak i typ komponentu oraz zastosowana w nim technologia półprzewodnikowa.

Wszystkie efekty z tej grupy możemy podzielić na dwie główne kategorie:

- zdarzenia niszczące – powodujące nieodwracalne uszkodzenie struktury półprzewodnikowej, a – co za tym idzie – nierzadko także innych elementów układu elektronicznego,

- zdarzenia nieniszczące – przejściowe zjawiska powodujące wprawdzie zaburzenie działania urządzenia, jednak nie prowadzące (przynajmniej w sposób bezpośredni) do jego uszkodzenia.

Pierwsza grupa zdarzeń obejmuje następujące podkategorie:

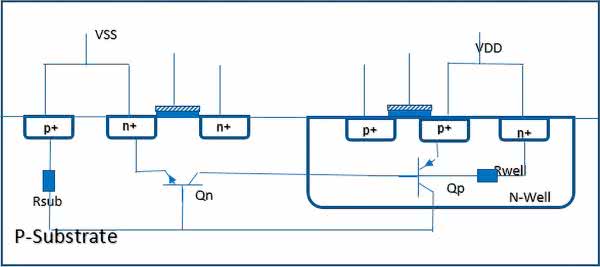

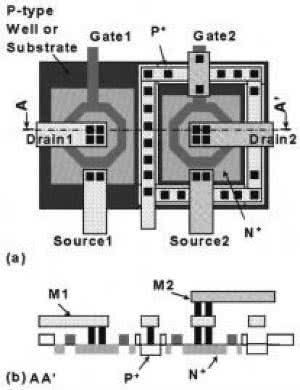

- SEL (Single Event Latchup) – dotyczy głównie układów wykonanych w technologiach CMOS oraz BiCMOS, gdyż układy bipolarne – zdecydowanie rzadziej dziś stosowane – są na zdarzenia SEL znacznie odporniejsze. Paradoksalnie jednak, to właśnie pasożytnicze struktury BJT – tworzące swego rodzaju „dodatkowy tyrystor” w konwencjonalnych układach CMOS (rysunek 6) – są odpowiedzialne za zwarcie szyn zasilania w wyniku działania ciężkiego jonu (a w pewnych warunkach nawet rozpędzonego, pojedynczego protonu). Dostarczenie niewielkiego ładunku do struktury powoduje wyzwolenie kaskady efektów, skutkujących włączeniem wspomnianego tyrystora i utworzeniem w ten sposób niskoimpedancyjnej ścieżki dla prądu zwarcia, płynącego pomiędzy szynami zasilania. Inne obwody mogą wprawdzie na chwilę odciąć zasilanie w wyniku przekroczenia dopuszczalnego poboru prądu (i „zresetować” w ten sposób pasożytniczą strukturę), jednak nie zawsze takie rozwiązanie jest możliwe do wdrożenia. Problem rozwiązuje się więc przede wszystkim na drodze wprowadzenia odpowiedniej modyfikacji samej struktury krzemowej.

- SEGR/SEB (Single Event Gate Rupture/Single Event Burnout) – efekty te – choć bazują na nieco innych zjawiskach – są zwykle wymieniane razem ze względu na zbliżoną charakterystykę z punktu widzenia warunków układowych. Obydwa efekty występują pod wpływem uderzenia ciężkiego jonu w strukturę wyłączonego w danym momencie tranzystora dużej mocy, powodując nagły wzrost wartości prądu (lub napięcia) i w efekcie uszkodzenie tranzystora, a zwykle także innych elementów urządzenia. SEB w odniesieniu do tranzystorów DMOS można porównać do efektu SEL, ale dotyczącego jedynie pojedynczej struktury pasożytniczej typu BJT. Zjawisko to jest także szeroko rozpatrywane w zakresie diod Schottky’ego, które również mogą ulec katastrofalnemu w skutkach uszkodzeniu przez ciężki jon (fotografia 10).

Jak widać, wymienione powyżej efekty prowadzą zwykle do uszkodzenia elementów/układów poprzez (dość klasyczne) przeciążenie zasilacza i przegrzanie układów scalonych bądź elementów dyskretnych. Z uwagi na katastrofalne skutki wielu takich zdarzeń (nietrudno znaleźć komunikaty prasowe traktujące o uszkodzeniach elementów zasilania niektórych satelitów, co doprowadziło do niepowodzenia całej misji) określane są one często mianem hard faults.

Druga kategoria – błędy typu soft faults – obejmuje natomiast nieniszczące zaburzenia pracy układów elektronicznych (najczęściej cyfrowych, choć nie tylko), tj.:

- SET (Single Event Transient) – pojedyncze cząstki o odpowiednio wysokiej energii, przelatujące przez wnętrze urządzenia elektronicznego, mogą wygenerować niepożądane impulsy, które – zależnie od rodzaju układu, szybkości taktowania oraz wartości napięcia zasilania – będą propagować w obwodach, zwykle zaburzając pracę układów cyfrowych. Im wyższa jest częstotliwość zegara, tym wyższe prawdopodobieństwo „wyłapania” przez układ takiego „nieplanowanego” impulsu. Z drugiej strony, margines zakłóceń w przypadku układów niskonapięciowych (a takie są szeroko stosowane także w branży kosmicznej z uwagi na konieczność optymalizacji poboru mocy) jest obniżony względem logiki o wyższej rozpiętości napięć, co powoduje dodatkowe zwiększenie podatności na zaburzenia impulsowe. Także układy analogowe mogą „odczuwać” skutki SET, jednak w przypadku układów liniowych propagowane będą także impulsy o mniejszych amplitudach (podczas gdy obwody cyfrowe z natury rzeczy będą dyskryminowały słabsze zdarzenia, niezdolne do zmiany stanu na danej linii).

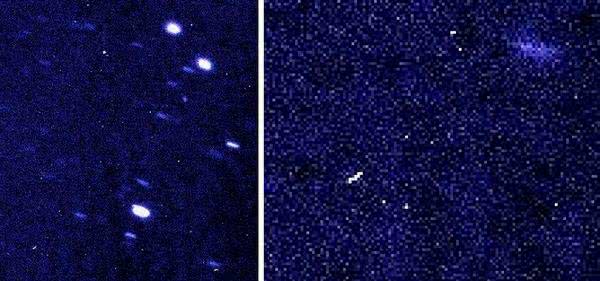

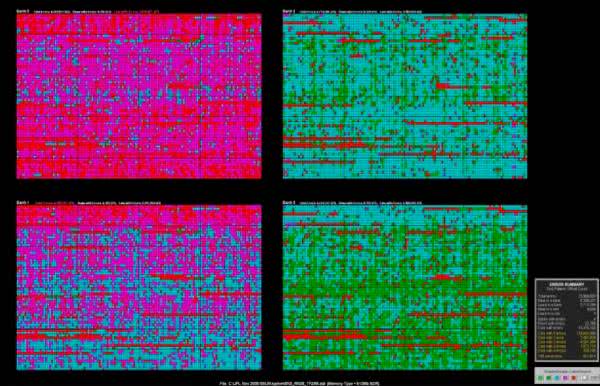

- SEU/MCU/MBU (Single Event Upset/Multiple Cell Upset/Multiple Bit Upset) – jednym z zagrożeń dla misji kosmicznych są uszkodzenia danych w pamięci lub rejestrach ulotnych (zatrzaskach, rejestrach konfiguracyjnych, itd.). Mechanizmy działania poszczególnych efektów są zróżnicowane – przykładowo, cząstka wysokoenergetyczna może „dodać” ładunek do kondensatora pamięci DRAM lub zmienić stan tranzystora należącego do danej komórki pamięci. Jeżeli jednak trajektoria przelotu jonu jest w przybliżeniu równoległa do powierzchni półprzewodnikowej struktury pamięci bądź jon jest ciężki i niesie ze sobą sporą energię (wystarczającą do „obdzielnia” ładunkiem kilku sąsiadujących obszarów pamięci), możliwe jest wystąpienie uszkodzeń wielu – odpowiednio – komórek (MCU) lub bitów (MBU) – rysunek 7.

- SEFI (Single Event Functional Interrupt) – stanowi odmianę SEU, rozpatrywaną jednak – z funkcjonalnego punktu widzenia – jako zdarzenie znacznie wyższej rangi, niż SEU w obszarze pamięci masowej. W tym przypadku bowiem mamy do czynienia ze zmianą wartości szczególnie istotnego bitu – np. flagi przerwania bądź rejestru kontrolnego procesora. Nietrudno się domyślić, że przekłamanie pojedynczego bitu w pamięci framegrabbera czy też logów pomiarowych będzie zwykle nieporównanie mniej istotne dla powodzenia misji, niż nieplanowany reset procesora bądź przedwczesne uruchomienie ważnej procedury sterującej elementami wykonawczymi. Zdarzenia SEFI mogą też manifestować się poprzez uszkodzenia większych bloków danych w pamięciach. Podstawowymi mechanizmami ochrony przed tego typu problemami są: redundancja oraz kodowanie korekcyjne (ECC).

Ochronę układów scalonych i komponentów dyskretnych przed zgubnym wpływem promieniowania jonizującego określa się mianem radiation hardening. Zagadnienie to obejmuje szereg technik stosowanych przez producentów półprzewodników, w tym przede wszystkim:

- zmianę podłoży na silniej domieszkowane przy zachowaniu niezmienionych masek fotolitograficznych poszczególnych układów scalonych (poprawa przewodnictwa i zwiększenie odporności na SEL),

- redukcję ilości izotopu 10Bo w strukturze półprzewodnika,

- zastosowanie izotopu 10Bo w obudowie układu scalonego w roli ekranu „wyłapującego” neutrony, ale jednocześnie oddzielonego od właściwej struktury półprzewodnikowej na odległość uniemożliwiającą przechodzenie produktów rozpadu promieniotwórczego do płytki krzemowej,

- minimalizację ilości zanieczyszczeń zdolnych do emisji cząstek alfa w ramach procesu wytwarzania układów oraz w materiałach stosowanych do zalewania układów,

- rozdział strukturalny tranzystorów w strukturach CMOS w celu uniknięcia tworzenia pasożytniczych struktur tyrystorowych,

- stosowanie izolowanych podłoży (Silicon On Insulator – SOI, Silicon On Sapphire – SOS), uniemożliwiających gromadzenie niepożądanych ładunków wygenerowanych przy przejściu cząstki wysokoenergetycznej przez rejon podłoża (rysunek 8),

- stosowanie pierścieni ochronnych (guard rings) pomiędzy sąsiadującymi obszarami struktury półprzewodnikowej w celu zapobiegania SEL,

- stosowanie tranzystorów ELT (Edge-Less Transistor) w celu zapobiegania wzrostowi prądu upływu w ramach efektu TID (rysunek 9).

Opisane powyżej techniki bazują na modyfikacjach zarówno w projekcie, jak i procesie wytwarzania komponentów półprzewodnikowych. Warto jednak pamiętać, że istnieje jeszcze szereg innych metod zapobiegania awariom powodowanym przez promieniowanie kosmiczne – co więcej, część z nich (np. redundancja) pozwala także unikać problemów wywoływanych przez inne rodzaje narażeń, m.in. temperaturę oraz wibracje.

Przeglądając katalogi komponentów rekomendowanych dla branży kosmicznej (i nie tylko) można spotkać się z następującymi wartościami charakteryzującymi odporność podzespołów na promieniowanie jonizujące:

- LETth (Linear Energy Transfer threshold) – progowa wartość liniowego współczynnika przenoszenia energii, dla której należy spodziewać się wystąpienia w komponencie danego efektu (najczęściej SEL). Wartość ta, określana dla ustalonego natężenia strumienia cząstek wysokoenergetycznych, jest tym wyższa, im bardziej odporny na promieniowanie jest dany element. Sam współczynnik LET oznacza natomiast miarę energii promieniowania jonizującego absorbowanego przez materię na jednostkowym odcinku drogi. Jednostką LET, a więc też LETth, jest [MeV*cm²/mg] (zapisywana też jako MeV/mg/cm²).

- TID – wartość całkowitej dawki pochłoniętej przez układ, tolerowana dzięki konstrukcji komponentu. Pomyślne przejście testu jest rzecz jasna zdefiniowane inaczej dla każdego typu elementu (badane są więc np. wejściowe prądy upływu i napięcia niezrównoważenia wzmacniaczy operacyjnych czy też napięcia wyjściowe i prądy zasilania układów cyfrowych dla obu stanów logicznych). Wartość TID zapisywana jest zwykle w postaci [krad(Si)], czyli w kiloradach dla krzemu i często służy ona za czynnik różnicujący komponenty określane jako radiation tolerant i radiation hardened (rad-hard) – podczas gdy pierwsza grupa obejmuje zwykle komponenty o TID nieprzekraczającej 100 krad, to znacznie bardziej odporne podzespoły rad-hard mogą wytrzymać wielokrotnie większe dawki promieniowania. Czytelników zainteresowanych tematyką badań TID odsyłamy do obszernej bazy danych, zawierającej raporty z badań przeszło 400 komponentów przetestowanych przez Goddard Space Flight Center [7].

Próżnia

Rozpatrując warunki środowiskowe, w jakich pracują sztuczne satelity i sondy kosmiczne, nie można zapominać także o wpływie wysokiej próżni na działanie układów elektronicznych. Jednym z istotniejszych aspektów jest wspomniany wcześniej brak chłodzenia konwekcyjnego, znacznie utrudniający odprowadzanie ciepła z komponentów elektronicznych, zwłaszcza w obwodach zasilania, sterowania elementami wykonawczymi, czy też nadajników radiowych.

Innym efektem, który zawsze należy brać pod uwagę planując projekt urządzenia przeznaczonego do wyniesienia w przestrzeń kosmiczną, jest zjawisko odgazowywania (outgassing lub offgassing). Efekt ten – w przypadku elektroniki – polega na wydzielaniu przez materiały znajdujące się w stanie stałym (np. obudowy komponentów, uszczelki, kleje, zalewy czy też laminaty PCB) niewielkich ilości lotnych związków. Proces ten zachodzi pod wpływem wysokiej próżni panującej w przestrzeni kosmicznej, a jego efektem są zanieczyszczenia osadzające się na pobliskich powierzchniach (fotografia 11).

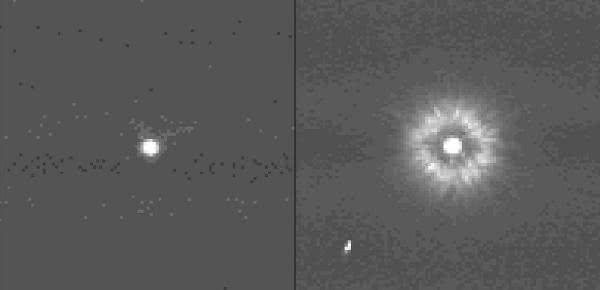

Choć pozornie problem odgazowania może wydawać się relatywnie mało istotny, to w rzeczywistości niesie on za sobą szereg poważnych konsekwencji, których znaczenie dla awaryjności aparatury wynika z rodzaju wydzielanych substancji, ich ilości oraz miejsca osadzania. Zdecydowanie największe zagrożenie dla powodzenia misji niesie zanieczyszczanie elementów optycznych (spadek przezierności soczewek, osłabianie natężenia światła docierającego do fotodetektorów, powstawanie błędów obrazowania – fotografia 12, itp.), układów wysokonapięciowych (ryzyko powstania łuków elektrycznych – fotografia 13) czy też czujników (wprowadzanie błędów pomiarowych lub nawet uniemożliwienie wykonywania pomiarów). Nie można także pominąć efektu pogorszenia parametrów wytrzymałościowych z uwagi na zmiany strukturalne zachodzące w efekcie zjawiska outgassing.

W celu scharakteryzowania właściwości materiału pod względem zjawiska odgazowywania producenci podają w notach katalogowych dwie główne wielkości:

- TML (Total Mass Loss) – całkowity ubytek masy, podawany w procentach masy początkowej materiału. NASA oraz ESA wymagają, by wartość TML dla stosowanych w urządzeniach kosmicznych materiałach nie przekraczała 1%.

- CVCM (Collected Volatile Condensable Material) – oznacza ilość lotnego materiału uwolnionego z próbki, który ulega kondensacji na kolektorze w określonym przedziale czasowym i w warunkach zadanej temperatury. Wartość ta jest również określana jako procent masy początkowej próbki – wytyczne wspomnianych wyżej agencji kosmicznych określają dopuszczalną granicę CVCM jako 0,1%.

Normy określające testy zjawiska odgazowywania dla materiałów space-grade określają dokumenty:

- (ESA) ECSS-Q-ST-70-02C – Thermal vacuum outgassing test for the screening of space materials,

- (NASA) SP-R-0022A – Vacuum stability requirements of polymeric material for spacecraft application.

Plazma

Jak wspomnieliśmy już wcześniej, przestrzeń kosmiczna – pomimo tego, iż panuje w niej wysoka próżnia – zdecydowanie nie jest całkowicie pustym obszarem, pozbawionym jakiejkolwiek materii. Oprócz cząstek promieniowania kosmicznego, izotropowo penetrujących znane nam obszary Wszechświata, mamy do czynienia także z plazmą – zwłaszcza z uwagi na aktywność słoneczną.

Plazma, jako „chmura” zjonizowanych cząstek, może nie tylko z łatwością przewodzić prąd elektryczny, ale także skutecznie „ładować” elementy przewodzące satelity do potencjałów rzędu –100 V (względem jonosfery). Za zjawiska te odpowiedzialne są „gorące elektrony”, otaczające satelitę i to zarówno w rejonie LEO, jak i GEO (przy czym w zależności od wysokości orbity zmienia się zarówno gęstość, jak i energia plazmy).

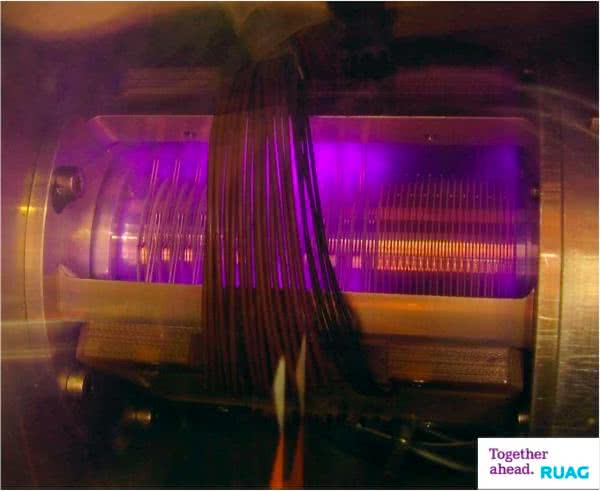

Opisane efekty prowadzą do wyładowań ESD, mających miejsce głównie w obszarze ogniw słonecznych (fotografia 14), ale także stosowanych do ich podłączenia złączy obrotowych (tzw. sliprings – fotografie 15 i 16).

Warto tutaj podkreślić, że narażenie właśnie tych komponentów statków kosmicznych wynika nie tylko z ich ułatwionej ekspozycji na otaczającą plazmę (są to przecież najbardziej wysunięte na zewnątrz elementy satelity), ale także z faktu, iż generowane przez nie napięcia są relatywnie wysokie [8], a impedancja – możliwie niska (dla zapewnienia maksymalnej sprawności). Taka „mieszanka wybuchowa” sprawia, że gdy dojdzie już do powstania łuku elektrycznego na powierzchni panelu solarnego, to zdarzenie takie często kończy misję z uwagi na nieodwracalne ograniczenie dostępnej mocy zasilania. Jakby tego było mało, panele solarne (jak i wszystkie inne komponenty wystawione na zewnątrz statków kosmicznych) są też narażone na „zwyczajne” (choć również katastrofalne w skutkach) uszkodzenia mechaniczne, spowodowane kolizjami z niewielkimi, kosmicznymi śmieciami. O ile bowiem swobodnie „fruwający” w przestrzeni kosmicznej fragment materii (np. poszycia jednego z odrzuconych modułów rakiety nośnej czy też mikroskopijnego meteorytu) wielkości kilku milimetrów nie wydaje się być szczególnym zagrożeniem dla (solidnych przecież) konstrukcji satelitarnych, to nietrudno wyobrazić sobie efekt jego działania w przypadku kolizji ze szklanym pokryciem panelu, gdy prędkość odłamka ma wartość rzędu 10 km/s (fotografia 17)...

Historia zna już wiele przypadków satelitów, z którymi obsługa naziemna straciła kontakt właśnie ze względu na uszkodzenie ogniw słonecznych. Problem jest bardzo poważny i nie sposób pominąć go w analizie ryzyka, dlatego też powstały standardy branżowe poświęcone zjawiskom gromadzenia ładunków na panelach satelitów:

- NASA-HDBK-4002 – Mitigating In-Space Charging Effects-A Guideline,

- ISO 11221:2011 – Space systems – Space solar panels – Spacecraft charging induced electrostatic discharge test methods.

Rzecz jasna, masywne wyładowania ESD w strukturze paneli solarnych stanowią największe zagrożenie dla „życia” satelitów i sond kosmicznych (w tym szczególnie przeznaczonych do badania Słońca), jednak tego typu zdarzenia mogą doprowadzić także do uszkodzeń wielu innych elementów aparatury. Co więcej, nawet niewielkie wyładowania nieniszczące są w stanie skutecznie zakłócać pracę czułej aparatury pomiarowej (zwłaszcza tej przeznaczonej do… badania cząstek naładowanych), czy też np. systemów telekomunikacyjnych. Sytuację dodatkowo pogarszają wspomniane wcześniej zanieczyszczenia osadzające się w wyniku odgazowania materiałów konstrukcyjnych satelity bądź osadzania mikroskopijnych, kosmicznych „śmieci” (cząstek stałych).

Podsumowanie

Zaprezentowane w artykule zagadnienia inżynierii kosmicznej jasno pokazują, że praca w tej branży wymaga doskonałej znajomości charakterystyki środowiska pozaziemskiego oraz zagadnień fizycznych, leżących u podstaw interakcji promieniowania jonizującego z półprzewodnikami. Wyjątkowo „niewdzięczne” warunki, w jakie wysyłane są sztuczne satelity oraz sondy kosmiczne do badania dalekich zakątków Układu Słonecznego (i nie tylko) doprowadziły już przecież do spektakularnego krachu niejednej misji. Tym bardziej więc zaskakują sukcesy projektów takich, jak chociażby sondy Voyager 1 i Voyager 2, które – mimo iż zaprojektowane zostały kilka dekad temu – były w stanie z sukcesem wejść w przestrzeń międzygwiezdną i nadawać z niej kolejne, bezcenne dane naukowe. Paradoksalnie, rozwój i miniaturyzacja elektroniki wyszły branży kosmicznej na dobre tylko częściowo, bowiem wraz ze wzrostem stopnia złożoności aparatury rośnie także liczba potencjalnych słabych punktów. A warunki panujące w kosmosie są w stanie z łatwością – zdawałoby się nawet, że na złość strudzonym inżynierom – wykorzystać wszystkie możliwości, by uszkodzić warte miliony dolarów urządzenia.

Mamy nadzieję, że zaprezentowany przegląd pozwoli naszym Czytelnikom na lepsze zrozumienie trudów branży space i zachęci do samodzielnego zgłębienia tej porywającej tematyki. Tym bardziej, że niewiarygodnie dużo cennych informacji, będących wynikiem wieloletnich, intensywnych badań prowadzonych przez największe agencje kosmiczne (NASA, ESA, itd.) jest dostępnych za darmo (lub za niewielką opłatą) w zasobach internetowych.

inż. Przemysław Musz, EP

Przypisy:

1. Inklinacja – kąt pomiędzy płaszczyzną zawierającą daną orbitę, a płaszczyzną równika.

2. Ekscentryczność (in. mimośród) – bezwymiarowa wielkość określająca kształt orbity. Ekscentryczność równa zeru oznacza orbitę kołową, mniejsza od jedności – eliptyczną, równa 1 – paraboliczną, a większa od jedności – hiperboliczną.

3. W chwili pisania niniejszego artykułu kategoria 9000, podobnie jak i 0000, pozostają puste (brak dokumentów udostępnionych do pobrania).

4. https://t.ly/1pgC

5. Jednostką dawki pochłoniętej, stosowaną w elektronice, jest 1 rad. Wartość ta odpowiada 0,01 Gy = 0,01 J/kg – grej jest natomiast oficjalnie przyjętą jednostką pochodną według układu SI, powszechnie używaną m.in. w zastosowaniach medycznych (radioterapii, obrazowaniu tomograficznym oraz ochronie radiologicznej).

6. https://t.ly/1BboZ

7. https://radhome.gsfc.nasa.gov/radhome/papers/tidpart.html

8. Dawniej systemy zasilania aparatury kosmicznej opierały się na szynie o relatywnie bezpiecznym (pod względem interakcji z plazmą) napięciu 28 V; wartość tę stopniowo podwyższano (np. do 100 V w przypadku satelitów umieszczanych na GEO), co rzecz jasna dodatkowo komplikowało sytuację związaną z wyładowaniami ESD. Co ciekawe, w późniejszych latach liczne zespoły naukowe prowadziły zaawansowane badania nad jeszcze bardziej drastycznym podwyższaniem napięcia paneli słonecznych – nawet do 1 kV (https://t.ly/-hKP).

Zaloguj

Zaloguj