Drastyczny spadek cen komponentów elektronicznych – charakterystyczna cecha dynamicznego i wielokierunkowego rozwoju tej branży – jest widoczny także w segmencie aparatury pomiarowej. Ciągły wzrost wydajności procesorów aplikacyjnych, wprowadzanie na rynek coraz lepszych (szybszych, mniej „szumiących” i dokładniejszych) przetworników ADC, czy nawet upowszechnienie precyzyjnych źródeł częstotliwości wzorcowej o doskonałych parametrach fazowych i wysokiej stabilności – to tylko niektóre z czynników, które wpływają na ciągłe przeobrażenia w rynku przyrządów laboratoryjnych, a zwłaszcza oscyloskopów cyfrowych i analizatorów widma.

Jednak sama tylko dostępność komponentów to zdecydowanie nie wszystko – równie istotne są zmiany, które zachodzą w zakresie realnych potrzeb użytkowników. Superszybkie interfejsy cyfrowe – w tym przede wszystkim kolejne wersje standardu USB 3.x czy nawet USB 4 – wręcz wymuszają na producentach aparatury pomiarowej wdrażanie rozwiązań umożliwiających sprawne i wiarygodne debugowanie szeregowych łączy transmisyjnych. A jest o co walczyć – przecież niemal każdy współczesny telefon, nie wspominając już o komputerach, dyskach zewnętrznych, nośnikach typu pendrive czy nawet rozmaitych urządzeniach specjalistycznych – jest dzisiaj wyposażony w szybki port USB. Jeżeli w nowym projekcie pojawiają się problemy związane z integralnością sygnałów, objawiające się czy to całkowitą utratą transmisji, czy – co gorsza – trudniej uchwytnymi dysfunkcjami, widocznymi tylko w określonych warunkach testowych – to podłączenie szybkiego oscyloskopu z odpowiednimi sondami staje się absolutną koniecznością. A nowoczesne łącza bezprzewodowe? One też nierzadko wymagają „podejrzenia” rzeczywistych przebiegów i zmierzenia szeregu parametrów wpływających na bilans łącza czy niezawodność transmisji. To samo dotyczy radarów, które dawno przestały już być domeną branży wojskowej i weszły do stałego repertuaru technik sensorycznych w innych aplikacjach, chociażby w nowoczesnej motoryzacji czy w coraz szerszym sektorze małych satelitów.

Co jeszcze należy wziąć pod uwagę analizując trendy na rynku oscyloskopów? Spore znaczenie mają także przyzwyczajenia samych użytkowników. Chyba nikt nie ma już wątpliwości, że żyjemy w czasach „dotykowych” – coraz więcej urządzeń projektowanych i wprowadzanych na rynek nie ma już żadnych albo prawie żadnych elementów elektromechanicznych (przełączników, przycisków, enkoderów obrotowych), klasycznych potencjometrów itp. Producenci rezygnują z nich na rzecz coraz lepszych ekranów dotykowych, a trend ten jest dodatkowo napędzany przez intensywnie rozwijający się rynek „multimedialnych” procesorów aplikacyjnych, o których zresztą sporo piszemy w tym numerze „Elektroniki Praktycznej”. To wszystko sprawia, że większość nowych modeli oscyloskopów jest już wyposażona w spore ekrany dotykowe o doskonałej jakości obrazu, a interfejsy graficzne tegoż sprzętu już na etapie wstępnych założeń są projektowane z myślą o sterowaniu dotykowym. I to nie byle jakim, bo zwykle uwzględniającym rozmaite gesty, chociażby w zakresie przeskalowywania wzmocnienia kanałów wejściowych czy też podstawy czasu (funkcja multi-touch zawsze w cenie!).

Szybciej, łatwiej, lepiej

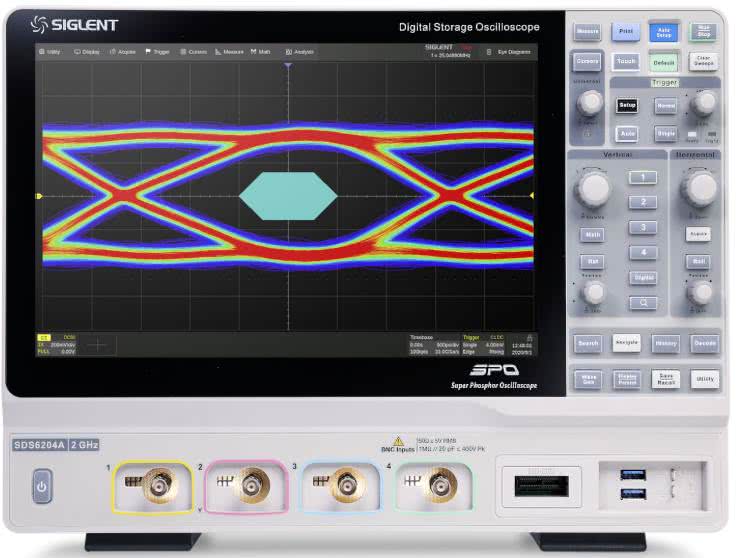

Wspomniany już wpływ rozwoju branży zaawansowanych systemów wbudowanych na funkcjonalność pomiarową i parametry oscyloskopów jest widoczny (siłą rzeczy) niemal wyłącznie w segmencie konstrukcji high-end. Najdroższe serie oscyloskopów (fotografia 1) są już dziś wyposażane w zautomatyzowane narzędzia programowe i sprzętowe umożliwiające np. prowadzenie testów zgodności badanego urządzenia (DUT) z wymogami standardu USB 4. Sprawa zdecydowanie nie jest banalna, gdyż w czwartej generacji USB mamy już do czynienia z potężną przepustowością (do 40 GB/s) oraz ogromem rozmaitych problemów wynikających z tak dużej prędkości transmisji – specyfikacja nowego łącza szeregowego określa m.in. wymagania dotyczące takich parametrów jak jitter czy szybkość narastania zboczy sygnału, a dodatkowo trzeba weryfikować wpływ wszystkich elementów linii transmisyjnej na przesłuchy, odporność na zakłócenia EMI i wiele innych aspektów. A przecież rynek komputerowy nie zatrzymuje się w dążeniu do „podkręcania” szybkości przesyłu danych – USB 4 2.0 to już 80 GB/s w trybie symetrycznym oraz 120 GB/s w asymetrycznym (!).

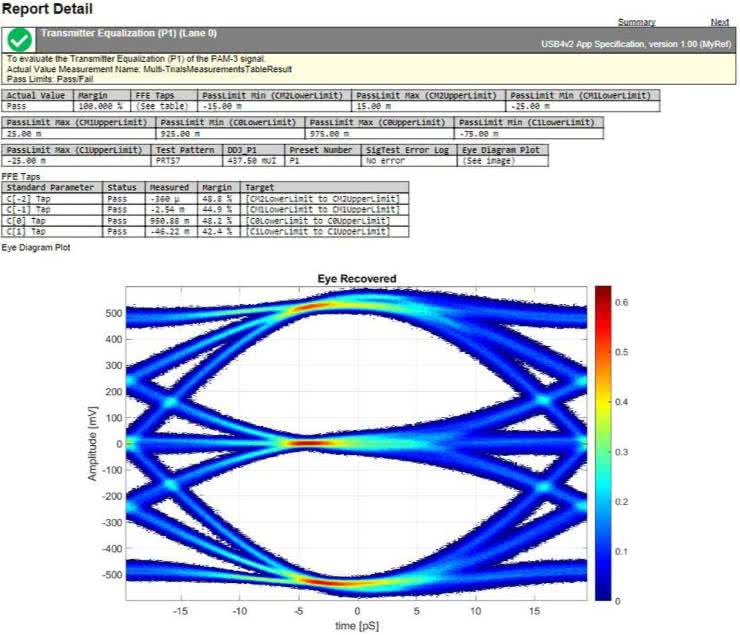

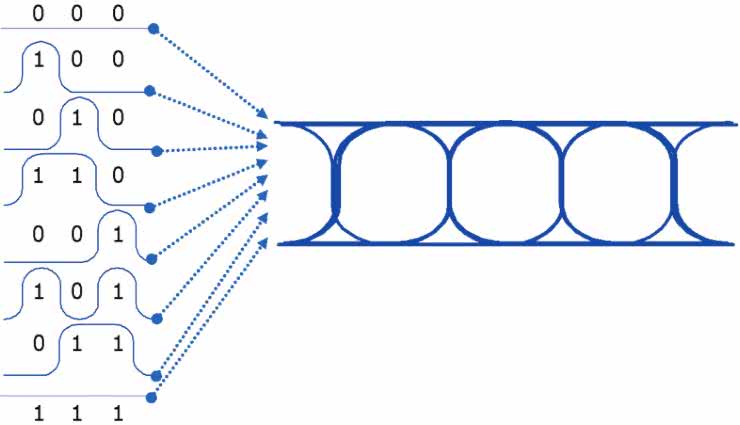

Podstawową reprezentacją jakości przesyłu danych szeregowych jest diagram oka (rysunek 1), pozwalający szybko ocenić najważniejsze parametry integralności sygnałowej łącza.

Specjalistyczne oprogramowanie współpracujące z najnowocześniejszymi oscyloskopami w dużej mierze automatyzuje cały proces pomiaru, tworząc rozbudowane raporty oraz klasyfikując DUT pod kątem (nie)spełnienia wymogów narzuconych przez specyfikację standardu USB. Warto w tym miejscu przypomnieć, że diagram oka nie jest po prostu zwykłym nałożeniem na siebie kolejnych przebiegów zmierzonych na cyfrowej szynie danych. W rzeczywistości bowiem do utworzenia takiego wykresu konieczne jest zaawansowane odzyskiwanie sygnału zegarowego (clock recovery), dzięki któremu oprogramowanie oscyloskopu jest w stanie utworzyć wiarygodną reprezentację „statystyczną” zboczy i stanów na linii (poprzez nałożenie na siebie oscylogramów zarejestrowanych dla kombinacji trzech kolejnych bitów: 000, 001, 010, 011, 100, 101, 110 oraz 111 – patrz rysunek 2).

Aby nie być gołosłownym, przyjrzyjmy się naprawdę imponującym parametrom najwyższego modelu oscyloskopu z serii UXR (patrz fotografia 1), czyli jednego z najbardziej zaawansowanych urządzeń tego typu na świecie.

Jako przykład przytoczymy tutaj wersję absolutnie topową, czyli UXR1104A:

- 4 kanały analogowe,

- pasmo pomiarowe: 110 GHz,

- próbkowanie: 256 GSa/s (w każdym kanale),

- pamięć próbek do 2 Gpts,

- rozdzielczość przetworników ADC: 10 bitów (natywna)/14 bitów (w trybie uśredniania),

- czas narastania/opadania: 44 ps,

- cena: około 6,8 mln PLN.

Pamięć godna słonia

Duża pamięć próbek jest dziś (na szczęście!) spotykana nie tylko w najdroższych oscyloskopach, oferowanych za cenę kilkusetmetrowej rezydencji z basenem. Można bez zbędnej przesady powiedzieć, że długi rekord stał się standardem i stanowi jedną z podstawowych cech współczesnego oscyloskopu cyfrowego. Dawniej kilka milionów próbek stanowiło marzenie każdego posiadacza oscyloskopu cyfrowego. Dziś wyczynem nie jest nawet pamięć mogąca pomieścić kilkadziesiąt Mpts – przykładowo, tanie oscyloskopy Rigol z serii DHO800 (nawet te w cenie detalicznej na poziomie 330 dolarów) mog, po programowym rozszerzeniu pamięci, zaoferować przestrzeń do przechowywania 25 milionów próbek (patrz fotografia 2).

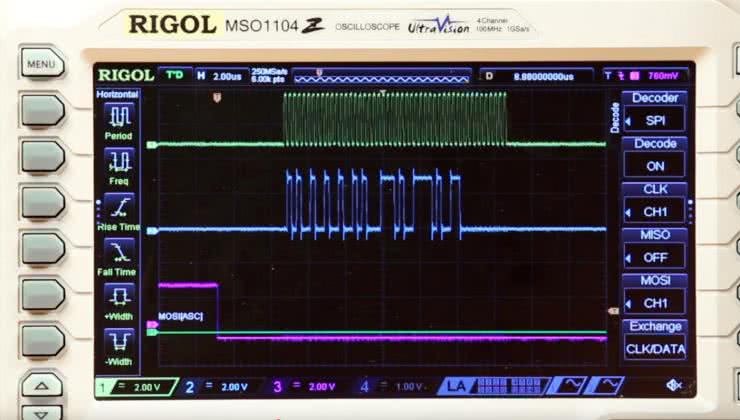

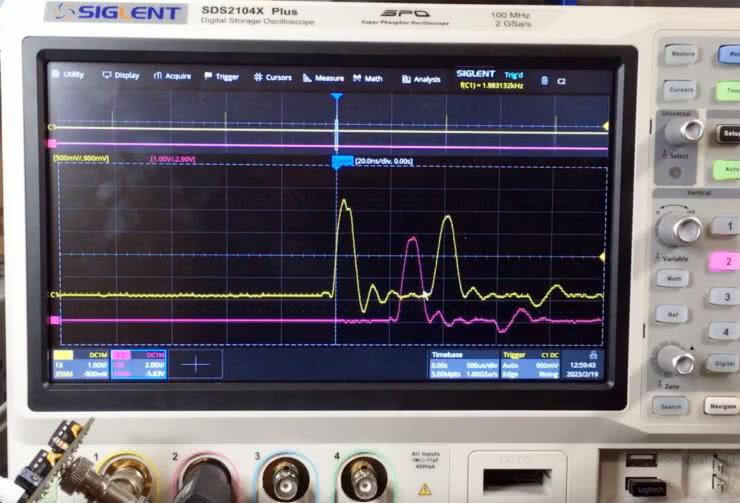

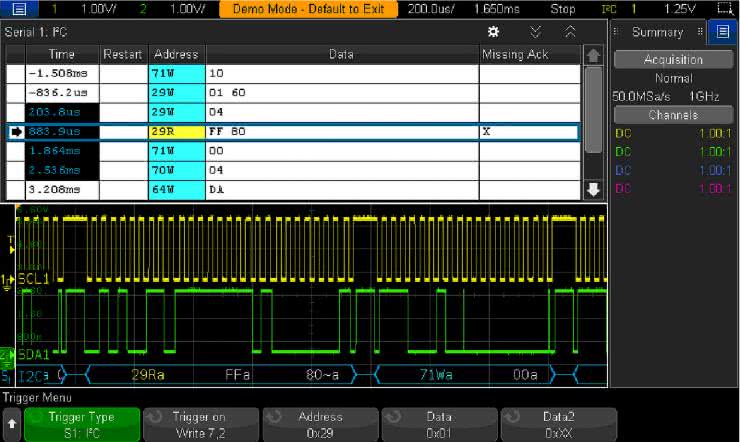

Zalety długiego rekordu są liczne i znaczące. Użytkownik może na przykład dokonać pojedynczej akwizycji obszernego fragmentu danych na szynie szeregowej, a następnie zdekodować interesującą go część transmisji (np. tylko jedną paczkę danych) – patrz fotografia 3.

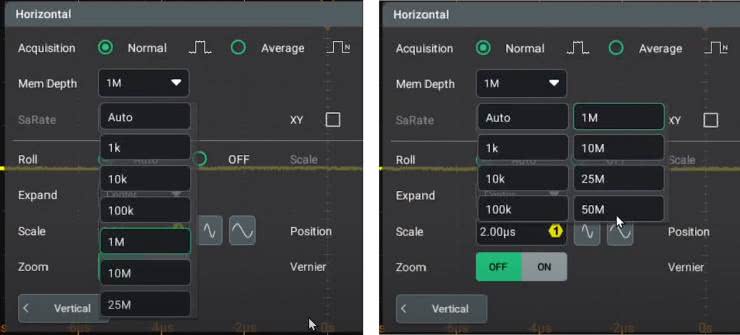

Inny przykład to zarejestrowanie przebiegu okresowego z rzadko powtarzającymi się zaburzeniami oraz zastosowanie silnie powiększającej lupy czasowej, zwanej dziś funkcją zoom (fotografia 4), do obejrzenia wąskiego fragmentu takiego przebiegu oraz jego otoczenia w szerokim przedziale czasu. Gwoli ścisłości należy dodać, że w drugim z wymienionych przypadków znacznie bardziej sensownym rozwiązaniem wydaje się zastosowanie pamięci segmentowanej i funkcji przeszukiwania, ale… tutaj jak zwykle daje o sobie znać przysłowiowy diabeł tkwiący w szczegółach. Po pierwsze nie wszystkie oscyloskopy cyfrowe są w ogóle wyposażone w pamięć segmentowaną, po drugie zaś nawet, jeżeli dany model oferuje taką funkcjonalność, to nierzadko działa ona topornie, jest niewygodna albo nieintuicyjna w obsłudze, przez co umiarkowanie nadaje się do praktycznego zastosowania. Taka przypadłość jest głównie domeną tańszych, chińskich marek aspirujących do objęcia jak największej części rynku półprofesjonalnego i „ugryzienia” kawałka tortu przeznaczonego dla zawodowców.

Kradzione nie tuczy

Nie ulega wątpliwości, że układy pamięci dynamicznej z roku na rok są coraz pojemniejsze, szybsze, a także... tańsze. Ten trend doprowadził do ciekawej sytuacji na rynku oscyloskopów – producentom bardziej opłaca się instalować fabrycznie pamięć w pełnym możliwym rozmiarze (dla danego modelu) i ograniczać ją programowo w celu dywersyfikacji oferty, niż produkować kilka wersji różniących się liczbą i/lub pojemnością znajdujących się na płycie „kości”.

Nic więc dziwnego, że w przypadku wielu modeli tańszych oscyloskopów użytkownicy podejmują się zaawansowanej inżynierii odwrotnej, by „oszukać system” (dosłownie oraz w przenośni) i nieoficjalnie odblokować wszystkie dostępne funkcje (rysunek 3). To samo zjawisko dotyczy zresztą także innych parametrów i funkcji aparatury, np. szerokości pasma analogowego czy też rozmaitych opcji dekodowania sygnałów cyfrowych, zaawansowanych trybów wyzwalania itp. – wszystkie pożądane modyfikacje są wprowadzane bez najmniejszej nawet zmiany w samym sprzęcie.

W tym miejscu może nasunąć się pytanie: dlaczego producenci aparatury pomiarowej nie stosują bardziej niezawodnych zabezpieczeń przed nieautoryzowanym hackowaniem opcji dodatkowych? Zdawałoby się, że pozostawienie stosunkowo łatwo dostępnych „furtek” skutkuje tylko i wyłącznie stratami – firma sprzedaje oscyloskopy za najniższą możliwą cenę, a użytkownicy – zamiast „legalnie” kupić dodatkowe opcje – odblokowują sobie wszystkie rozszerzenia za darmo, bez żadnej gratyfikacji należnej producentowi. Czysta strata?

Zastanówmy się wspólnie nad motywacją, która może leżeć za takim, a nie innym podejściem producentów. Jedną z możliwych opcji byłoby zastosowanie kluczy sprzętowych, które – włożone w odpowiedni slot w obudowie oscyloskopu – odblokowują określony zestaw funkcjonalności.

Takie właśnie rozwiązanie zastosowała firma Tektronix w serii kultowych oscyloskopów MDO3000: niewielki „pendrive” (fotografia 5) jest wsuwany w gniazdo znajdujące się w prawym górnym rogu panelu czołowego (fotografia 6). A jakie są wady tego rozwiązania? Z pewnością należy do nich dodatkowa komplikacja, związana zarówno z kwestiami mechanicznymi, jak i elektronicznymi.

W segmencie budżetowych oscyloskopów kosztujących kilkaset dolarów liczy się dosłownie każdy cent, więc taka metoda rozszerzania funkcjonalności raczej nie wchodzi w grę.

Innym wyjściem mogłoby być zastosowanie aktywacji przez internet – tak jak ma to miejsce chociażby w przypadku aplikacji mobilnych czy też oprogramowania desktopowego. Dziś nawet najtańsze oscyloskopy (a także inne urządzenia pomiarowe) mają już wbudowany port Ethernet, więc fizyczne połączenie z siecią jest dostępne „w standardzie”. Takie rozwiązanie pozwoliłoby producentowi na uzyskanie lepszej kontroli nad tym, które urządzenie (identyfikowane przez określony numer seryjny) jest w danym momencie rozszerzane o dodatkowe opcje.

Ochrona własności intelektualnej oraz komercyjnego interesu przedsiębiorstw jest traktowana bardzo poważnie przez większość dużych graczy na rynku software’owym. Warto w tym miejscu przypomnieć chociażby o akcji „amnestii”, którą uruchomił producent oprogramowania Altium Designer kilkanaście lat temu – użytkownicy pracujący na nielegalnych kopiach pakietu EDA mogli „przyznać się” do posiadania pirackiej wersji i zalegalizować oprogramowanie za określoną przez producenta cenę. Co zatem stoi za dość pobłażliwym podejściem niektórych producentów aparatury do pilnowania spraw związanych z rozszerzeniami opcji programowych?

Można się domyślać, że chodzi tutaj o… nietypowy efekt marketingowy. Ludzka psychika ma tendencje do gloryfikacji wszelkiego rodzaju promocji i prezentów, co wiąże się chociażby ze znanym efektem „99” – choć wszyscy doskonale wiedzą, że 1000 zł oraz 999,99 zł to niemal dokładnie taka sama cena, to jednak sklepy od lat z równą skutecznością stosują tę technikę do wpływania na sposób odczuwania cen przez konsumentów. Jeżeli zatem producent wkalkuluje ryzyko nieautoryzowanych ulepszeń w cenę sprzętu, to pozorna strata może paradoksalnie stać się źródłem zysku – zainteresowanie sprzętem znacznie wzrośnie, bo tysiące odbiorców będą chciały „oszukać system”, kupując najtańszą wersję sprzętu i podkręcając ją do wersji pełnej. Potencjalna utrata gwarancji najwyraźniej nie działa na nich odstraszająco, ale nie oszukujmy się – mądrze użytkowana aparatura pomiarowa jest znacznie trwalsza, niż zdecydowana większość współczesnej elektroniki konsumenckiej.

Analogówka pod mikroskopem, czyli o czułości w świecie oscyloskopów

Standardowa rozdzielczość przetworników analogowo-cyfrowych, które znajdują zastosowanie w oscyloskopach, wynosi 8 bitów. Wprawdzie niemal zawsze istnieje możliwość programowego zwiększenia tej wielkości, np. do 10 bitów, jednak jest to wykonalne tylko i wyłącznie w oparciu o oversampling sygnału, mamy zatem do czynienia nie tylko z drastycznym obniżeniem efektywnej częstotliwości próbkowania, ale także z efektem „ubocznym” w postaci filtracji dolnoprzepustowej. Oczywiście w niektórych przypadkach taki sposób działania będzie miał swoje istotne zalety, ale w dobie „wyścigu o gigasample” raczej nie należy traktować nadpróbkowania jako uniwersalnego remedium na wszystkie bolączki użytkowników związane z niską rozdzielczością ADC.

Od kilku lat na rynku można zauważyć bardzo ciekawy trend – coraz więcej oscyloskopów ma wbudowane przetworniki analogowo-cyfrowe o natywnej rozdzielczości 12-bitów. Powoli stają się one nowym standardem na rynku DSO (a częściowo także MSO), co stanowi niebywale pozytywną zmianę zwłaszcza dla „analogowców” – czyli konstruktorów urządzeń mixed-signal i rozwiązań czysto analogowych.

Wysoka rozdzielczość (możliwość rozpoznania 4096 poziomów napięcia zamiast standardowych 256) jest jednak niezwykle cenna także w pracy nad systemami wbudowanymi, a w szczególności urządzeniami niskomocowymi oraz systemami IoT. Poszerzony zakres dynamiki umożliwia efektywniejsze badanie np. przebiegów prądu zasilania w różnych fazach pracy urządzenia – mając do dyspozycji niskoszumny oscyloskop 12-bitowy można (bez konieczności przestawiania wzmocnienia kanału wejściowego) mierzyć zarówno prąd spoczynkowy (np. w zakresie pojedynczych mikroamperów), jak i piki prądu obecne podczas wybudzania procesora w celu wykonania obliczeń czy też w trakcie nadawania sygnałów przez moduł bezprzewodowy.

Doskonałym przykładem możliwości oferowanych przez współczesne oscyloskopy z przetwornikami 12-bitowymi jest „podejrzenie” sygnału wyjściowego generatora arbitralnego – mając do dyspozycji stosunkowo niedrogi oscyloskop DHO4000 marki Rigol (fotografia 7) można bez większego problemu przeanalizować schodkowy przebieg wynikający z kwantyzacji napięcia (rysunek 4).

Dodatkowe uśrednianie pozwala wyczyścić oscylogram z niepożądanego szumu , co w efekcie jeszcze lepiej uwydatnia rzeczywisty kształt sygnału na poziomie „mikroskopowym” (rysunek 5).

Sama rozdzielczość to jednak nie wszystko. Do pełni szczęścia potrzeba bowiem jeszcze niskiego poziomu szumów własnych front-endu analogowego zastosowanego w oscyloskopie – zwiększenie rozdzielczości bitowej w praktyce nie przyniesie żadnych korzyści, jeżeli słaby sygnał użyteczny zaginie w morzu szumów wejściowych. Dlatego właśnie producenci 12-bitowców podają informację o poziomie szumu tuż obok rozdzielczości ADC – i na tym polu także toczy się rynkowa walka pomiędzy czołowymi producentami aparatury pomiarowej. W przypadku wspomnianej wcześniej serii DHO4000 mamy do czynienia z deklarowanym poziomem szumów rzędu 18 μV, ale bez informacji o warunkach pomiaru – tymczasem parametr ten zawsze należy odnieść do szerokości rozpatrywanego pasma oraz nastawy wzmocnienia kanału. I tak, oscyloskopy z rodziny 6 Series B MSO marki Tektronix (fotografia 8) oferują poziom szumu poniżej 55 μV przy czułości 1 mV/dz. i to w szerokim paśmie do 1 GHz.

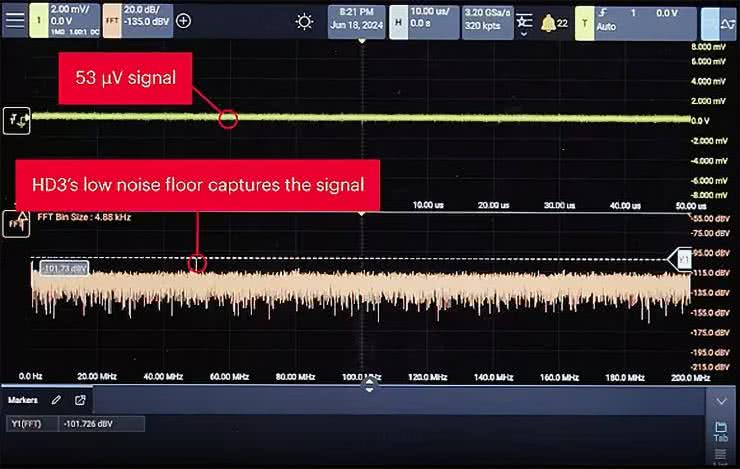

Przy rozszerzeniu rozpatrywanego pasma do 10 GHz trzeba już liczyć się z wartością na poziomie 1,25 mV @ 50 mV/dz. Podobne osiągi w paśmie do 1 GHz (50 μV rms) oferuje seria HD3 marki Keysight (fotografia 9) – tutaj jednak mamy do czynienia z jeszcze lepszymi, bo aż 14-bitowymi (!) przetwornikami ADC.

Producent pokazał zresztą na stronie produktu imponujący przykład pomiaru sygnału na poziomie 53 μV, który udało się namierzyć w widmie FFT i to naprawdę całkiem wyraźnie (rysunek 6).

I jeszcze jeden przykład, tym razem ze stajni Teledyne LeCroy – niektóre oscyloskopy z serii WaveMaster 8000HD (fotografia 10) oferują średni poziom szumu RMS (przy czułości 5 mV/dz.) dochodzący do 376 μV/dz., zaś w tym samym modelu wartość ta rośnie do 21,95 mV przy wzmocnieniu 1 V/dz. Bardzo słaby wynik? Nie do końca, zwłaszcza jeżeli uwzględnimy fakt, że szum jest tutaj rozpatrywany w pełnym paśmie do 20 GHz!

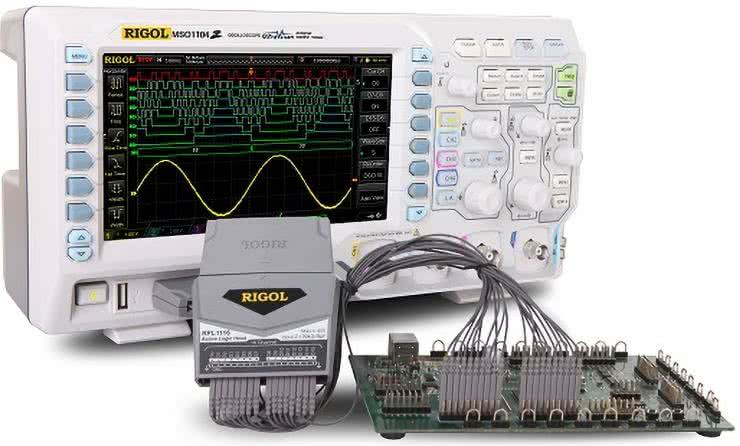

Mieszanka wybuchowa, czyli oscyloskopy do badania sygnałów mieszanych

Kolejnym wyraźnym trendem na rynku oscyloskopów cyfrowych jest upowszechnienie funkcji przeznaczonych do dekodowania sygnałów na liniach cyfrowych (np. I²C, SPI, UART, CAN czy USB). Do niedawna taka funkcjonalność była zarezerwowana tylko na użytkowników z dość zasobnym portfelem, których stać było na zakup w pełni wyposażonego sprzętu wraz z odpowiednią (zwykle kosztowną) sondą logiczną. Sytuacji na rynku nie zmieniło też udostępnienie tanich oscyloskopów z funkcją MSO, w tym popularnej serii DS1000Z Plus marki Rigol (fotografia 11) – z praktyki autora, a także przeglądu licznych materiałów internetowych, jasno wynika, że raczej niewielu użytkowników decydowało się na zakup dodatkowej sondy logicznej i raczej wybierało inne opcje – dekodowanie za pomocą czterech kanałów analogowych (fotografia 3) albo zakup zewnętrznej przystawki USB pełniącej rolę (znacznie bardziej zaawansowanego i często dużo tańszego niż sama sonda) analizatora stanów logicznych.

Dekodowanie z kanałów analogowych nie jest zresztą domeną wyłącznie budżetowych oscyloskopów – doskonałe implementacje takiej funkcji można znaleźć m.in. w serii DSOX3000 marki Keysight (fotografia 12, rysunek 7).

Rozdzielenie funkcji analizatora logicznego i oscyloskopu analogowego nie zawsze jednak jest rozwiązaniem najlepszym. W przypadku systemów mixed-signal poszukiwanie źródeł „dziwnych” problemów układowych (a czasem nawet leżących po stronie oprogramowania) może być bardzo utrudnione, jeżeli akwizycja danych binarnych oraz sygnałów analogowych nie jest właściwie zsynchronizowana. To jest właśnie powód, dla którego klasyczne konstrukcje MSO (fotografia 13, rysunek 8) nie tylko wciąż są dostępne, ale także konsekwentnie rozwijane.

Samo dekodowanie komunikacji szeregowej czy wizualizacja mniejszych magistral równoległych (bądź wielu pojedynczych linii cyfrowych) w sposób synchroniczny z pomiarami analogowymi to jednak niejedyny aspekt istotny w pracy z systemami sygnałów mieszanych. Często równie ważne (albo nawet jeszcze ważniejsze) okazuje się wyzwalanie akwizycji analogowej w momencie wykrycia konkretnego zdarzenia (np. sygnału startu komunikacji I²C czy określonego bajtu w transmisji UART). Zastosowanie gotowej funkcji oczekującej na dane zdarzenie okazuje się niezastąpione zwłaszcza w bardziej złożonych przypadkach, gdyż z najprostszymi warunkami (np. detekcją zbocza opadającego na linii CS układu z interfejsem SPI) poradzi sobie nawet najprostszy oscyloskop bez żadnych dodatkowych opcji cyfrowych.

Od przybytku głowa nie boli (choć czasem może)

Dawniej standardem na rynku oscyloskopów (i to nie tylko cyfrowych, ale także analogowych) były konstrukcje 2-kanałowe, zaś posiadanie czterech wejść było już swego rodzaju luksusem. Przeglądając współczesną ofertę oscyloskopów można jednak dojść do wniosku, że urządzenia dwukanałowe powoli odchodzą do lamusa. Trzeba jednak uczciwie przyznać, że zwielokrotnienie wejść odbywa się w większości przypadków kosztem obniżenia częstotliwości próbkowania oraz pojemności pamięci dostępnej w ramach pojedynczego kanału – to ograniczenie dotyczy praktycznie wszystkich konstrukcji budżetowych oraz znacznej części urządzeń ze średniej półki cenowej, a przyczyną jest (a jakże!) konieczność cięcia kosztów.

Dlatego też wartości maksymalnego samplingu oraz długości rekordu, które znajdujemy w opisach katalogowych, dotyczą często pracy w trybie jedno-, maksymalnie dwukanałowym – warto o tym pamiętać, gdyż nierzadko przy włączeniu wszystkich czterech kanałów jednocześnie nie będzie nawet możliwe skorzystanie z pełni oferowanego przez oscyloskop pasma. Dotyczy to urządzeń, które oferują relatywnie niewielki zapas próbkowania – czyli tych, w których częstotliwość próbkowania jest zaledwie kilkukrotnie wyższa od górnej częstotliwości granicznej sygnału mierzonego. Czyli – w praktyce – znakomitej większości urządzeń dostępnych na rynku! Mowa oczywiście tylko o tych oscyloskopach, w których przetworniki A/C są współdzielone pomiędzy kanałami – konstrukcje z niezależnymi torami akwizycji są pozbawione tej wady, ale z reguły wypadają one nieporównanie drożej od oscyloskopów z przeplataniem.

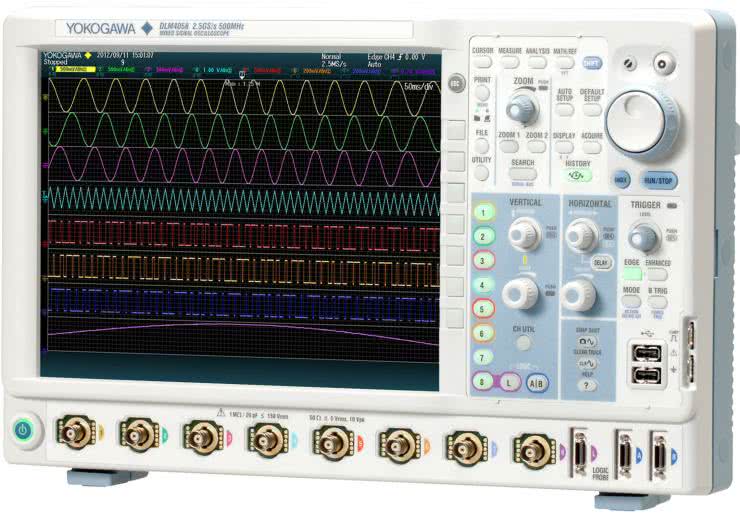

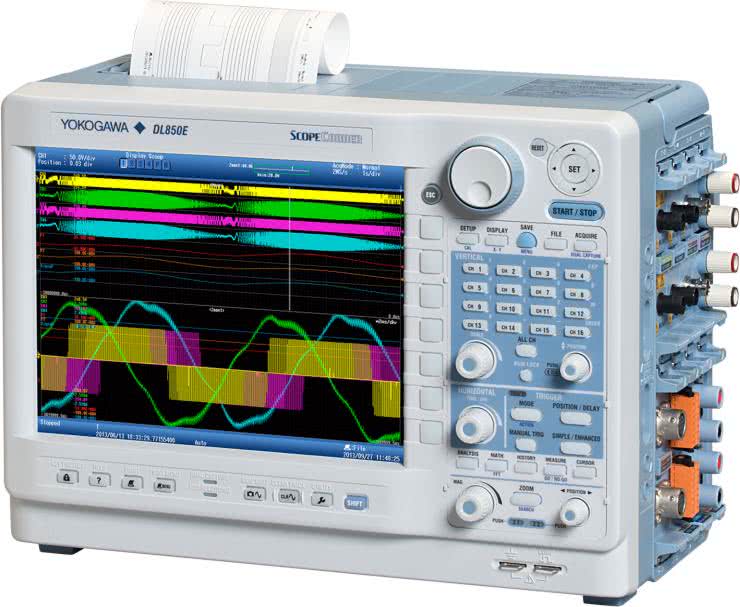

A co z modelami o jeszcze większej liczbie kanałów? Swego czasu potentatem na rynku oscyloskopów wielokanałowych (fotografia 14) czy też rejestratorów oscyloskopowych (fotografia 15) była firma Yokogawa.

I choć 6- czy 8-kanałowe „potwory” wciąż nie są częstym widokiem na laboratoryjnych stołach, to sytuacja powoli zmienia się także w tym zakresie, a kolejni producenci opracowują nowe modele zaawansowanych oscyloskopów przeznaczonych do aplikacji wymagających jednoczesnej obserwacji przebiegów w wielu punktach układu. Jako przykład niech posłuży nam 8-kanałowy oscyloskop MXR608B marki Keysight (fotografia 16) – pomiary w paśmie do 6 GHz, we wszystkich kanałach jednocześnie, mogą być prowadzone z maksymalnym próbkowaniem 16 GSa/s.

Cena katalogowa? „Jedyne” 153 tysiące dolarów amerykańskich. Dla porównania pierwszy (i chyba jak dotąd jedyny) budżetowy oscyloskop 8-kanałowy, czyli DHO5000 marki Rigol (fotografia 17) oferuje pasmo 1 GHz i próbkowanie 4 GSa/s, ale tylko przy aktywnych 4 kanałach z tej samej grupy (parzyste/nieparzyste). Przy włączonych 8 kanałach ostatnia wartość spada do 2 GSa/s. Cena? Około 77 tysięcy złotych.

Lekko i przyjemnie, czyli o potędze odchudzania

Na koniec naszego zestawienia pozostawiliśmy jeszcze jeden trend, bardzo wyraźny zwłaszcza na przestrzeni 2...3 ostatnich lat. Chodzi o coraz powszechniejsze konstrukcje oscyloskopów typu tablet oraz zbliżone rozwiązania niskoprofilowe. Sztandarowym przykładem, w którym należy upatrywać początku ekspansji „płaskich oscyloskopów”, jest rodzina MSO Series 2 marki Tektronix (fotografia 18).

Urządzenia z tej serii są wyposażone w 10-calowy wyświetlacz dotykowy, a nowoczesny design podkreśla dodatkowo ciemnoszara kolorystyka i minimalistyczny design panelu frontowego. Sprzęt jest tak lekki, że z powodzeniem daje się zamontować na typowym wysięgniku przeznaczonym do podwieszania monitorów komputerowych z montażem VESA 100 mm. Pomysł podchwyciły inne marki, w tym wielokrotnie już przywołany w niniejszym artykule Rigol – seria DHO800 także może pracować „w powietrzu”, co pozwala zaoszczędzić niemałą przestrzeń na stole roboczym (fotografia 19).

Nieco inną konstrukcję mają coraz popularniejsze urządzenia przenośne, które wprawdzie nie mogą konkurować z opisanymi wcześniej oscyloskopami stacjonarnymi, ale doskonale sprawdzają się w rozmaitych zastosowaniach polowych. Przykład? Oscyloskop typu „tablet” marki Owon z serii TAO3000 (fotografia 20) – solidna obudowa z ochronnym ogumieniem pozwala przyrządowi „przeżyć” nawet niezbyt przyjazne warunki eksploatacji, a duży ekran dotykowy umożliwia wygodną obserwację mierzonych sygnałów, nawet z nieco większej odległości.

Podsumowanie

Rynek oscyloskopów podąża za zmianami dokonującymi się w całej naszej branży. Spadek cen komponentów (w tym wydajnych procesorów czy obszernych i szybkich układów pamięci) napędza rozwój aparatury pomiarowej nie tylko od strony konstrukcyjnej (cyfrowe nowinki łatwo przenikają do świata „pomiarówki”), ale także aplikacyjnej – funkcjonalność współczesnych oscyloskopów w dużej mierze jest podyktowana potrzebami projektantów systemów wbudowanych, którzy muszą stale nadążać za zmieniającymi się standardami, m.in. rozwojem interfejsów USB czy DDR.

Równocześnie transformacji ulega także obraz rynku oscyloskopów widziany od strony ergonomii – urządzenia stają się lżejsze, rozmiary ekranów rosną, ale… odbywa się to kosztem stopniowej redukcji klasycznych elementów obsługowych, czyli pokręteł i przycisków. Nie da się ukryć, że forma współczesnych oscyloskopów coraz bardziej zaczyna przypominać rozwiązania znane z elektroniki konsumenckiej, w tym przede wszystkim smartfonów czy tabletów – skrajnym przykładem może być popularny ostatnimi czasy oscyloskop Fnirsi 1013D, który jest już obsługiwany w całości za pomocą ekranu dotykowego (fotografia 21).

Przemiany w opisywanym segmencie rynku aparatury laboratoryjnej prawdopodobnie zaczną niebawem nieco przyhamowywać – dalsze zwiększanie pasma w momencie, gdy najszybsze oscyloskopy są w stanie pracować w paśmie rzędu 100 GHz, wydaje się już niebywale trudne. Można się spodziewać, że ciężar gatunkowy będzie powoli przesuwał się w stronę rozwoju aplikacji wspomagających automatyczne testy rozmaitych protokołów, dopracowywania wydajności obliczeniowej w czasie rzeczywistym czy też dalszego poprawiania ergonomii obsługi urządzeń. Niezależnie od tego, w jakim kierunku pójdzie rynek oscyloskopowy, z pewnością będziemy trzymać rękę na pulsie i informować naszych Czytelników o kolejnych urządzeniach i trendach wartych uwagi współczesnego konstruktora.

inż. Przemysław Musz, EP

Zaloguj

Zaloguj