Badania „Mind of the Engineer” przeprowadzane są co dwa lata przez siostrzane periodyki EE Times i EDN. W ankiecie z roku 2020 wzięło udział prawie 1500 inżynierów z wielu dziedzin inżynierii, rynków i regionów. Ankieta ujawnia nowe informacje na temat satysfakcji z pracy, zawodu i nowych technologii, które zostały wdrożone.

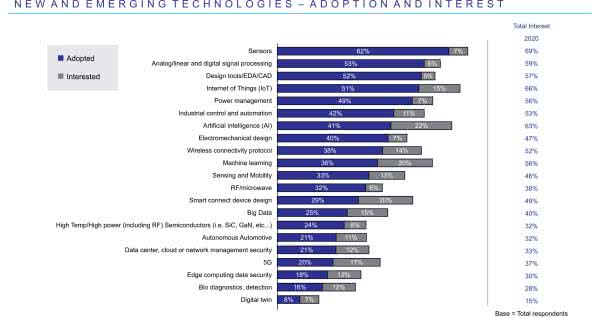

Na rysunku 1 zawarte są wyniki odpowiedzi na pytanie „Które nowe technologie już zastosowałeś i jesteś zainteresowany ich przyjęciem w ciągu najbliższych dwóch lat?” [1]. Wśród nowych i powstających technologii pierwsze miejsce zajmują czujniki, a następnie analogowe i cyfrowe przetwarzanie sygnałów oraz zarządzanie energią. Te dyscypliny stanowią główne elementy składowe Internetu Rzeczy. Szybką przemianę przechodzą narzędzia projektowe, takie jak płytki referencyjne (i uruchomieniowe) oraz pakiety do tworzenia oprogramowania (SDK). Sztuczna inteligencja jest najbardziej interesującą technologia do przyjęcia w ciągu najbliższych dwóch lat. Aż 80% ankietowanych stwierdziło, że są zachęcani przez ich firmy do kreatywnego myślenia (nieszablonowego), z czego 34% określiło poziom tych działań jako „zdecydowany”, a 46% jako „nieco”. Nowością jest to, że utworzenie czegoś zupełnie nowego jest najwyższym priorytetem na całym świecie, a szczególnie wśród inżynierów w krajach EMEA.

Większość inżynierów przyznaje, że czuje się komfortowo w pracy zespołowej, choć doceniliby większy kontakt z rówieśnikami spoza własnej firmy. Ten impuls mógł być kiedyś zaspokojony poprzez obecność na targach i konferencjach, ale pandemia COVID-19 całkowicie to zamknęła. Utrudniło to również kontakt z rówieśnikami w firmach.

Wielodyscyplinarna integracja i mieszanie kompetencji w całym łańcuchu projektu nieuchronnie prowadzi do rosnącego zapotrzebowania na wiedzę specjalistyczną w wielu dziedzinach technologii. W tym przypadku dołączanie nowych inżynierów do bardziej doświadczonych zespołów inżynierów jest powszechnym podejściem szkoleniowym. Wybór numer jeden przy wyszukiwaniu informacji to wyszukiwanie za pomocą Google. Inne opcje obejmują bezpośrednie przejście do witryn internetowych producentów lub witryny internetowej dystrybutora produktów elektronicznych, udział w seminarium internetowym, sprawdzenie witryny internetowej z mediami branżowymi oraz telefonowanie lub wysyłanie e-maili do pracownika producenta lub dystrybutora. Kolejność preferencji zmienia się, czasami znacząco, w zależności od tego, co robi inżynier. Serwis internetowy YouTube stał się repozytorium ogromnej liczby samouczków o prawie wszystkim. Nowi inżynierowie znacznie częściej polegają na tych materiałach. LinkedIn, jako forum do profesjonalnego gromadzenia informacji, wyraźnie przoduje w stosunku do innych platform i mediów społecznościowych (Facebook, Twitter, Wechat itp.).

Co mówią inżynierowie?

Informacje z ostatniego raportu Farnell IoT Trends Report 2020 pokazują aktualny obraz problemów Internetu Rzeczy [5]. Raport powstał na podstawie ankiet uzyskanych w roku 2019 od 2015 inżynierów IoT. Na pytanie „Co według Ciebie jest najważniejszym aspektem do rozważenia przy opracowywaniu rozwiązań IoT?”, aż 47% osób uważa bezpieczeństwo i ochronę danych. Najczęściej używane języki programowania urządzeń IoT to: C – 70%, Python – 47% oraz Javascript – 22%. Jednak przy programowaniu z rozwiązaniami z użyciem chmury obliczeniowej jest inaczej: Python – 52%, Javascript – 42% oraz Node – 24%. Okazuje się, że jest ścisła zależność pomiędzy rodzajem użytej platformy sprzętowej i zastosowanym językiem programowania. Moc obliczeniowa dostępna w mikrokontrolerach wzrosła do tego stopnia, że zredukowana wersja jądra Pythona może być uruchomiona na mikrokontrolerze, który kosztuje tylko kilka dolarów. Istnieją już popularne porty open source dla Pythona, takie jak MicroPython, które są dostępne w dla kilkunastu układów.

Z raportu wynika, że komputery jednopłytkowe są nadal preferowanymi platformami do tworzenia produktów końcowych. Wyniki pokazują, że 54% programistów używa komputerów jednopłytkowych (takich jak Raspberry Pi, BeagleBone Black, Arduino itp.), ponieważ są one gotowe do użycia, pomagają przyspieszyć czas wprowadzenia produktu na rynek oraz zminimalizować koszty i ryzyko. Inni wolą używać własnych projektów (30% respondentów) lub platform programistycznych dostarczanych przez dostawców krzemu (13%).

Projektowanie urządzeń z zastosowaniem modułów SiP może skrócić czas wprowadzania na rynek. Podstawową zaletą użycia modułu SiP jest brak konieczności certyfikowania systemu przed wprowadzeniem na rynek. Moduły wiodących producentów mają certyfikację praktycznie na cały świat. Zastosowanie modułu SiP ułatwia projektantom użycie najnowszych technologii, bez konieczności zdobywania wiedzy w obszarach, w których projektanci SiP zapewniają dobre rozwiązanie.

Podobnie raport ujmuje preferowane bezprzewodowe protokoły komunikacyjne. Przy dołączeniu do chmury obliczeniowej to: Wi-Fi – 67%, Cellular (4G/LTE) – 38%, Bluetooth (BLE 5.0) – 35% oraz LoRa – 21%. Coraz częściej stosowane są moduły przeznaczone do komunikacji komórkowej LTE. Dostępne są moduły z obsługą standardu NB-IoT oraz LTE-M. Moduły te pozwalają rozszerzyć obszar zastosowań technologii LTE o systemy wymagające niedużej maksymalnej przepustowości, bardzo niskiego poboru mocy, a także niskiej złożoności.

Deklarowany jest dziesięcioletni czas pracy z jednej baterii. Czyli bardzo porównywalnie z wynikami dla komunikacji ze standardem Bluetooth 5 i IEEE 802.15.4. Zaletą tego rozwiązania jest gwarancja zasięgu, wadą – opłata abonamentowa.

Na podstawie wyników ankiety 49% już korzysta ze sztucznej inteligencji we wdrażaniu IoT, uczenie maszynowe (ML) jest najczęściej używanym rodzajem sztucznej inteligencji z 28% popularnością, a następnie AI w chmurze (19%). Jednak 51% respondentów waha się przed korzystaniem ze sztucznej inteligencji, ponieważ są nowicjuszami w tej technologii lub poszukują specjalistycznej wiedzy na temat wdrażania sztucznej inteligencji.

Niedawne badanie IoT Adoption Survey 2020 przeprowadzone przez IoT World Today potwierdza ten pogląd, a 57% respondentów twierdzi, że będzie używać sztucznej inteligencji i uczenia maszynowego do monitorowania wydajności. Jednocześnie zdalne monitorowanie i inne technologie IoT w produkcji napotkały wolniejszy niż oczekiwano rozwój.

Tak jest teraz

Jest wiele obszarów IoT, które odnotowały intensywny rozwój w ostatnim czasie, jednak niektóre nowe rozwiązania mogą decydować o postępie w obrębie całej dziedziny.

Sztuczna inteligencja dla standardowych układów SoC

Firma Nordic Semiconductor nawiązała współpracę z Edge Impulse, wiodącym dostawcą narzędzi określanych jako „małe uczenie maszynowe” (lub TinyML), zaprojektowanych do pracy na urządzeniach półprzewodnikowych o ograniczonych zasobach [3]. Wszystkie układy scalone serii nRF52 i nRF53 będą teraz mogły w standardzie korzystać z łatwej w użyciu sztucznej inteligencji i funkcji uczenia maszynowego. Jest to pierwsze takie rozwiązanie w branży półprzewodników z komunikacją Bluetooth. Usunie ono całą złożoność i wcześniejsze bariery technologiczne związane z dodaniem funkcji AI do aplikacji Bluetooth.

Sztuczna inteligencja i uczenie maszynowe na chipach o ograniczonych zasobach przenosi potencjał zastosowań bezprzewodowych technologii IoT, takich jak Bluetooth, na zupełnie nowy poziom pod względem świadomości środowiskowej i autonomicznego podejmowania decyzji. Jednym z przykładów zastosowania są udane projekty śledzenia dzikich zwierząt „ElephantEdge”. Celem było zbudowanie urządzenia do śledzenia dzikich zwierząt, które przyczepia się do słonia za pomocą obroży, aby lepiej chronić ten zagrożony gatunek. Słonie są zagrożone wyginięciem już za 10 lat. Tracker powinien pomóc strażnikom parków zmniejszyć straty zwierząt spowodowane nielegalnym kłusownictwem na kość słoniową, polowaniem na trofea, konfliktami międzyludzkimi i degradacją środowiska.

Sztuczna inteligencja dla nowych układów SoC

Świat zmienił się ze skoncentrowanego na kontroli na skoncentrowany na danych, co wymusza ewolucję architektury procesorów [2]. Obecnie większość procesorów ma architekturę von Neumanna (lub jej modyfikację – Harvard) z pojedynczym zestawem: jednostka sterowania, pamięć, jednostka obliczeniowa (oraz I/O). Pojawienie się AI/ML wymusza zmiany w architekturze pamięci [S43].

Sercem aplikacji AI jest funkcja mnożenia i akumulacji (MAC) lub operacja iloczynu skalarnego. Dwie liczby są mnożone, a wynik jest dodawany do akumulatora. Liczby są pobierane i zapisywane w pamięci. Operacje te są powtarzane wiele razy i stanowią zdecydowaną większość czasu i energii zużywanej zarówno na proces uczenia, jak i na wnioskowanie. Użycie obliczeń w pamięci, w których współczynniki mogą być przechowywane w pamięci „tuż obok” elementu przetwarzającego, radykalnie zmniejsza odległość przesyłania danych. Taka zmiana w architekturze pamięci wiąże się z dużymi konsekwencjami. Niektóre modele programowania, takie jak pamięć trwała (PMEM), wymagają od użytkownika zrozumienia, gdzie znajdują się dane, zastanowienia się, jak je transferować, oraz zapewnienia, że dane znajdują się w odpowiednim miejscu.

Zapotrzebowanie na pamięć AI różni się od potrzeb procesorów graficznych lub procesorów ogólnego przeznaczenia. W każdym tworzonym przez nas systemie zawsze będzie element sterowania. W rezultacie architektura von Neumanna nie odchodzi. Jest to komputer o najbardziej uniwersalnym zastosowaniu i dlatego jest niezastąpiony. W tym samym czasie wiele obciążeń obliczeniowych przenosi się na architektury inne niż von Neumanna. Akceleratory i niestandardowe rdzenie mogą wykonywać znacznie lepszą pracę przy znacznie mniejszym zużyciu energii [S43].

Inteligentne sensory

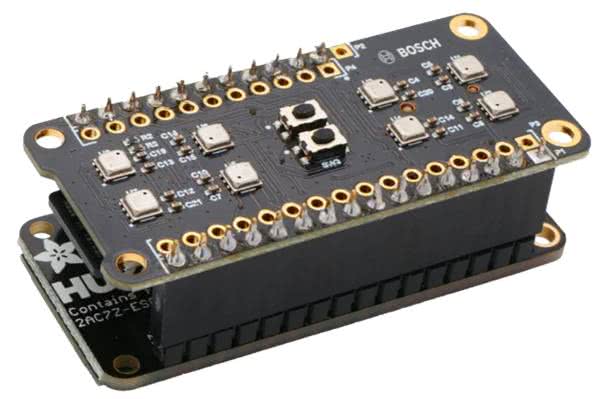

BME688 firmy Bosch Sensortec jest pierwszym czujnikiem jakości powietrza MEMS, który łączy wykrywanie gazu, wilgotności, temperatury i ciśnienia atmosferycznego z funkcją sztucznej inteligencji (AI) [4]. BME688 umożliwia szkolenie czujnika pod kątem niestandardowych zastosowań wykrywania gazów, do takich aplikacji, jak wykrywanie nieświeżego oddechu, wykrywanie psucia się żywności czy wykrywanie powstawania pożarów lasów. Czujnik BME688 jest w pełni kompatybilny wstecz z istniejącym czujnikiem BME680 [S36], ale charakteryzuje się wyższym zakresem rezystancji gazu oraz zawiera specjalizowany układ scalony (ASIC). Ma również specjalny tryb skanowania gazu dla wykrywania lotnych związków siarki (VSC). Czujnik wykrywa teraz obecność wielu gazów, w tym lotnych związków organicznych (VOC), lotnych związków siarki (VSC) i innych rodzajów gazów, takich jak tlenek węgla i wodór, w zakresie części na miliard (ppb).

Nowe oprogramowanie BME AI-Studio umożliwia importowanie, etykietowanie, a następnie wykorzystywanie danych w określonych środowiskach użytkownika do tworzenia niestandardowych algorytmów. Użytkownik kategoryzuje własne dane, a następnie stosuje je przy opracowywaniu swojego modelu AI w BME AI-Studio, zasadniczo szkoląc BME688 w rozpoznawaniu na przykład charakterystycznych oznak wzrostu bakterii na żywności. Po przeszkoleniu czujnika ostateczny kod AI jest uruchamiany na mikrokontrolerze systemowym w produkcie końcowym klienta. Ten kod AI jest ogólnie lekki i będzie działał dość łatwo na zastosowanym mikrokontrolerze, który obsługuje zadania sterowania i zarządzania systemem.

Sensor BME688 został opracowany do zastosowań mobilnych, w których rozmiar i niskie zużycie energii odgrywają kluczową rolę. Czujnik jest umieszczony w kompaktowej obudowie 3,0×3,0×0,9 mm. Pobór prądu można skonfigurować w zakresie od 2,1 µA do 11 mA w zależności od wymaganych szybkości transmisji danych i funkcji. Bosch Sensortec udostępnia wstępnie zaprogramowany i gotowy do użycia zestaw uruchomieniowy BME688 Development Kit (fotografia 1). Dzięki 8 czujnikom BME688 na płytce pośredniej/przejściowej (shuttle board) BME688 można testować i zbierać dane z więcej niż jednej konfiguracji w tym samym czasie. To znacznie zwiększa statystyki i skraca czas opracowania. Zestaw pracuje z modułem Adafruit Huzzah32 – ESP32 z wpisanym oprogramowaniem Bosch. W zestawie jest też karta 16 GB microSD zawierająca pliki konfiguracyjne. Można również użyć płytki BME688 Breakout Board zgodnej z Raspberry PI 1B-4B oraz Zero.

Pandemia COVID-19

Firmy technologiczne odgrywają kluczową rolę w walce z pandemią COVID-19. Działania obejmują kilka obszarów.

Układy MEMS do testów genetycznych PCR

Ostatnio bardzo przyspieszyły prace nad wdrażaniem nowych technologii produkcji wielkoskalowej szybkich, tanich, dokładnych czujników do wykrywania wirusa SARS-CoV-2 [S40]. Większość dostępnych obecnie testów wirusowych, jest przeprowadzana przy użyciu technologii RT-PCR (real-time reverse transcription polymerase chain reaction – łańcuchowa reakcja polimerazy w czasie rzeczywistym). Jest to test genetyczny, który pozwala na wykrycie RNA wirusa w próbce pobranej od pacjenta. Technologia MEMS dodaje dwie główne zalety do techniki PCR: zmniejszenie rozmiaru i integrację techniki mikroprzepływów (microfuidic).

Grzejniki i komory reakcyjne w skali MEMS mają niewielką masę termiczną, co zapewnia znacznie szybszy cykl grzania/chłodzenia i umożliwia osiągnięcie szybkiego wyniku w ciągu kilku minut. Integracja mikroprzepływowa do obsługi próbek i odczynników umożliwiła nowe techniki niemożliwe w skali makro, takie jak cyfrowa PCR (dPCR). Metoda cyfrowej PCR wykorzystuje kanały mikroprzepływowe do podziału próbki pacjenta na wiele pojedynczych próbek, między matrycami mikrodołków lub emulsjami mikrokropelek (ta ostatnia jest znana jako cyfrowa PCR kroplowa lub ddPCR). Mikropróbki następnie poddawane są równoległym procesom PCR, które po agregacji generują całkowitą liczbę cząsteczek docelowych w próbce.

To równoległe przetwarzanie próbki w mikroskali znacznie poprawia dolną granicę wykrywalności, zwiększając w ten sposób dokładność wyniku testu [15].

Amerykańska Agencja ds. Żywności i Leków (FDA) wydała 21 marca 2020 firmie Cepheid specjalne zezwolenie na sprzedaż nowego testu molekularnego do szybkiego wykrywania wirusa SARS-CoV-2 [15]. Ponadto w dniu 8 maja 2020 r. Cepheid otrzymał na ten test certyfikat europejski CE-IVD. System GeneXpert został zbudowany z myślą o testach laboratoryjnych PCR o jakości referencyjnej – na miejscu w centrach medycznych i szpitalach lub bliżej pacjenta w klinikach zdrowia i domach opieki. Mniejsze systemy GeneXpert są skonfigurowane z dwoma lub czterema modułami – co oznacza, że można jednocześnie uruchomić do czterech różnych testów. Testy nowej generacji Xpert Xpress SARS-CoV-2 pozwalają wykryć wirusa SARS-CoV-2 w ciągu ok. 30 min. Wynik ujemny jest dostępny po 45 minutach. Czas przygotowania próbki z wymazu nie przekracza minuty.

Automatyzowanie nadzoru dystansu społecznego

Dwie technologie, mogą odgrywać kluczową rolę w zapewnianiu bezpieczeństwa publicznego w życiu codziennym: technologie bezdotykowe oraz technologie bezprzewodowe krótkiego zasięgu, takie jak Bluetooth Low Energy (BLE) i Ultra-wideband (UWB) [S25]. UWB to technologia bezprzewodowa o niskiej mocy, która może przesyłać dane na krótkie odległości i jednocześnie umożliwia wysoką dokładność lokalizacji w pomieszczeniach [S44].

Firma Estimote produkuje urządzenia do noszenia w miejscu pracy, aby pomóc zabezpieczyć pracowników, umożliwiając szybkie śledzenie kontaktów pracowników z objawami COVID-19. Urządzenia noszą wszyscy w określonym miejscu pracy, takim jak szpital, magazyn, zajezdnia, gospodarstwo, fabryka farmaceutyczna lub sklep spożywczy. Dzięki temu urządzenie do noszenia może automatycznie zarejestrować przez Bluetooth wszystkie fizycznie bliskie interakcje ze współpracownikami. Jeśli u jednego pracownika rozwiną się objawy COVID-19, dane te można natychmiast wykorzystać (za pośrednictwem opracowanego przez firmę Estimote pulpitu nawigacyjnego w chmurze) w celu zidentyfikowania pracowników, którzy mogli być narażeni na wirusa, a przede wszystkim określić czas ekspozycji w minutach, a zatem ryzyko zarażenia. Umożliwia to pracodawcom, w ramach środków ostrożności, zapewnienie natychmiastowej izolacji osób o średnim i wysokim ryzyku jednocześnie umożliwiając kontynuowanie pracy osobom o niskim lub zerowym ryzyku.

Badania przesiewowe przed diagnostyką

Podejmowane są próby zidentyfikowania unikalnych wzorców kaszlu związanych z infekcjami COVID-19. Pozwala to na tworzenie mechanizmów przesiewowych przed diagnostyką, które mogą pomóc spowolnić rozprzestrzenianie się wirusa. SensiML, spółka zależna QuickLogic, która opracowuje rozwiązania programowe dla urządzeń IoT o bardzo niskim poborze mocy, pozyskuje próbki kaszlu z placówek opieki zdrowotnej w celu tworzenia dużych zbiorów danych. Następnie zastosuje algorytmy analizy kaszlu oparte na sztucznej inteligencji do tych zbiorów danych, aby zbudować skuteczny mechanizm przesiewowy COVID-19 [17]. Wieloczujnikowy system z obsługą sztucznej inteligencji analizuje próbki kaszlu, aby przewidzieć, czy ludzie wykazują objawy zakażenia COVID-19. Źródło: SensiML.

Domowy test COVID-19

Testy na przeciwciała, zwane również testami serologicznymi, umożliwiają wykrycie czy ktoś miał wirusa w przeszłości, a nie czy jest on obecnie chory. Mierzą, czy układ odpornościowy pacjenta zaczął wytwarzać przeciwciała przeciwko konkretnemu wirusowi, używając krwi ze standardowego pobrania lub małej próbki z ukłucia palca. Przeciwciała we krwi wiążą się z białkiem osadzonym w pasku testowym, wywołując zmiany kolorów, które pokazują wynik, działając podobnie jak test ciążowy. Na rynek wprowadzono ponad 100 testów przeciwciał na koronawirusa, ale ich dokładność jest różna.

Wykazano, że domowy test COVID-19 firmy Ellume jest bezpiecznym i prostym w użyciu autotestem, który umożliwia osobom sprawdzenie aktywnej infekcji COVID-19 w 15 minut lub krócej (fotografia 2). Test antygenu wykazał 96-procentową dokładność w porównaniu z testem molekularnym z pozwoleniem na użycie w sytuacjach awaryjnych (EUA) w niezależnie prowadzonym badaniu klinicznym w USA w pięciu stanach. Firma Ellume otrzymała EUA od Amerykańskiej Agencji ds. Żywności i Leków (FDA) za swój domowy test COVID-19. Test będzie dostępny bez recepty do objawowego i bezobjawowego wykrywania SARS-CoV-2. (SARS-CoV-2 to koronawirus, który powoduje COVID-19.) Domowy test Ellume COVID-19 to doskonały przykład tego, jak zaawansowana diagnostyka cyfrowa i łączność IoT mogą pomóc w rozwiązaniu najgorszych skutków pandemii SARS-CoV-2 [16].

Przejęcia

Znaczącym trendem w dziedzinie elektroniki są przejęcia przez dużych producentów nowych firm w celu zwiększenia portfolio o produkty w strategicznych obszarach. Sztuczna inteligencja wymaga układów FPGA. Firma Intel przejęła firmę Altera a teraz AMD ma zakupić firmę Xilinx. Firma Infineon przejmuje firmę Cypress. I hit przejęć – ARM ma być przejęty przez AMD.

Lista przejęć jest bardzo długa i może oznaczać zmniejszenie różnorodności oferty rozwiązań układów scalonych.

Sieci bezprzewodowe

Sporo się dzieje w obszarze komunikacji bezprzewodowej. Obejmuje to również obszar inteligentnego domu. Ostatnio projekt CHIP, który wystartował w grudniu 2019 jako inicjatywa firm Amazon, Apple, Google i innych, w celu zunifikowania standardu warstwy aplikacyjnej dla inteligentnego domu, przeobraził się w projekt Matter. Ma on umożliwić współpracę z systemami takimi jak Siri, Google Assistant czy Alexa.

Brakuje powszechnego standardu w pasmie Sub 1 GHz. Pojawiają się nowe propozycje jak MIOTY. Zapowiedziane było rozszerzenie standardu Thread na pasmo Sub 1 GHz.

Co nas czeka

Technologia 2 nm

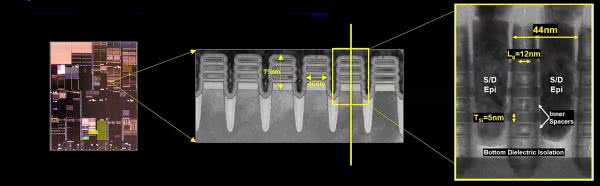

W maju tego roku firma IBM ogłosiła nowy przełom, prezentując pierwszy na świecie chip wykorzystujący technologię procesorową 2 nm [12]. Obecnie układy są wytwarzane najczęściej w procesie 14, 7 lub czasem 5 nm. Dla porównania wirus SARS-CoV-2 ma średnicę „aż” 60...140 nm. IBM zastosował technologię nanopłytek. W tym procesie stosy nanoszeregów krzemu zapewniają strukturę tranzystora zamiast tradycyjnej architektury FinFET (fotografia 3). Odkrycie architektury nanoskładu było częścią wartej 3 miliardy dolarów, pięcioletniej inicjatywy badawczo-rozwojowej, rozpoczętej w 2014 roku w IBM. Nowy projekt 2 nm ma przynieść 45% wyższą wydajność i 75% mniejsze zużycie energii niż dzisiejsze chipy 7 nm. IBM po raz pierwszy zademonstrował 5 nm w 2017 roku, a wprowadzenie go do produkcji zajęło TSMC na Tajwanie trzy lata. Obecnie pracuje nad technologią 3 nm. Pierwsza produkcja chipów 2 nm mogłaby pojawić się w 2024 r. Masowe użycie może nastąpić około 2025 r.

Firma IBM twierdzi, że nowa technologia 2 nm może „zmieścić 50 miliardów tranzystorów w chipie wielkości paznokcia”, czyli 150 milimetrów kwadratowych, co dałoby gęstość tranzystorów 2 nm na poziomie 333 milionów tranzystorów na milimetr kwadratowy. Według tej samej miary, układ TSMC 5 nm ma 171 milionów tranzystorów na milimetr, podczas gdy jego układ 3 nm ma 292 miliony tranzystorów na milimetr kwadratowy. Intel często używa gęstości, aby opisać swoje chipy jako oferujące wyższą gęstość niż konkurenci, nawet przy węzłach 7 nm i 10 nm, częściowo po to, aby obalić argumenty, że opóźnił się we wprowadzaniu nowych technologii. Dane pokazują, że 7 nm Intela ma znacznie większą gęstość niż rozwiązania firm TSMC lub Samsung. Na przykład Intel 7 nm ma szacunkowo 237 milionów tranzystorów na milimetr kwadratowy.

IBM nie produkuje masowo chipów, tak jak robią to TSMC i inne fabryki, ale ogłosił niedawno partnerstwo z Intelem, który tworzy jednostkę biznesową do wykonywania prac kontraktowych w zakresie produkcji chipów. Ponadto Intel inwestuje 20 miliardów dolarów w dwie fabryki w Arizonie i 3,5 miliarda dolarów w nową fabrykę w Nowym Meksyku. Dla porównania, TSMC na Tajwanie planuje zainwestować 100 miliardów dolarów w fabryki chipów w ciągu najbliższych trzech lat, nawet gdy buduje nową fabrykę w Arizonie [13].

Współpraca badawcza firm IBM i Intel będzie koncentrować się na rozwoju logiki i technologii pakowania nowej generacji, co jest wskazówką, o możliwości wspólnej produkcji chipów 2 nm lub wielu innych technologii w nadchodzących latach.

UE podpisuje deklarację o rozwoju procesorów nowej generacji i technologii 2 nm

Chcąc zapewnić Europie miejsce w globalnym ekosystemie projektowania i wytwarzania półprzewodników, 17 państw członkowskich UE podpisało w grudniu 2020 wspólną deklarację, że zobowiązują się do współpracy w opracowywaniu nowej generacji, bezpiecznych procesorów wbudowanych o niskiej mocy i zaawansowanych technologii procesowych do 2 nm [14]. Na tę europejską inicjatywę EU przeznaczy do 145 miliardów euro w ciągu najbliższych 2...3 lat. Uznając fundamentalny charakter procesorów wbudowanych, bezpieczeństwa i najnowocześniejszych technologii półprzewodnikowych we wszystkim, od samochodów, sprzętu medycznego, telefonów komórkowych i sieci po monitorowanie środowiska oraz inteligentne urządzenia i usługi, Komisja Europejska stwierdziła, że jest to powód, dla którego kluczowe branże będą mogły konkurować w skali globalnej i móc projektować i produkować najmocniejsze procesory.

Quantum Computing

Omówienie głównych tematów mechaniki kwantowej jak i technologii zamieszczone w serii artykułów [6].

Zbudowanie i uruchomienie komputera kwantowego jest niezwykle trudne i złożone [7]. Co więcej, wyzwania nasilają się, przy zwiększaniu liczby kubitów (bitów kwantowych) w systemie.

Mimo całej swojej mocy, obliczenia kwantowe nie są po to, aby zabić klasyczne komputery lub wywrócić cały świat do góry nogami. Ponieważ kubity mogą znajdować się w obu stanach, 0 i 1, w przeciwieństwie do konwencjonalnych bitów binarnych, mogą przechowywać wykładniczo więcej informacji. Jednak ich stan jest określany przez prawdopodobieństwo, więc nadaje się tylko do niektórych typów algorytmów. Inne mogą być lepiej obsługiwane przez klasyczne komputery. Zasadniczo, jeśli potrzeba odpowiedzi, to należy uruchomić ten sam program 8000 razy i wtedy otrzymuje się histogram rozwiązań.

Komputery kwantowe mogą zostać sparaliżowane przez błędy w postaci hałasu, usterek i utraty kwantowej spójności spowodowane przez wibracje, wahania temperatury, fale elektromagnetyczne i inne interakcje ze środowiskiem zewnętrznym. Utrzymanie stabilności systemu przy niskim poziomie błędów przez dłuższy czas jest kolejnym celem. Jednym ze sposobów osiągnięcia tego jest kriogeniczne chłodzenie sprzętu do poziomu bliskiego zera absolutnego w celu wyeliminowania szumu termicznego.

Czujniki kwantowe

Obliczenia kwantowe oferują ogromne możliwości obliczeniowe dla urządzeń Internetu rzeczy [8]. Już pod koniec 2019 roku „ultraprecyzyjny czujnik kwantowy” został dostarczony na Międzynarodową Stację Kosmiczną. Ale trzeba pamiętać, że technologia kwantowa jest nadal w fazie przejściowej. Uświadomienie sobie potencjału technologii kwantowej w urządzeniach IoT może zająć lata lub może nastąpić wcześniej, gdy naukowcy i programiści będą wzajemnie wykorzystywać swoje postępy. Firmy venture capital ponad dwukrotnie podwoiły pieniądze zainwestowane w kwantowe firmy komputerowe w 2020 roku w porównaniu z poprzednimi latami, a rząd USA przeznaczył 625 milionów dolarów na wieloletnią inicjatywę. Wysiłek opłaci się wykładniczym wzrostem wydajności obliczeń, a „to samo stanie się z czujnikami kwantowymi – będą one od 100 do 1000 razy dokładniejsze niż cyfrowe”.

Możliwe zastosowania obejmują kwantowy system pozycjonowania dla samochodów lub samolotów, który zapewnia niezależne funkcje nawigacyjne bez konieczności stosowania systemów globalnego pozycjonowania satelitarnego (GPS).

Teleportacja kwantowa

Można śmiało powiedzieć, że komputery kwantowe oznaczają koniec konwencjonalnej kryptografii. Oczywiście ma to wpływ na technologie takie, jak blockchain, które mają wspierać systemy finansowe przyszłości. Gdy komputery kwantowe zostaną w pełni rozwinięte, komputer wykorzystujący algorytm Shora, kwantowy algorytm wielomianu w czasie do rozkładania na czynniki całkowite, będzie w stanie złamać 2048-bitową implementację RSA w zaledwie kilka dni.

Z powodu splątania, informacje w kubicie w jednym punkcie sieci mogą być udostępniane – lub teleportowane – w sposób bezcielesny do innego punktu w sieci. Narodowe laboratorium Fermilab w 2020 roku zademonstrowało teleportację kubitów przez 44-kilometrową sieć światłowodową. Jednym z wartościowych zastosowań teleportacji kwantowej jest dystrybucja kluczy szyfrujących. Nazywa się to dystrybucją klucza kwantowego. Obecne metody dystrybucji kluczy kwantowych są ograniczone odległością. W styczniu 2021 roku chińscy naukowcy donieśli, że stworzyli „pierwszą zintegrowaną kwantową sieć komunikacyjną”, która łączy światłowody na ziemi z dwoma łączami ziemia-satelita, aby uzyskać kwantową dystrybucję klucza na łączną odległość 4600 kilometrów.

Algorytmy kryptografii post-kwantowej są bardziej złożone niż nasze obecne algorytmy [9]. Jednym z głównych wyzwań jest rozmiar samych kluczy. Obecne algorytmy szyfrowania i podpisu mają klucze o długości kilkuset lub tysięcy bitów. Niektóre z proponowanych algorytmów post-kwantowych mają rozmiary kluczy od kilkudziesięciu kilobajtów do czasami megabajta. Oznacza to, że musimy być w stanie efektywnie przechowywać te klucze. Gdy klucze publiczne są używane w certyfikatach infrastruktury klucza publicznego (PKI) i muszą być przekazywane lub przechowywane lokalnie na urządzeniu końcowym, będzie to również kosztować większą przepustowością i pamięcią.

Kolejne duże wyzwanie pojawi się w IoT, gdzie urządzenia końcowe mają już ograniczoną moc zasilania i obliczeniową. Ponieważ przetwarzanie brzegowe i IoT stają się coraz bardziej wszechobecne, ważne będzie, aby te urządzenia były chronione przed atakami kwantowymi. Uważa się, że ciężar przetwarzania algorytmów szyfrowania spadnie na sprzęt, ponieważ oprogramowanie może nie mieć takich możliwości i jest z natury mniej bezpieczne.

Procesory IBM Quantum

Zespół IBM Quantum buduje procesory kwantowe – procesory komputerowe, które opierają się na matematyce cząstek elementarnych, obsługując obwody kwantowe, a nie obwody logiczne komputerów cyfrowych [10]. Dane są przedstawiane za pomocą elektronicznych stanów kwantowych sztucznych atomów znanych jako nadprzewodzące kubity transmonowe, które są połączone i manipulowane sekwencjami impulsów mikrofalowych w celu uruchomienia tych obwodów.

Obecnie pracują ponad dwa tuziny stabilnych systemów w chmurze IBM Cloud, na których można eksperymentować, w tym 5-kubitowe procesory IBM Quantum Canary i 27-kubitowe procesory IBM Quantum Falcon (fotografia 4). W roku 2020 został udostępniony 65-kubitowy procesor IBM Quantum Hummingbird w sieci IBM Q Network. W roku 2021 zadebiutuje 127-kubitowy procesor IBM Quantum Eagle, który oferuje kilka ulepszeń, aby przekroczyć kamień milowy 100 kubitów. W 2023 roku zadebiutuje 1121-kubitowy procesorem IBM Quantum Condor, wykorzystując wnioski wyciągnięte z poprzednich procesorów.

Prognoza na rok 2021

W 2021 r. popyt na nowe aplikacje, technologie i rozwiązania Internetu rzeczy (IoT) będzie napędzany przez połączoną opiekę zdrowotną, inteligentne biura, zdalne monitorowanie zasobów i usługi lokalizacyjne, a wszystko to w oparciu o rosnącą różnorodność technologii sieciowych [19]. Zapanuje chaos w łączności sieciowej. Liderzy technologii zostaną zalani przez szereg opcji łączności bezprzewodowej. Firma Forrester spodziewa się, że wdrażanie technologii 5G i Wi-Fi spadnie do poziomu z 2020 r., Jeśli chodzi o łączność na duże odległości, satelity o niskiej orbicie okołoziemskiej stanowią teraz dodatkową opcję, z ponad 1021 (do 1500) satelitami Starlink zapewniającymi dziś łączność satelitarną. Oczekujemy, że zainteresowanie satelitą i innymi technologiami sieciowymi o niższej mocy wzrośnie o 20% w nadchodzącym roku.

Prognozy produkcyjne na następną dekadę

COVID-19 napędzał nowe technologie produkcji, ale co będzie przez następne 10 lat? Jeśli chodzi o informatykę, prawdopodobnie będziemy świadkami zwiększonego wykorzystania oprogramowania typu open source. Wydaje się, że platforma dla sztucznej inteligencji i produkcji będzie w dużym stopniu open source [18]. Chociaż łączność w chmurze stała się powszechna w przypadku nowych technologii, natura systemów przemysłowego IoT wymaga szybszej reakcji niż jest to możliwe w przypadku systemów opartych na chmurze.

W przyszłości przetwarzanie brzegowe będzie prawdopodobnie bardziej rozpowszechnione w systemach produkcyjnych.

Podsumowanie

Nie dotknęliśmy wielu zagadnień, które mogą być istotne, np. komunikacja z zastosowaniem światła, procesory (rdzenie) DSP, Wi-Fi6, 5G, pozyskiwanie energii z otoczenia lub układy do noszenia i opieki zdrowotnej. Jest pewien problem z raportami o stanie IoT. Uwzględniają one dane sprzed lub z początku pandemii COVID-19. A przez ostatni rok dużo się zmieniło.

Z jednej strony spowodowała ona spory wzrost niektórych zastosowań IoT, z drugiej strony pogłębiający się niedobór elementów elektronicznych, szczególnie układów scalonych, zaczyna być znaczącą barierą nie tylko rozwoju, co nawet bieżącej działalności. O przełomowym rozwoju w dziedzinie elektroniki decyduje współpraca. Szkoda, że wśród krajów włączających się do wizji tego rozwoju zbrakło Polski.

Henryk A. Kowalski

Instytut Informatyki

Politechnika Warszawska

[S25] Dokładna lokalizacja w pomieszczeniach w standardzie Bluetooth v5.1, EP 4/2019

[S36] Pomiar jakości powietrza, ciśnienia, wilgotności i temperatury czujnikiem BME680 dołączonym do zestawu startowego CC1352R1 LaunchPad, EP 4/2020

[S40] IoT w czasach pandemii COVID-19, EP 8/2020

[S43] Układy przyspieszania działania aplikacji Sztucznej Inteligencji bardzo małej mocy, EP 12/2020

[S44] Technika UWB – bardzo szerokiego widma emisji radiowej, EP 1/2021

Bibliografia

[1] Mind of the engineer: Sensors top new technologies adopted, Gina Roos, August 7, 2020, Electronic Products, https://bit.ly/3xDsqUM

[2] Von Neumann Is Struggling, January 18th, 2021, Brian Bailey, https://bit.ly/3gQGIul

[3] Nordic Semiconductor makes AI and machine learning easily accessible on resource-constrained wireless IoT chips for the very first time, 19 Jan 2021, Oslo, Norway, Nordic Semiconductor, https://bit.ly/35K1hUm

[4] BME688, Environmental sensing with Artificial Intelligence, Bosch Sensortec, https://bit.ly/3qf05lh

[5] IoT Trends Report 2020, Farnell Global IoT Survey, September-December 2019, Farnell, https://bit.ly/379YkOQ

[6] Quantum Thoughts, April 17, 2021 Maurizio Di Paolo Emilio, https://bit.ly/2SSup8Y

[7] Quantum Computing in the Cloud-Can It Live Up to the Hype?, Nov 16th, 2020, Sebastian Richter, https://bit.ly/3j1TMzG

[8] Quantum Computing Hits Growing Pains, Peter Bartolik, Apr 23, 2021, https://bit.ly/3vHc1NP

[9] What is Post-Quantum Cryptography? Nov 5th, 2020, Helena Handschuh, https://bit.ly/3qlc2Wr

[10] Quantum Computing, IBM, https://ibm.co/3d1aJ9O

[11] Statistics and Research Coronavirus Pandemic (COVID-19), Our World In Data, https://bit.ly/3zKtqs6

[12] IBM Unveils World’s First 2 Nanometer Chip Technology, Opening a New Frontier for Semiconductors, May 6, 2021, IBM, https://ibm.co/2SRW0qR

[13] IBM marks another creative milestone with 2 nm chip, Matt Hamblen, May 6, 2021, Fierce Electronics, https://bit.ly/3gLtb8D

[14] EU Signs €145bn Declaration to Develop Next Gen Processors and 2nm Technology, December 9, 2020, Nitin Dahad, https://bit.ly/2UhsCuo

[15] MEMS in the Fight Against Covid-19, Alissa M. Fitzgerald, Farzad Khademolhosseini, May 20, 2020, EETimes, https://bit.ly/39j48ob

[16] Ellume selects Nordic’s Bluetooth solution for high volume, FDA-authorized COVID-19 Home Test, 21 Dec 2020, Nordic Semiconductor, https://bit.ly/3vLJ2bD

[17] 4 design venues to watch in the fight against the COVID-19 pandemic, August 12, 2020, Majeed Ahmad, https://bit.ly/3vNeZ3k

[18] Manufacturing Predictions for the Next Decade, Rob Spiegel, Mar 02, 2021, DesignNews, https://bit.ly/3vH2R3K

[19] Predictions 2021: Technology Diversity Drives IoT Growth, Michele Pelino, OCT 28 2020, Forrester Research, https://bit.ly/3j1Apag

Zaloguj

Zaloguj