Swą popularność Ethernet zawdzięcza wielu różnym czynnikom, do których przede wszystkim należy jego budowa i odporność na trudne warunki w transmisji. Ponadto tak się złożyło, że rozwój Ethernetu nastąpił w okresie, gdy komputery osobiste zaczęły tanieć, a popularność zaczął zyskiwać Internet. Niskie ceny komputerów pozwoliły osobom prywatnym na posiadanie więcej niż jednego urządzenia tego typu w tzw. gospodarstwie domowym, a możliwość połączenia tych maszyn w sieć dawała dodatkowe korzyści. Oprócz współdzielenia plików i grania w gry komputerowe przez sieć, Ethernet pozwalał też na łatwe dzielenie połączenia internetowego i był tańszy od wielu rozwiązań konkurencyjnych.

Ethernet niejedno ma imię

Słowo Ethernet to jednak dosyć szerokie określenie, które pasuje do wielu rodzajów protokołów i sposobów transmisji danych. Jego specyfikacja została opisana w standardzie IEEE 802.3, a koncentruje się na przesyle danych poprzez drzewiastą strukturę sieciową z węzłami w postaci tzw. końcówek sieciowych, przełączników, routerów i bramek - inaczej niż np. sieć Token Ring, w której konieczne było utrzymanie topologii pierścieniowej.

Jednakże to, co charakteryzuje nowoczesny Ethernet to przede wszystkim protokół IP i możliwość transmisji połączeniowej TCP/IP. Jeszcze w latach 90. ubiegłego wieku, większą popularnością cieszył się prostszy w implementacji protokół ethernetowy IPX, który niestety nie gwarantował takiej pewności i niezawodności transmisji, jak TCP/IP.

Obecnie popularność Ethernetu sprawiła, że rozwiązania typowe dla tego standardu są też implementowane dla łączy radiowych, przystosowywane do pracy w wymagającym środowisku przemysłowym oraz przenoszone na szybsze rozwiązania fizyczne, które pozwalają podnosić efektywną przepustowość transmisji.

Im szybciej tym lepiej

Trzonem rozwoju Ethernetu są klasyczne sieci przewodowe, oparte o łącza elektryczne, wykonane z miedzianej skrętki lub też o światłowodowe.

Wśród rozwiązań konsumenckich trudno wyróżnić technologię dominującą, gdyż bardzo zbliżoną popularnością cieszą się zarówno interfejsy 100-megabitowe (100-Base-TX), jak i gigabitowe (1000-Base-T). Ze względu na niewielkie różnice w cenie oraz fakt, że wiele urządzeń konsumenckich obsługuje multimedia wysokiej rozdzielczości, widać zdecydowany trend związany ze wzrostem popularności interfejsów gigabitowych. Jednakże w przypadku tańszych urządzeń oraz tych, dla których dostęp do Ethernetu jest tylko mało znaczącym dodatkiem, producenci w celu minimalizacji kosztów wciąż instalują układy do Fast Ethernetu.

Rosnąca przepływność multimediów przetwarzanych przez urządzenia elektroniczne sprawia jednak, że coraz częściej nawet interfejs gigabitowy staje się wąskim gardłem w komunikacji elektronicznej. Choć już dawno temu, bo finalnie w 2006 roku, opracowano 10-krotnie szybszy standard dla sieci opartych o skrętkę - 10GBase-T, wciąż nie zyskał on popularności ani wśród rozwiązań konsumenckich, ani w przemyśle. Wynika to po części ze znacznie większego kosztu transceiverów potrzebnych do realizacji takich łączy oraz z faktu, że dla zapewnienia poprawności tak szybkiej transmisji konieczne jest użycie wysokiej jakości złączy i przewodów. Dlatego częściej stosowaną alternatywą jest raczej implementowanie dwóch niezależnych interfejsów gigabitowych i umożliwienie programowego złączenia ich tak, by w sumie służyły jako jedno łącze o przepustowości 2 Gb/s. Takie podeście pozwala zmniejszyć koszty oraz daje szanse na rozbudowę funkcji urządzenia, np. o tworzenie połączeń redundantnych lub o łączenie jednego urządzenia do dwóch sieci jednocześnie. Fakt, że niektóre droższe komputery stacjonarne też mają dwa łącza ethernetowe ułatwia korzystanie z agregowanych połączeń o łącznej przepustowości 2 Gb/s.

Kolejne rozwinięcie standardu Ethernetu przewodowego to IEEE 802.3ba-2010, a następnie 802.3bg i P802.3bj, zatwierdzone w 2011 roku. Mają one pozwolić na transmisję z szybkością do 40 lub 100 Gb/s, na różnych dystansach, zależnych od użytych przewodów. Trzeba jednak zaznaczyć, że odmiana standardu obejmująca transmisję po miedzianej skrętce została zatwierdzona dopiero rok temu i nosi nazwę IEEE P802.3bq. Umożliwia on transmisję z przepustowością do 40 Gb/s na odległości do 30 m, z użyciem skrętki kategorii 8, której specyfikację również określono dopiero rok temu. Alternatywnym medium komunikacyjnym może być też kabel dwuosiowy, podobny do zwykłego koncentrycznego, ale z dwiema żyłami wewnątrz, zamiast jednej. Pozwala on na transmisję sygnału różnicowego, co ma umożliwiać osiągnięcie przepustowości do 100 Gb/s na odległości do 7 m. Dłuższe dystanse można uzyskać tylko z użyciem światłowodów.

Tymczasem, również rok temu, członkowie stowarzyszenia IEEE zaczęli prace nad tzw. Ethernetem terabitowym, który na razie w praktyce ma umożliwić transmisje z przepustowością rzędu 400 Gb/s, a docelowo nawet 1 Tb/s. Na wyniki ich prac trzeba będzie jednak poczekać do 2017 roku, a na pierwsze układy tego typu - jeszcze dłużej.

Drogą radiową

Szybko rozwija się też standard Ethernetu bezprzewodowego, czyli tzw. Wi-Fi (Wireless Fidelity). Standardy z rodziny IEEE 802.11a/b/g/n/ac zyskały na popularności przede wszystkim ze względu na rozwój przewodowego Ethernetu, którego są bezpośrednim rozwinięciem. Zastosowany w Wi-Fi protokół IP oraz przeważająca w zastosowaniach topologia gwiazdy pozwalają łatwo tworzyć bezprzewodowe sieci lokalne, odwzorowujące sposobem działania klasyczny Ethernet. Ewolucja tego standardu na przestrzeni lat skierowana była i jest przede wszystkim w celu zwiększenia szybkości transmisji, a przy okazji wydłużenia zasięgu sieci.

Obecnie najbardziej popularnym standardem Wi-Fi jest IEEE802.11n, który w praktyce wprowadził możliwość komunikacji nie tylko w paśmie w okolicach częstotliwości 2,4 GHz, ale też 5 GHz. Gwoli ścisłości, już wersja 802.11a pracowała na częstotliwości 5 GHz, ale tak naprawdę nigdy się nie spopularyzowała i można było ją znaleźć zaimplementowaną niemal tylko w niektórych urządzeniach przemysłowych. Dopiero wersja 802.11g sprawiła, że Wi-Fi stało się faktycznie powszechnie stosowanym standardem, gdyż jej teoretyczna przepustowość wynosiła nieco ponad połowę przepustowości klasycznej, 100-megabitowej ethernetowej sieci przewodowej. W rzeczywistości jednak uzyskiwane transfery były zdecydowanie niższe niż zakładane i z tego względu urządzenia pracujące zgodnie z IEEE802.11g nie oferowały takiego komfortu pracy, jak nowsze modele.

Dominujący obecnie IEEE802.11n jest natomiast standardem bardzo rozbudowanym, gdyż określa wiele mocno różniących się od siebie trybów pracy oraz zezwala na transmisję w dwóch różnych pasmach radiowych. Wiele z produkowanych modułów i układów zgodnych z IEEE802.11n zapewnia obsługę obu pasm, często jednocześnie, choć tańsze odmiany pracują tylko na częstotliwości 2,4 GHz. Poszczególne modele mogą też się różnić wspieranymi trybami działania, które to decydują o dostępnej szybkości transmisji. Jest to jedna z głównych cech, które powinien brać pod uwagę konstruktor implementujący obsługę sieci Wi-Fi w swoim urządzeniu. Poszczególne tryby pracy wymagają nie tylko różnej mocy obliczeniowej, czy odpowiedniej precyzji układów nadawczo-odbiorczych, ale też zastosowania dodatkowych anten. Podstawowe tryby pracy urządzeń zgodnych z IEEE802.11n obejmowały komunikację za pomocą dwóch jednocześnie przesyłanych strumieni sygnałów, odbieranych i nadawanych za pomocą dwóch par anten. Przy zastosowaniu maksymalnie wydajnego kodowania (64-QAM, 5/6 symboli istotnych), dosyć dużych, bo 40-megahercowych kanałów i minimalnego 400-nanosekundowego odstępu pomiędzy transmitowanymi symbolami, pozwalało to teoretycznie uzyskać przepustowość na poziomie 300 Mb/s. W praktyce jednak zdolność do przestrzennego rozróżniania tych strumieni, przy tak określonych parametrach sygnału jest ograniczona i sprawia, że najczęściej uzyskiwana przepustowość wynosi około 60 Mb/s, nawet, gdy odbiornik znajduje się w pobliżu nadajnika.

Co więcej, niedługo po pojawieniu się pierwszych urządzeń zgodnych z Wi-Fi 802.11n, wielu producentów zaczęło tworzyć wyposażać tańsze odmiany swoich produktów w zubożoną wersję standardu, obsługującą jedynie 1 strumień danych. Zaczęto je określać mianami takimi jak np.: "Wi-Fi 802.11n lite" lub "Wi-Fi n150". W praktyce były one istotnie tańsze w budowie (jedna antena, mniejsze wymagania odnośnie szybkości przetwarzania danych), a uzyskiwana szybkość transmisji kształtowała się na poziomie 40 Mb/s, przy czym producenci mogli chwalić swoje produkty umieszczając na nich logo wciąż wtedy nowego standardu 802.11n.

W momencie, gdy prace nad standardem IEEE802.11n zostały zakończone, został on opublikowany w wersji rozbudowanej o 32 trybów transmisji, z uwzględnieniem komunikacji za pomocą trzech a nawet czterech równoległych strumieni danych, co ma teoretycznie skutkować maksymalną przepustowością na poziomie 600 Mb/s. Trzeba mieć jednak na uwadze fakt, że obecnie bardzo niewiele urządzeń jest wyposażonych w więcej niż dwie anteny i umożliwia pracę w tzw. standardzie "n450", a urządzeń "n600" praktycznie się nie spotyka. Rzeczywista przepustowość tego typu urządzeń dochodzi do około 120-140 Mb/s, ale najczęściej nie przekracza 70 Mb/s, pomijając już fakt, że nierzadko przesył danych w kierunku od urządzenia końcowego do routera lub transfer na kilkumetrową odległość poprzez ścianę jest kilkukrotnie wolniejszy.

Obecnie promowane są jednak przede wszystkim urządzenia zgodne z najnowszą odsłoną standardu Wi-Fi: IEEE802.11ac. Narzuca on obsługę szerokich, 80-megahercowych kanałów i wprowadza opcję bardzo szerokich, bo aż 160-megahercowych kanałów. Opisuje też komunikację za pomocą aż 8 jednocześnie transmitowanych strumieni, oraz zwiększa złożoność modulacji do 256-QAM. Szybkość transmisji uzyskiwanej przy użyciu wielokrotnych strumieni odpowiada odpowiednio zwielokrotnionym przepustowościom podanym w tabeli. W momencie powstawania tego artykułu, na rynku można było znaleźć co najwyżej modele wspierające modulację 256-QAM z kodowaniem 5/6 i obsługą 80-megahercowych kanałów przy 3 strumieniach transmisji, czyli teoretycznie zdolne do uzyskania przepustowości na poziomie 1300 Mb/s. Najbardziej zaawansowane urządzenia mobilne, takie jak telefony komórkowe też są wyposażone w układy do komunikacji zgodnie ze standardem 802.11ac, ale mają tylko pojedyncze anteny i mogą teoretycznie obsłużyć przepustowość do 433 Mb/s. Praktyka pokazuje, że w rzeczywistości nie przekracza ona stukilkudziesięciu megabitów na sekundę.

Warto też wspomnieć o kolejnych planowanych odmianach standardów szybkiej komunikacji radiowej, czyli IEEE 802.11ad i 802.11af. Pierwszy z nich nazywany jest też mianem WiGig i ma korzystać nie tylko z częstotliwości 2,4 GHz i 5 GHz, ale też 60 GHz. Fale o tej ostatniej częstotliwości nie są w stanie przenikać przez ściany, dlatego zaplanowano użycie techniki "Beamforming", która ma pozwolić na takie sterowanie kierunkiem przesyłu sygnały, by można było niezawodnie prowadzić komunikację bezprzewodową na dystansie do 10 m. Szybkość transmisji ma dochodzić do 7 Gb/s. W przypadku standardu 802.11af, czyli tak zwanego White-Fi lub Super Wi-Fi, postawiono natomiast na wydłużenie zasięgu poprzez umożliwienie pracy na wolnych częstotliwościach z zakresów VHF i UHF. Fale w tych pasmach łatwiej przenikają przez ściany, a efektywna maksymalna przepustowość ma zależeć od rodzaju zastosowanej modulacji, kodowania, szerokości kanału i liczby nadawanych jednocześnie strumieni; ma wynosić maksymalnie do 142,4 Mb/s.

Ethernet w przemyśle

Szybki i bardzo konkretny rozwój Ethernetu można odnotować w przemyśle. W ostatnich latach powstało wiele adaptacji technik ethernetowych na potrzeby standardów przemysłowych. Najczęstsze implementacje sprowadzają się do połączenia ze sobą dwóch rodzajów transmisji sieciowej, za pomocą jednego zestawu przewodów. Praktykowane metody polegają np. na podziale czasu transmisji na okna, w których nadawane są klasyczne ramki ethernetowe oraz okna z ramkami priorytetowymi. Alternatywą jest usprawnienie mechanizmów QoS w taki sposób, by ich zasady były ściśle przestrzegane przez wszystkie kluczowe elementy aktywne sieci. Pozwala to na nadawanie wysokich priorytetów danym potrzebnym do realizacji przebiegających procesów i mniejszych priorytetów pozostałym pakietom.

Większość sieciowych standardów ethernetowych powstało w okresie, gdy na rynku konsumenckim dominował klasyczny, Fast Ethernet i dlatego urządzenia je wspierające nie są w stanie korzystać z gigabitowych przepustowości. Zazwyczaj nie jest to problemem, gdyż w sieciach przemysłowych nie przesyła się multimediów i wymogi odnośnie szybkości transmisji danych sprowadzają się przede wszystkim do minimalizacji opóźnień, a nie maksymalizacji przepustowości. Jednakże w ostatnim czasie prowadzone są prace, umożliwiające równoczesne zwiększenie dostępnych szybkości transmisji, przy zachowaniu przemysłowych rygorów pracy. Oczywiście, łatwość aktualizacji konkretnego standardu do wersji opartej o Ethernet gigabitowy zależy przede wszystkim od sposobu, w jaki został on zmodyfikowany, by nadawać się na potrzeby przemysłu. Niemniej, dostępne są już produkty, w pełni wspierające gigabitowe, przemysłowe interfejsy ethernetowe.

Pozostałe rozszerzenia

Na koniec warto dodać, że Ethernet to nie tylko transmisja danych, ale także powiązane z nim dodatkowe usługi i możliwości. Protokoły takie jak SNMP, czy mechanizmy QoS pozwalają na zarzadzanie całymi sieciami, ich zdalną konfigurację, wspomniana już priorytetyzacja ruchu, czy choćby tworzenie sieci wirtualnych. Z punktu widzenia konstruktora, bardzo korzystnym dodatkiem do standardu Ethernet jest PoE, czyli Power over Ethernet.

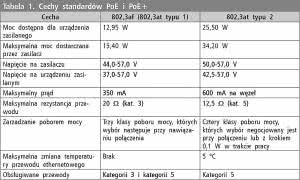

Metoda ta umożliwia przesyłanie prądu w ilościach pozwalających np. na zasilanie sieciowych urządzeń elektronicznych, bez potrzeby stosowania innych źródeł energii. Zatwierdzona w 2003 roku wersja PoE w postaci standardu IEEE 802.3af pozwalała na przesył do 350 mA przez skrętkę ethernetową, przy napięciu z zakresu od 44 do 57 VDC na zasilaczu. Ze względu na opory na przewodzie, urządzenia zasilane musiały być uwzględniać fakt, że odbierane napięcie może mieć napięcie na poziomie od 37 do 57 V. Dostępna w praktyce moc wynosi wtedy niecałe 13 W, co wystarcza niestety tylko dla niektórych urządzeń. Dlatego w 2009 roku, pod oznaczeniem IEEE 802.3at zatwierdzono nową odmianę tego standardu, nazywaną PoE plus lub PoE+. Napięcie na zasilaczu podniesiono do zakresu od 50 do 57 VDC, a maksymalny prąd zwiększono do 600 mA. Jednocześnie standard zakłada korzystanie z przewodów kategorii 5, a nie kat. 3 i kat. 5, co pozwala przyjąć, że w poprawnie wykonanej instalacji, opór na kablu będzie niemal dwukrotnie niższy. W efekcie, napięcie na urządzeniu odbiorczym powinno mieścić się w zakresie od 42,5 do 57 V, a realnie dostępna moc przekracza już 25 W.

Ze względu na popularność przewodów ethernetowych kategorii 5 oraz rosnącą popularność switchy ethernetowych, obsługujących PoE+, implementacja obsługi tego standardu w niedużych urządzeniach sieciowych wydaje się całkiem rozsądnym pomysłem. Warto też pamiętać, że nawet jeśli w istniejącej sieci nie użyto przełączników sieciowych ze zintegrowanymi zasilaczami PoE, to możliwe jest podłączenie dodatkowego zasilacza szeregowo, pomiędzy switch, a urządzenie zasilane. Iniektory PoE i PoE+ są powszechnie dostępne, choć niestety ich ceny nie są małe. Jednakże ich użycie może być dosyć wygodnym sposobem rozwiązania problemu zasilania zdalnych urządzeń sieciowych.

Marcin Karbowniczek, EP

Zaloguj

Zaloguj