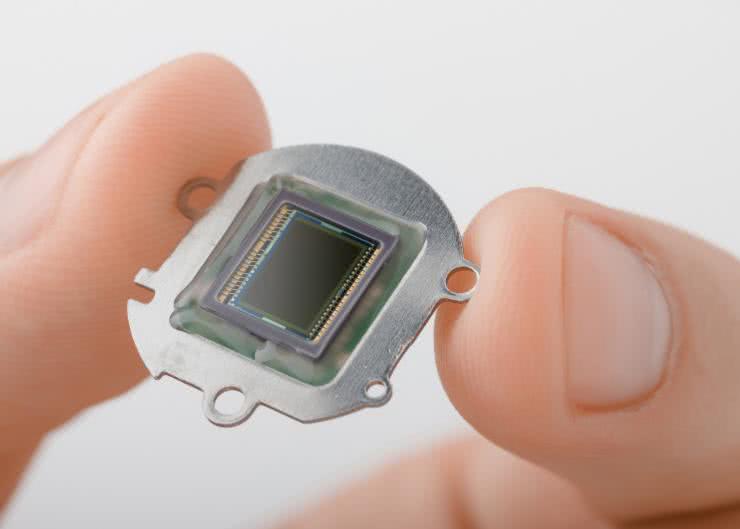

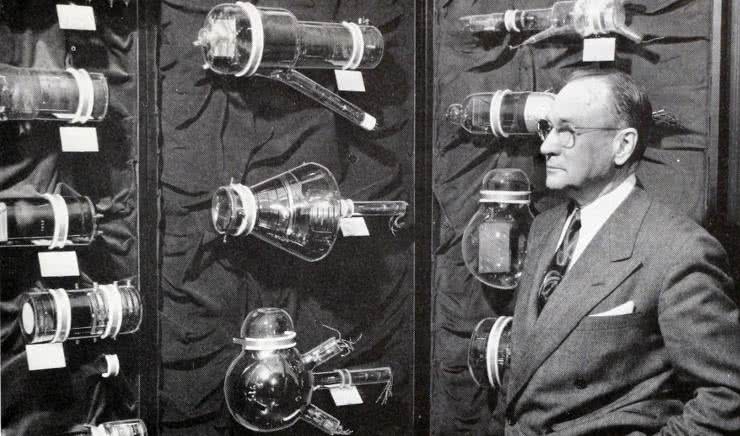

Fotografia cyfrowa zdominowała współczesny świat w każdym jego aspekcie – począwszy od fotografii amatorskiej, poprzez codzienną pracę profesjonalnych fotoreporterów, aż po badania naukowe (i to zarówno te prowadzone z użyciem mikroskopów optycznych, jak i realizowane za pomocą wartych miliony dolarów, sztucznych satelitów obserwacyjnych). Fascynująca historia urządzeń do przetwarzania obrazu na postać sygnału elektrycznego rozpoczęła się na początku ubiegłego wieku i przez przeszło sześć dekad (od lat 30. do lat 90. XX wieku) opierała się na przeróżnych konstrukcjach lamp analizujących (fotografie 1 i 2).

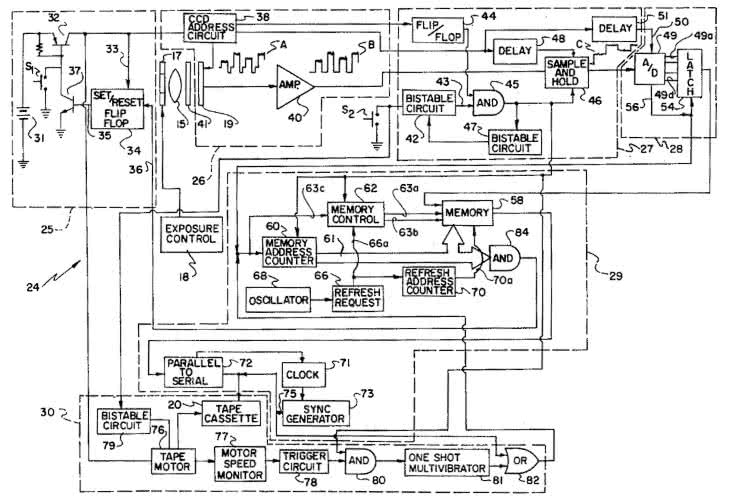

Podwaliny pod fotografię cyfrową położył natomiast w roku 1975 Steve Sasson, który – zaledwie dwa lata po przyjęciu do pracy w laboratoriach firmy Kodak – opracował pierwszy na świecie „samodzielny” aparat cyfrowy (warto dodać, że sam układ CCD o rozdzielczości 8×1 px powstał zaledwie kilka lat wcześniej w Bell Labs, zaś już w 1975 roku Sasson korzystał z matrycy o rozdzielczości 100×100 px). Funkcję nośnika danych pełniła… zwyczajna kaseta magnetofonowa (fotografia 3) – co nie powinno dziwić z uwagi na popularność pamięci taśmowej w dawnych komputerach, choć w połączeniu z (przynajmniej wg dzisiejszej perspektywy) ogromnym aparatem dawało naprawdę uroczy efekt. Czytelników zainteresowanych tym przełomowym wynalazkiem zachęcamy do zapoznania się z patentem nr US4131919 (rysunek 1), zgłoszonym do amerykańskiego urzędu patentowego przez Kodaka w roku 1977.

Po niemal pięciu dekadach od powstania tego wiekopomnego wynalazku możemy korzystać z niewiarygodnie szerokiej gamy przetworników obrazu o tak zróżnicowanych parametrach, że naprawdę trudno dziś wskazać obszar aplikacyjny, do którego nie dałoby się dobrać odpowiedniej matrycy z aktualnej oferty producentów optoelektroniki. W artykule dokonamy przeglądu najważniejszych zagadnień z zakresu konstrukcji i parametrów przetworników obrazu oraz przestrzeni, pokażemy także subiektywny wybór najciekawszych komponentów dostępnych na rynku.

Rodzaje matryc obrazowych

Dywersyfikacja oferty czujników obrazu jest dziś naprawdę ogromna – do grupy tej zaliczają się bowiem nie tyko matryce dwuwymiarowe, ale także liniały CCD i CMOS, stosowane m.in. w skanerach dokumentów, spektroskopach optycznych czy też laserowych czujnikach przemieszczeń. Przykładowe rozwiązania można zobaczyć na fotografii 4.

CCD i przyjaciele, czyli ekspresowy przegląd odmian matryc starszej generacji

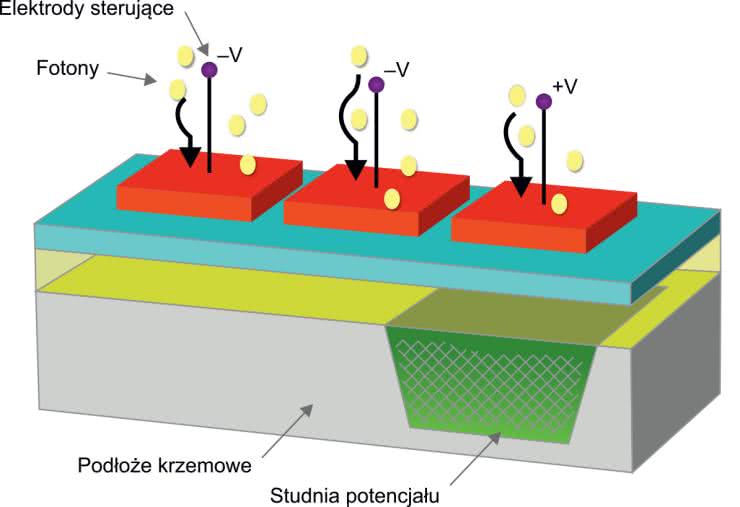

Rozróżnienie dwóch podstawowych grup matryc światłoczułych jest – przynajmniej z grubsza – znane każdemu elektronikowi. Przetworniki CCD (ang. charge-coupled device) zostały opracowane jako pierwsze i przez wiele lat stanowiły fundament fotografii cyfrowej oraz wszelkich innych zastosowań związanych z rejestracją obrazów jedno- i dwuwymiarowych. Podstawa działania matrycy CCD opiera się na gromadzeniu ładunków uwolnionych ze struktury półprzewodnika na skutek zjawiska fotoelektrycznego wewnętrznego. Fotony o odpowiednio wysokiej energii są w stanie „wybić” elektrony, a te zostają następnie wychwycone i zmagazynowane w tzw. studni potencjału, wytworzonej w półprzewodniku przez polaryzację odpowiednim napięciem (rysunek 2).

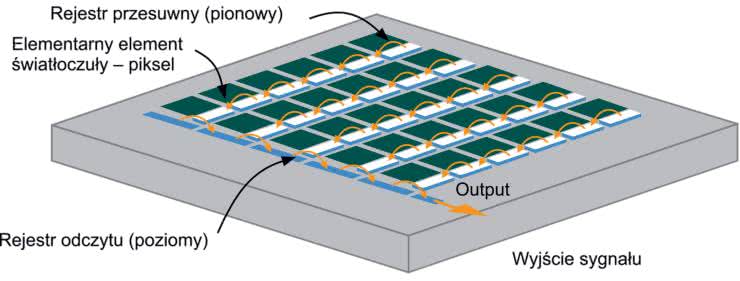

W istocie komórki matrycy można rozpatrywać jako miniaturowe kondensatory MOS – ładunki ze wszystkich kondensatorów w danej kolumnie są kolejno transferowane do wspólnego, przesuwnego rejestru odczytowego, skąd zostają pobrane i zmierzone z użyciem niskoszumnego wzmacniacza ładunku (rysunek 3). Warto dodać, że ładunki są „przepychane” przez kolejne pola kolumny dzięki zastosowaniu odpowiedniej sekwencji napięć sterujących, która może występować w wielu odmianach (różniących się liczbą faz). Ponieważ jednak podstawowa konstrukcja matrycy CCD nie sprawdzała się z powodu dość powolnego odczytu (który siłą rzeczy musiał być dokonywany piksel po pikselu, linia po linii) – równolegle ze zwiększaniem rozdzielczości macierzy – wprowadzane były kolejne innowacje, mające na celu przyspieszenie odczytu sygnałów.

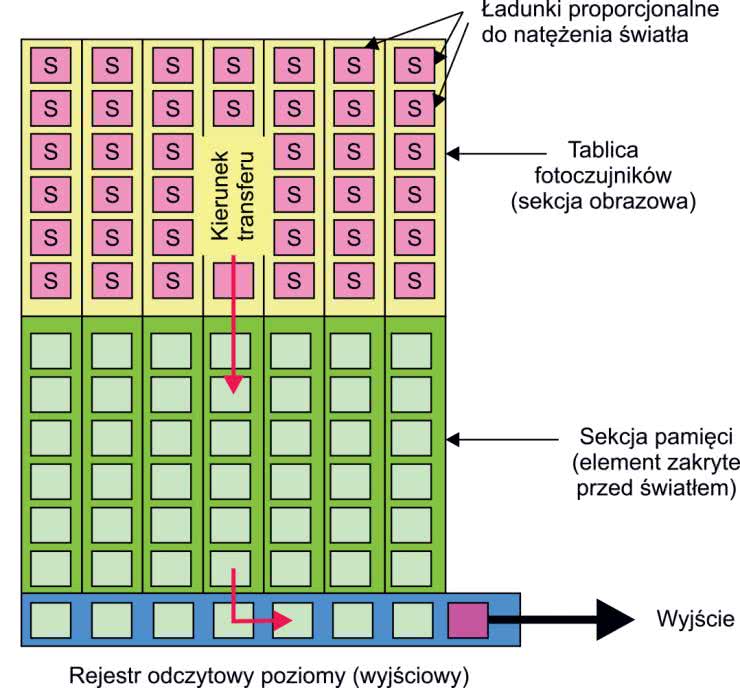

Rozwiązanie pośrednie stanowił podział macierzy na kilka sektorów, wyposażonych w niezależne, przesuwne rejestry odczytowe i układy pomiarowe. Jeszcze lepszym wyjściem okazało się natomiast zastosowanie dodatkowej sekcji pamięci, która – odizolowana od wpływu oświetlenia – mogła przechowywać ładunki z poszczególnych pikseli w celu ich odczytania „offline”, tj. po zakończeniu ekspozycji. W czasie odczytu właściwa macierz światłoczuła mogła już odbierać kolejną ramkę obrazu. Ten typ matrycy, określany jako FT (ang. frame transfer – rysunek 4), zapewniał lepszą dynamikę rejestracji szybkozmiennych scen, ale generował kolejne problemy, związane z powstawaniem artefaktów określanych jako smearing – czyli wyraźnych smug, rozchodzących się wzdłuż kolumn od punktów obrazu o wysokiej jasności (fotografia 5).

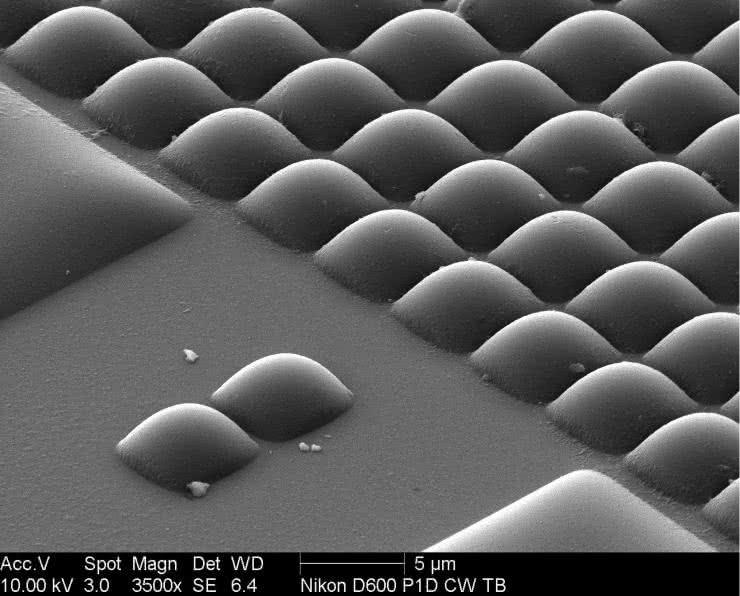

Kolejne „edycje”, określane mianem CCD IT (interline transfer) czy CCD FIT (frame interline transfer), miały na celu dalsze poprawianie osiągów matryc CCD poprzez rozbudowę struktury przełączającej, współpracującej z właściwymi elementami światłoczułymi. W międzyczasie wprowadzono także struktury CCD HAD (z wysoko domieszkowaną warstwą P fotodiod), których główną zaletą była znacznie lepsza czułość w porównaniu do starszych generacji matryc. Rozwój technologii optycznych umożliwił także wyposażanie matryc w zestawy mikrosoczewek (fotografia 6), które pozwalały zredukować wpływ zmniejszenia struktur fotoelementów na czułość detektorów – niestety, jakiekolwiek obwody elektroniczne „wciśnięte” pomiędzy piksele wymuszają redukcję wymiarów właściwych komórek światłoczułych.

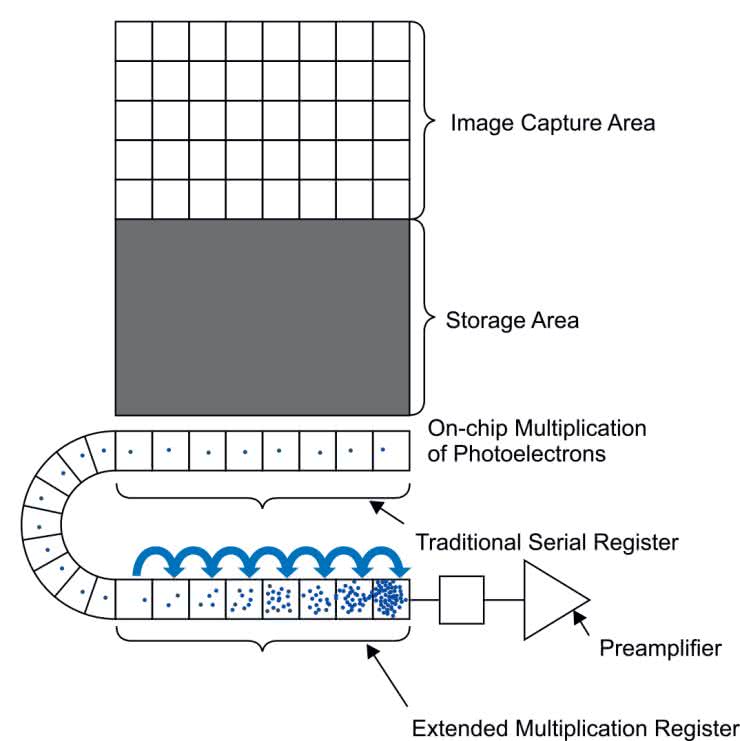

Następny przełom stanowiło zatem wdrożenie wyspecjalizowanych matryc wyposażonych w półprzewodnikowy powielacz elektronowy (EMCCD – rysunek 5) oraz przetworników typu ICCD, w których obraz jest wzmacniany jeszcze przed trafieniem na właściwą matrycę – to ostatnie rozwiązanie znalazło zastosowanie m.in. w noktowizorach i przyrządach naukowych wymagających ekstremalnie wysokiej czułości na poziomie pojedynczych fotonów.

Warto dodać, że w przypadku matryc EMCCD konieczne stało się natomiast zapewnienie chłodzenia (zwykle za pomocą ogniw termoelektrycznych), gdyż tylko w ten sposób można było drastycznie obniżyć poziom szumu, tak istotny w detekcji pojedynczych kwantów promieniowania optycznego – nie dziwią zatem charakterystyczne obudowy niektórych tego typu kamer, będące w istocie masywnymi radiatorami (fotografia 7).

Dalszy rozwój, czyli wprowadzenie matryc CMOS

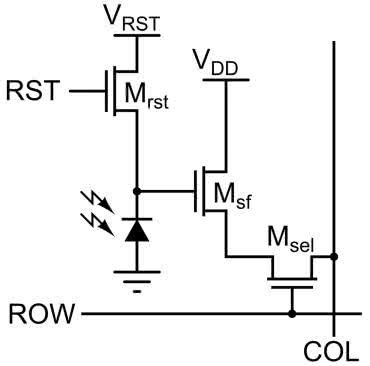

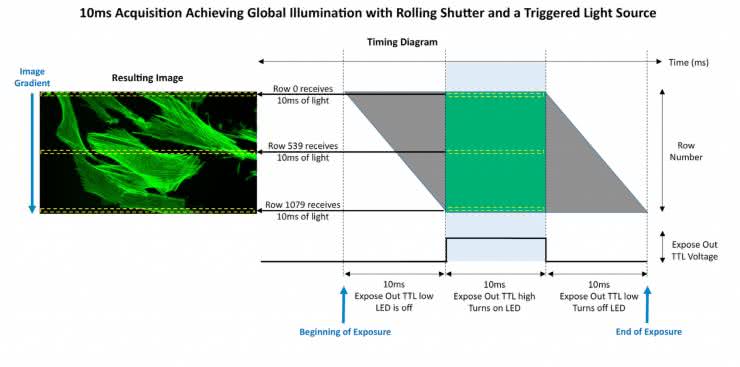

Prawdziwy przełom w obszarze cyfrowego obrazowania optycznego przyniosło opracowanie matryc CMOS, które w znakomitej większości zastosowań wyparły konwencjonalne czujniki obrazu typu CCD. Choć tutaj także mamy do czynienia z przetwarzaniem natężenia światła na ładunek elektryczny, to sposób zbierania danych z matrycy jest już diametralnie inny. Zamiast „przepychać” ładunek pomiędzy kolejnymi komórkami w poszczególnych kolumnach, czujniki obrazu CMOS korzystają z innej idei: mają bowiem – oprócz właściwych fotoelementów – także wbudowane klucze (w przypadku tzw. matryc pasywnych, tj. PPS – passive pixel sensor) lub zespoły złożone z mikroskopijnego wzmacniacza i klucza, choć w istocie zawierające zwykle także dodatkowe tranzystory (APS – active pixel sensor – rysunek 6).

Multipleksowane są zatem napięcia wyjściowe (a nie ładunki) z poszczególnych komórek, dzięki czemu szybkość pracy sensorów CMOS może być naprawdę imponująca. Jednak i tutaj nie obyło się bez problemów, które zwyczajowo rosną w trakcie rozwoju nowej technologii niczym przysłowiowe grzyby po deszczu. Okazało się bowiem, że współczynnik wypełnienia matrycy (czyli stosunek powierzchni aktywnej fotodetektorów do całkowitej powierzchni sensora obrazu) był naprawdę niewielki i wynosił zaledwie 30...50%.

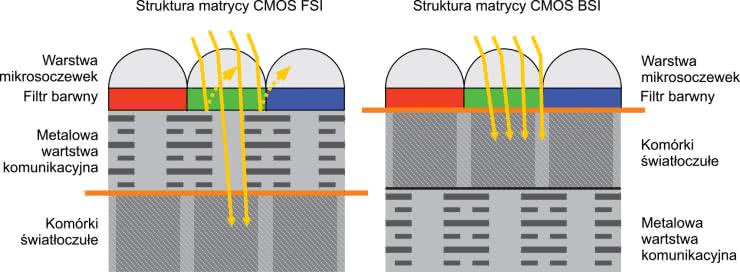

Częściowym rozwiązaniem problemu ograniczonej czułości sensorów CMOS okazała się zmiana podejścia do konstrukcji czujnika – jeżeli bowiem wystawimy na kontakt ze światłem (padającym zwykle z obiektywu, choć oczywiście nie wszystkie matryce pracują w klasycznym układzie znanym z kamer czy aparatów) stronę struktury półprzewodnikowej zawierającą komórki światłoczułe, to ilość przechwyconych fotonów jest znacznie większa, niż w przypadku konstrukcji tradycyjnej (rysunek 7).

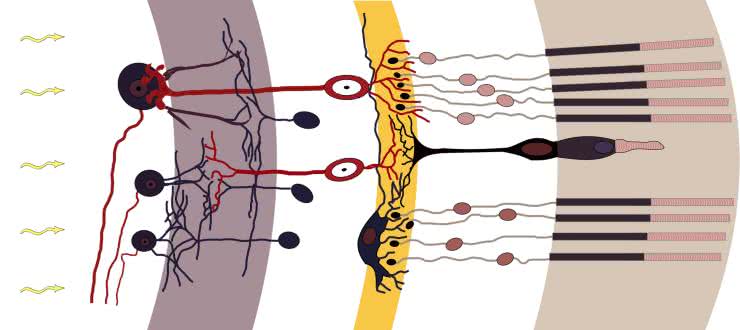

Ze względów technologicznych pierwsze matryce CMOS miały bowiem diametralnie inną budowę, w której warstwy elektronicznego „otoczenia” komórek (czyli tranzystory współpracujące z fotodiodami) oraz metalowe oprzewodowanie macierzy znajdowały się nad właściwymi fotodiodami. Na marginesie warto dodać, że o ile w świecie optoelektroniki pierwsza z opisanych konstrukcji (określana mianem BSI od ang. back-side illumination) jest znacznie lepsza od tradycyjnej FSI (ang. front-side illumination), o tyle w ludzkim oku budowa siatkówki odpowiada właśnie strukturom FSI, gdyż „lokalna” sieć neuronowa wraz z unaczynieniem znajduje się… nad warstwą komórek receptorowych (rysunek 8), co nie przeszkadza nam jednak w uzyskiwaniu doskonałego zakresu dynamiki i fantastycznej jakości widzenia w różnych warunkach oświetleniowych. Ot, kolejny przykład wyższości natury nad technologią.

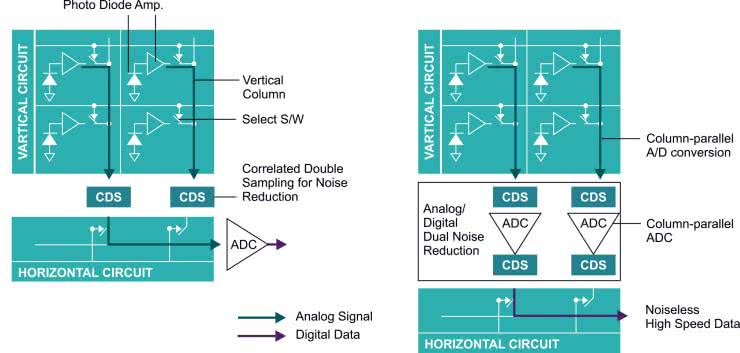

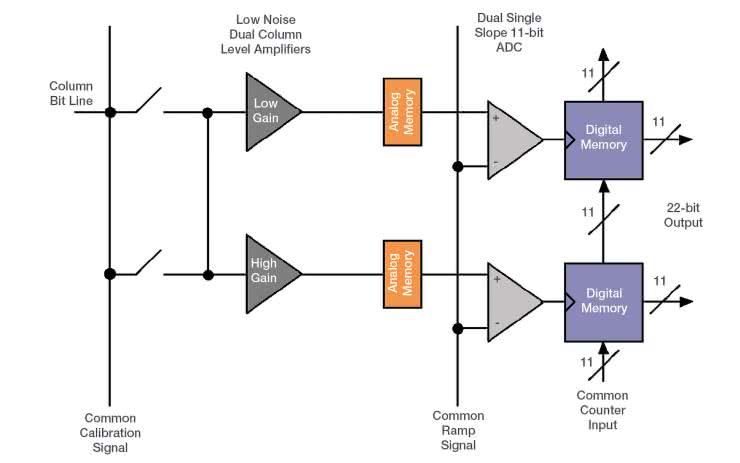

Powróćmy jednak do meritum. Wadą starszych generacji matryc CMOS był dość wysoki poziom szumów, związany m.in. z obecnością dodatkowych układów elektronicznych w torze przetwarzania i przesyłania sygnału analogowego z pikseli do wyjścia czujnika obrazu. Inżynierowie Sony opracowali szereg odmian konstrukcji APS, określanych mianem Exmor generacji 1, 2, 3, 4 i 5. Pierwsze cztery z nich opierały się zarówno na zmianie podejścia do zagadnienia odbioru napięć z poszczególnych obszarów matrycy (innowacją było wprowadzenie niezależnych, podwójnych obwodów redukcji szumu w każdej z kolumn matrycy – rysunek 9), zaś 5. generacja wiązała się dodatkowo z przejściem z topologii FSI na BSI (komponenty te zyskały nazwę handlową Exmor R).

Jakość obrazu uległa jeszcze większej poprawie dzięki wdrożeniu technologii Exmor RS, w której całość obwodów „peryferyjnych” poszczególnych komórek umieszczono pod pikselami, w ramach rozbudowanej struktury 3-warstwowej, zintegrowanej dodatkowo z pamięcią DRAM. Dzięki temu współczynnik wypełnienia matrycy przekroczył 80%, co ma niebagatelne znaczenie zwłaszcza w odniesieniu do czujników obrazu o bardzo małych rozmiarach – w przypadku matryc stosowanych w kamerach nowych modeli smartfonów rozmiary pikseli są zwykle na poziomie ułamków mikrometra, zatem gra naprawdę jest warta świeczki. Warto dodać, iż wprowadzona w 2018 roku seria 48-megapikselowych sensorów w technologii Exmor RS dzierżyła podówczas zaszczytne miano rekordu wśród czujników obrazu o najwyższej na świecie rozdzielczości w tym segmencie rynku.

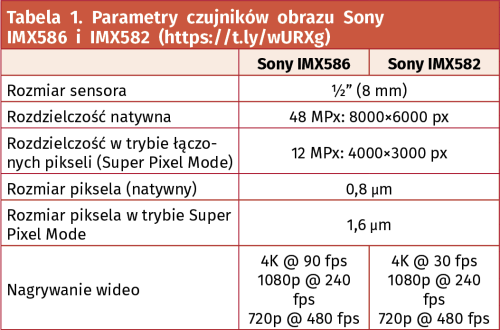

Porównanie parametrów obydwu modeli sensora (IMX582 oraz IMX586 – fotografia 8) można zobaczyć w tabeli 1.

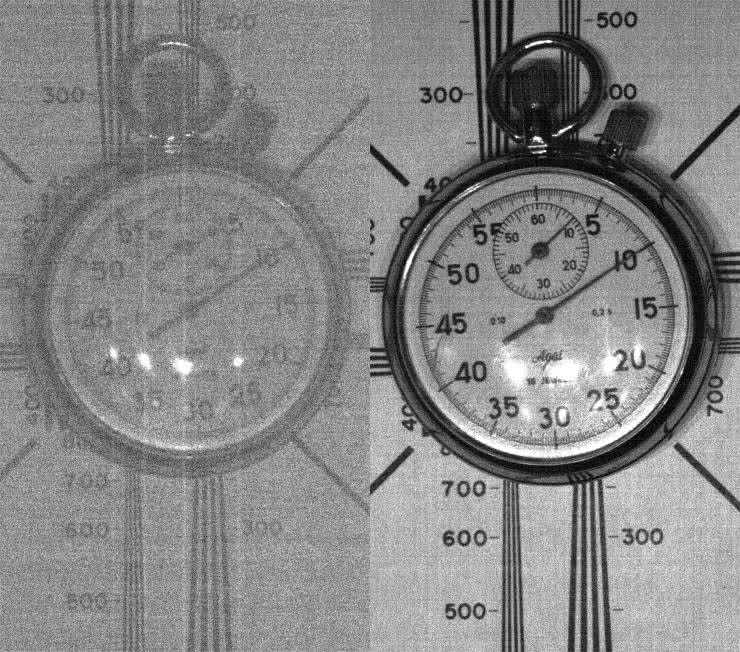

Podobnie jak CDD, także technologia CMOS doczekała się odmian dostosowanych do szczególnie wymagających aplikacji naukowych. Matryce sCMOS (ang. scientific CMOS) są swego rodzaju następcami opisanych wcześniej czujników obrazu typu EMCCD – tutaj także możliwe jest osiągnięcie ogromnej czułości (fotografia 9), niezwykle niskiego poziomu szumów RMS (równego 1...2 elektrony) i doskonałego zakresu dynamicznego, ale osiągnięcie takich parametrów mocno odbija się na cenie kamer sCMOS.

Producenci stosują w nich bowiem rozmaite, często niezwykle zaawansowane technologie, w tym:

- wbudowane chłodzenie termoelektryczne, wymagające rzecz jasna efektywnego chłodzenia gorącej strony ogniw (fotografia 10),

- bariery próżniowe zapobiegające kondensacji pary wodnej,

- macierze FPGA kompensujące najsubtelniejsze różnice produkcyjne pomiędzy poszczególnymi pikselami matrycy,

- systemy podwójnych torów analogowo-cyfrowych, umożliwiających pomiar każdego piksela za pomocą dwóch niezależnych układów o małym i dużym wzmocnieniu (dane uzyskane z obydwu ramek są następnie „składane” w jedną całość – rysunek 10),

- wysokorozdzielcze, niskoszumne przetworniki ADC (np. 16-bitowe).

Z cech zaprezentowanych do tej pory konstrukcji czujników obrazu wynikają najważniejsze różnice użytkowe pomiędzy matrycami CCD i CMOS. Zbierzmy je zatem w jednym miejscu:

- Szybkość – wąskim gardłem matryc CCD jest konieczność odczytu całej macierzy (lub przynajmniej znacznej jej części) przez pojedynczy tor ze wzmacniaczem ładunku; w przypadku matryc CMOS proces ten jest realizowany sekwencyjnie przez zestaw pracujących jednocześnie torów, co znakomicie przyspiesza akwizycję ramek obrazu.

- Szum – poziom szumu w standardowych matrycach CMOS jest nierzadko wyższy niż w czujnikach obrazu CCD, co wynika z bardziej rozbudowanej struktury oraz innego sposobu pomiaru komórek fotoczułych.

- Koszt produkcji – macierze CMOS są w ogólności tańsze niż czujniki CCD o podobnych parametrach, rzecz jasna porównanie to ma sens tylko w przypadku konstrukcji standardowych (nie zaś EMCCD czy sCMOS).

- Pobór mocy – sensory CMOS, działające w oparciu o multipleksowanie wstępnie przygotowanych sygnałów napięciowych (zamiast „przepychania” ładunków pomiędzy kolejnymi studniami potencjału), są znacznie bardziej energooszczędne niż porównywalne pod względem rozmiarów i rozdzielczości matryce CCD.

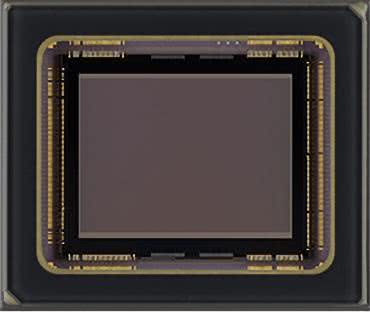

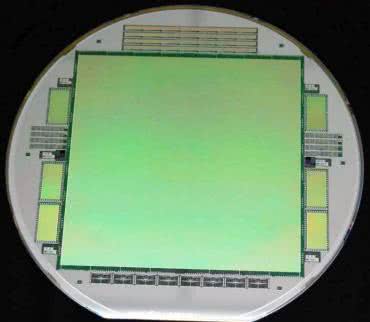

- Rozdzielczość – w technologii CMOS łatwiej jest wyprodukować sensory o bardzo wysokiej rozdzielczości, podczas gdy w przypadku CCD szereg ograniczeń technologicznych (w tym bodaj najpoważniejsze, czyli wspomniane „wąskie gardło sygnałowe”) sprawia, że użyteczna rozdzielczość ulega zwykle ograniczeniu, choć na świecie istnieją specjalistyczne wykonania CCD o rozdzielczości dochodzącej nawet do 100 megapikseli (!) – przykład można zobaczyć na fotografii 11.

- Podatność na artefakty – jak już napisaliśmy, matryce CCD są podatne na artefakty obrazowe wynikające z efektu „przelewania” ładunku z przepełnionych studni potencjału na otaczające piksele, a także z zaburzeń powstających podczas transferu ładunków (w przypadku matryc typu FT). Problemów tych pozbawione są natomiast macierze CMOS, rzecz jasna z uwagi na niezależną pracę poszczególnych pikseli (ładunki są „mierzone” lokalnie, a nie przesuwane z piksela do piksela).

- Zakres dynamiki – współczesne matryce CMOS oferują nieporównanie lepszy zakres dynamiczny niż konstrukcje sprzed kilku czy kilkunastu lat. Co więcej, mają one także wysoką tolerancję na efekt saturacji, tj. lepiej niż czujniki CCD radzą sobie z bardzo jasnymi partiami obrazu – przekroczenie maksymalnej mierzalnej jasności powoduje bowiem po prostu nasycenie toru pomiarowego (tak jak w każdym przetworniku ADC), ale nie skutkuje ono „zalewaniem” otaczających pikseli nadmiarowymi fotoelektronami.

Matryce monochromatyczne i kolorowe

Warto zwrócić uwagę na fakt, że podstawowa struktura czujnika obrazu CMOS bądź CCD nie jest w stanie rozróżnić barwy światła. Rzecz jasna, z samej natury zjawisk kwantowych zachodzących w półprzewodniku poddanemu działaniu światła wynika pewna określona dla danego materiału charakterystyka widmowa (rysunek 11), ale manifestuje się ona przez zmienną czułość na promieniowanie o różnych długościach fali. Aby rozróżnić rzeczywistą barwę obrazu (przynajmniej w czytelnej dla nas oraz dla maszyn formie), konieczne jest zatem wyposażenie matrycy w zestaw odpowiednich filtrów barwnych, które przepuszczać będą tylko określony wycinek widma, pochłaniając przy tym fale krótsze oraz dłuższe od granic pasma przepustowego.

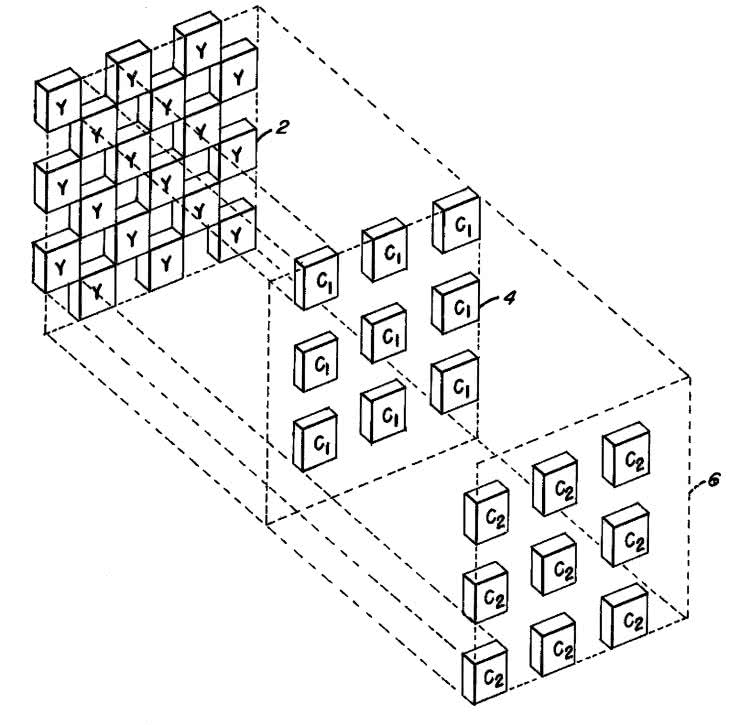

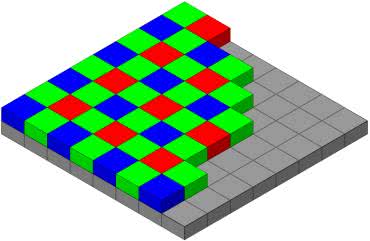

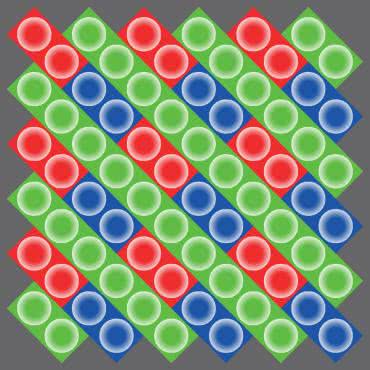

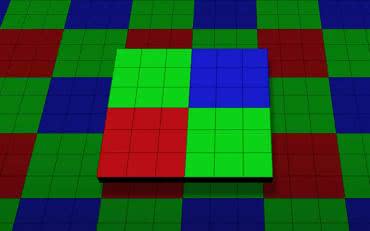

I tutaj pojawia się pierwszy problem – mamy trzy barwy podstawowe, a zatem ułożenie sąsiadujących ze sobą filtrów w postaci ortogonalnej siatki musi prowadzić do pewnych dysproporcji w „gęstości” poszczególnych komórek. W amerykańskim zgłoszeniu patentowym nr US3971065 Bryce E. Bayer uwidocznił strukturę filtru barwnego (rysunek 12), która do dziś stanowi fundament obrazowania cyfrowego w przestrzeni RGB – charakterystyczne ułożenie filtrów czerwonych, zielonych i niebieskich zakłada, że tych drugich jest w macierzy 2-krotnie więcej niż każdego z pozostałych (rysunek 13), a inspiracją do takiego, a nie innego potraktowania zagadnienia filtracji optycznej była – znów – ludzka siatkówka, szczególnie czuła właśnie na światło zielone.

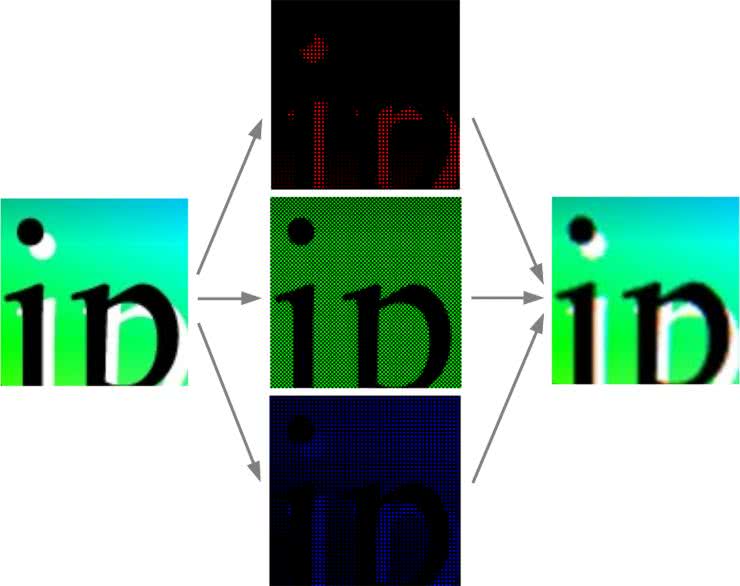

Drugi problem (podobnie jak i kolejne) wynika natomiast ze… sposobu rozwiązania pierwszego z nich. Zwróćmy bowiem uwagę na fakt, iż efektem działania filtru Bayera są trzy obrazy barwne, prezentujące jednak nieznacznie przesunięte widoki obrazowanej sceny (rysunek 14)!

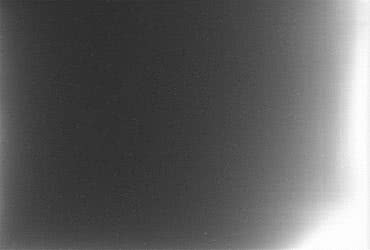

Mało tego, pikseli zielonych jest tyle, co wszystkich pozostałych razem wziętych… Aby uzyskać sensowny obraz z połączenia trzech powyższych, trzeba więc potraktować dane wyjściowe z matrycy odpowiednim algorytmem, określanym mianem demozaikowania. W najprostszej postaci może on wykonywać zwyczajną interpolację wartości dwóch brakujących kanałów barwnych dla każdego piksela – przykładowo, aby wyznaczyć wartość określonego punktu, który w rzeczywistości współpracuje z filtrem zielonym, algorytm uzupełnia dane tegoż punktu poprzez interpolację dwóch otaczających pikseli czerwonych i wykonuje tę samą czynność w odniesieniu do najbliższych punktów niebieskich. Takie podejście sprawdza się dobrze, ale… tylko przy w miarę jednolitych obszarach barwnych, gdyż w przypadku bardziej szczegółowych rejonów sceny (np. krawędzi) może prowadzić do powstawania widocznych artefaktów (fotografia 12). Z tego względu właśnie oprogramowanie do obróbki plików RAW stosuje rozmaite, znacznie bardziej zaawansowane algorytmy, których celem jest poprawa jakości obrazu – zawsze jednak to, co oglądamy, jest w pewnym sensie wytworem komputera, gdyż nie istnieje ani jeden punkt na obrazie, dla którego wszystkie trzy wartości R, G i B zostałyby rzeczywiście zmierzone jednocześnie.

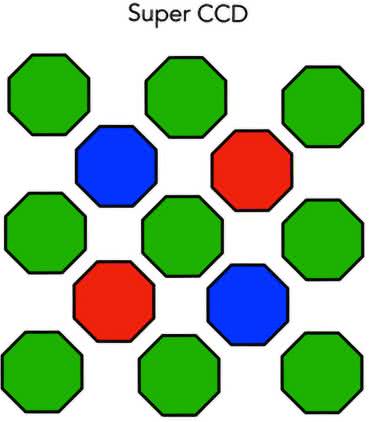

W międzyczasie powstał także szereg innych systemów ułożenia filtrów barwnych, np. Fujifilm EXR (rysunek 15), Nonacell CFA (rysunek 16) czy też Super CCD (rysunek 17).

W każdym z tych przypadków nadal istnieje rzecz jasna konieczność stosowania algorytmów demozaikujących, ale poszczególne filtry lepiej lub gorzej radzą sobie np. w kwestiach odporności na artefakty czy też pracy w słabym świetle. Dotyczy to zwłaszcza układu typu Nonacell, w którym sąsiadujące piksele czułe na tę samą barwę mogą być „sklejane” w celu uzyskania większego, a – co za tym idzie – także bardziej czułego na słabe światło punktu obrazu, co ma duże znaczenie w zdjęciach nocnych, wykonywanych za pomocą aparatów o ogromnej rozdzielczości (np. 108 Mpx).

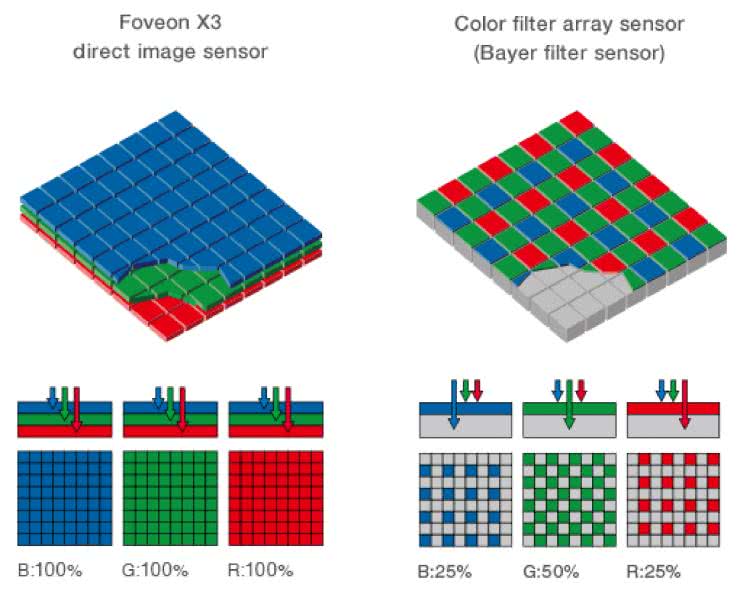

Warto także dodać, że powstała odmiana czujnika obrazu, w której wszystkie trzy fotodiody „kanałowe” są ustawione jedna na drugiej w sposób wielowarstwowy – matryca Foveon X3 (rysunek 18) całkowicie eliminuje potrzebę stosowania demozaikowania, zmniejsza także znacząco liczbę artefaktów na krawędziach obrazu. I znów rozwiązanie jednego problemu generuje nowe trudności: kolejne warstwy nie mogą bazować na klasycznych filtrach (w przybliżeniu) monochromatycznych, gdyby bowiem pierwszy, niebieski filtr zaabsorbował fale o długościach wszystkich innych niż zakres niebieski, to… do czujników leżących poniżej nie dotarłoby już żadne promieniowanie spoza tegoż przedziału. Inżynierowie z firmy Foveon podeszli do tematu inaczej, niejako odwrotnie – filtry optyczne mają bowiem charakterystyki pasmowo-zaporowe (tj. absorbują tylko światło – kolejno: niebieskie, zielone i czerwone), a zatem informacje uzyskane z leżących coraz głębiej fotodiod muszą być traktowane nie jako pozyskane subtraktywnie, ale addytywnie. Algorytm musi więc przeliczyć sygnały z trzech kanałów na – odpowiednią do przyjętej powszechnie w świecie fotografii cyfrowej – przestrzeń barwną RGB. Czujniki obrazu typu Foveon X3 nie przyjęły się jednak na rynku w sposób mogący jakkolwiek zagrozić klasycznym matrycom opartym na filtrach o topologii Bayera – oprócz kilku modeli lustrzanek Sigmy oraz aparatów kompaktowych produkcji Sigmy i Polaroida, próżno szukać w rynkowej ofercie konstrukcji bazujących na tym (bądź co bądź innowacyjnym) sensorze obrazu. I choć szerokim echem odbiły się w świecie fotografów plany premiery nowej konstrukcji Foveona na początku obecnej dekady, to jak na razie projekt wciąż pozostaje w domenie szumnych zapowiedzi, a nie komercyjnej oferty któregokolwiek z producentów aparatów cyfrowych.

Rodzaj migawki

Do tej pory omówiliśmy zagadnienia związane z szeregiem najważniejszych parametrów przetworników obrazu, zabrakło jednak jednej, równie istotnej cechy konstrukcyjnej, która w dużej mierze warunkuje parametry użytkowe matryc w aplikacjach wymagających krótkich czasów ekspozycji. Mowa o migawce elektronicznej.

W opisach technicznych przetworników obrazu znajdziemy dwa rodzaje migawek.

- Migawka typu global shutter pozwala na zarejestrowanie obrazu ze wszystkich pikseli jednocześnie. Dzięki temu uzyskujemy cyfrową reprezentację obrazu sceny, która odpowiada faktycznemu jej wyglądowi w pewnym skończonym przedziale czasowym – rzecz jasna, im krótszy czas ekspozycji, tym mniejsza podatność na rozmazywanie konturów, ale także mniejsza liczba fotonów, które zostaną zarejestrowane przez poszczególne piksele.

- Migawka typu rolling shutter działa na drodze sukcesywnego przemiatania kolejnych linii przetwornika w czasie ekspozycji. Oznacza to, że zanim układ odczytowy „dojdzie” do końca obrazu, to szybkozmienna scena może już zdążyć ulec zmianie (np. przesunięciu).

Nietrudno domyślić się, że w przypadku obrazów statycznych lub w czasie rejestracji zjawisk o małej dynamice typ migawki nie ma praktycznie żadnego znaczenia dla obrazu wynikowego. Jeżeli jednak fotografujemy lub nagrywamy zjawiska zmieniające się bardzo szybko, to zastosowanie przetwornika z migawką typu rolling shutter doprowadzi niechybnie do powstania artefaktów. Podręcznikowy przykład można zobaczyć na fotografii 13 – wirujące, sześciołopatowe śmigło samolotu zostało tu uchwycone za pomocą kamery smartfona wyposażonej w przetwornik z migawką rolling shutter. Jak widać, obraz został bardzo silnie zniekształcony, co wynika właśnie z rejestracji poszczególnych linii z pewnym przesunięciem czasowym względem momentu rozpoczęcia ekspozycji. Rzecz jasna, efektu tego nie należy mylić z innym artefaktem, określanym mianem wagon-wheel effect i widocznym np. podczas filmowania jadącego z odpowiednią prędkością samochodu – pozorny obrót kół pojazdu w kierunku przeciwnym do rzeczywistego wynika bowiem z aliasingu.

Opisane powyżej artefakty nie wyczerpują jednak tematu wpływu rodzaju migawki na warunki rejestracji obrazu. Wyobraźmy sobie, że mamy do czynienia z systemem obrazowania mikroskopowego, za pomocą którego obserwujemy np. ruchy drobnoustrojów w polu widzenia mikroskopu. Jeżeli ruchy są dostatecznie szybkie w stosunku do częstotliwości następujących po sobie ekspozycji (tzw. framerate), to może okazać się, że – zanim układ przemiatania matrycy zdąży dojść do ostatniego wiersza pikseli – na obrazie pojawi się organizm, którego wcześniej w owym polu nie było lub ten, który był widoczny w poprzedniej ramce, zniknie z obszaru obrazowania. Jeżeli kamera współpracuje z systemem analizy obrazu, realizującym funkcje zliczania obiektów lub ich śledzenia, pomiaru odległości pomiędzy nimi itp., to sposób realizacji migawki będzie w dużej mierze wpływał na błąd metody.

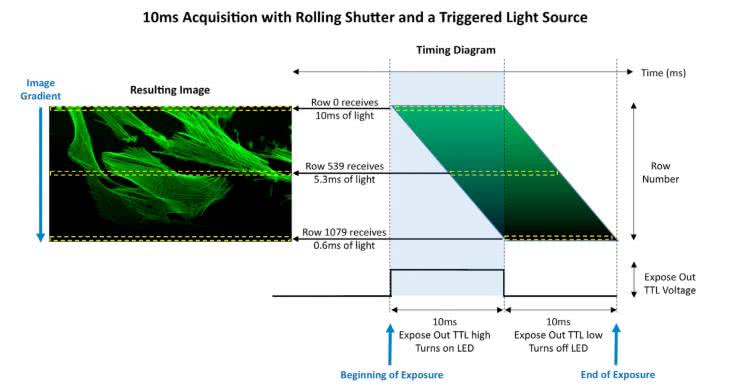

W opracowaniach dotyczących klasycznych zastosowań przetworników obrazu w fotografii cyfrowej rzadko natomiast można znaleźć informacje o powiązaniu migawki z synchronicznym oświetlaczem. Tymczasem także tutaj rodzaj migawki może mieć kolosalne znaczenie dla uzyskiwanych obrazów. Spójrzmy na rysunek 19, na którym zaprezentowano następującą sytuację: preparat mikroskopowy zostaje oświetlony 10-milisekundowym impulsem światła z diody LED. Jednocześnie z początkiem impulsu startuje także ekspozycja, która trwa jednak przez 20 milisekund. Przy takiej konfiguracji układu obrazowania pierwszy wiersz matrycy zostanie naświetlony najsilniej, zaś wszystkie kolejne otrzymają coraz mniej światła. Z punktu widzenia następnych wierszy matrycy będzie to porównywalne z „wirtualnym” zmniejszaniem współczynnika wypełnienia sygnału sterującego diodą – w skrajnym przypadku ostatni wiersz może nawet w ogóle nie zostać oświetlony w czasie, gdy przyjdzie kolej na jego ekspozycję. Efekt? Obraz będzie stopniowo ściemniał się w osi pionowej (Y) – jak gdyby na obiektyw został nałożony silny filtr połówkowy.

Co zrobić, aby uniknąć powstania takiego gradientu? Metoda jest bardzo prosta – wystarczy tak wydłużyć ekspozycję (i/lub skrócić czas oświetlenia sceny), by na okno czasowe z włączonym oświetlaczem przypadła częściowa ekspozycja wszystkich wierszy matrycy. Takie rozwiązanie, zaprezentowane na rysunku 20, nosi miano pseudo-global shutter – z jednej strony, zmiana sposobu sterowania oświetlaczem pozwala wykonać prawidłową ekspozycję całej matrycy (tak jak w przypadku klasycznych przetworników obrazu z globalną migawką), z drugiej jednak nie chroni to w żaden sposób przed artefaktami wynikającymi z dynamiki samej sceny – wszystkie opisane wcześniej problemy, związane np. z ruchem obiektu(-ów) w polu obrazowania, wystąpią tutaj z takim samym natężeniem.

Warto jeszcze dodać, że – o ile zdecydowana większość matryc CCD z natury rzeczy pracuje w trybie migawki globalnej – o tyle w przypadku czujników obrazu CMOS konstrukcja migawki może być narzucona przez odpowiedni projekt układu sterowania oraz, rzecz jasna, samych pikseli. Jak nietrudno zauważyć, klasyczna struktura matryc typu PPS oraz znacznej części czujników APS narzuca pracę w trybie rolling shutter. Jeżeli jednak do każdego piksela „dorzucimy” dodatkowy tranzystor kluczujący, to możliwe jest – poprzez włączenie wszystkich tych tranzystorów jednocześnie – sterowanie zezwoleniem na ekspozycję w całej matrycy. Stąd też bardziej rozbudowane czujniki obrazu mogą pracować w trybie global shutter, a nawet… oferują możliwość wyboru rodzaju migawki. Wiąże się to rzecz jasna z rozbudową układu, dlatego niektóre matryce CMOS mają konstrukcję 5T czy 6T (czyli każdy piksel ma 5 lub 6 tranzystorów) – przykład można zobaczyć na rysunku 21. Na marginesie warto dodać, że w niektórych publikacjach naukowych można znaleźć nawet konstrukcje bazujące na 8 tranzystorach/piksel.

Rozdzielczość i nie tylko – parametry czujników obrazu w praktyce

We wcześniejszej części artykułu wielokrotnie wspomnieliśmy już o rozdzielczości sensorów obrazu, mierzonej najczęściej w megapikselach, czyli milionach pikseli. Warto przy tym zauważyć, że parametr ten, będący przybliżonym wynikiem mnożenia liczby pikseli w poziomie i pionie, jest w istocie sumą wszystkich pikseli z filtrami czerwonymi, zielonymi i niebieskimi – odzwierciedla zatem także docelową liczbę punktów w obrazie będącym wynikiem demozaikowania. Pewne problemy stwarzał w tym zakresie opisany wcześniej czujnik Foveon X3, którego rozdzielczość przestrzenna była wprawdzie dość przeciętna, ale „dla porządku” (a raczej – w celu dorównania konkurencyjnym czujnikom obrazu z filtrami Bayera) producent podawał liczbę pikseli przemnożoną przez trzy (względem wyniku mnożenia „pikselowej” szerokości i wysokości czujnika).

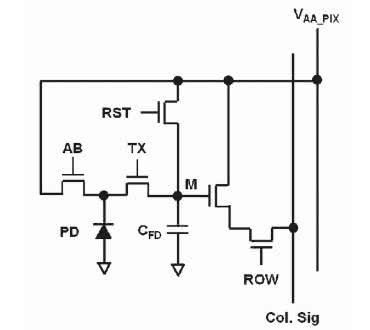

Rozdzielczość wraz z fizycznymi rozmiarami matrycy determinują natomiast wymiary poszczególnych pikseli – im mniejszy sensor, tym gęściej upakowane punkty światłoczułe, ale zarazem także wyższy poziom szumów. Nietrudno się bowiem domyślić, jak kolosalne znaczenie dla szumów podczas ekspozycji w słabym świetle ma rozmiar piksela – im jest on mniejszy, tym mniej fotonów może „wyłapać”, a co za tym idzie – udział każdego fotoelektronu w sygnale wyjściowym ma w takim wypadku dużo większy wpływ na amplitudę sygnału.

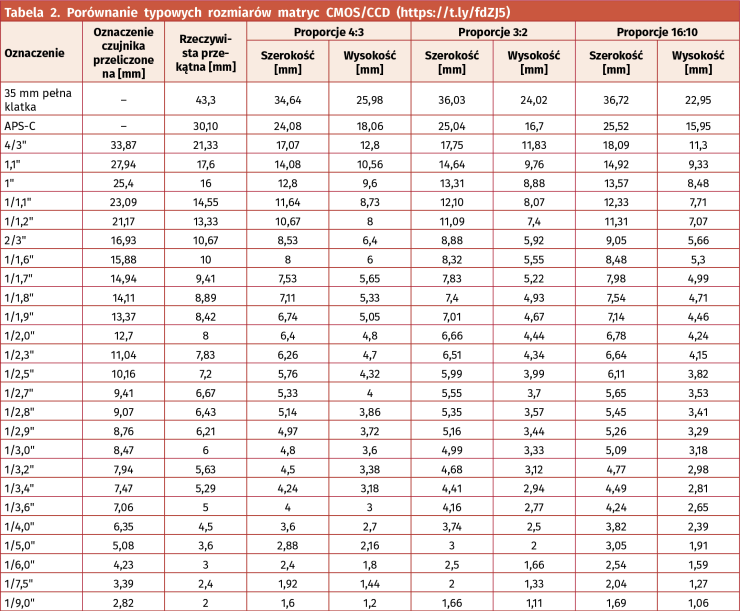

Na rysunku 22 można zobaczyć porównanie rozmiarów różnych czujników obrazu, stosowanych głównie w fotografii cyfrowej, zaś w tabeli 2 zebrano przykładowe wymiary i oznaczenia matryc spotykanych na rynku. Warto zauważyć, że rozmiar matrycy (podany w calach) po przeliczeniu na milimetry jest wyraźnie większy niż rzeczywista długość przekątnej wyliczona na podstawie szerokości i wysokości sensora. Nie jest to jednak błąd, a… spuścizna po erze lamp analizujących, których wymiary były podawane „całościowo”, tj. z uwzględnieniem obszaru otaczającego aktywny rejon lampy.

Wydajność kwantowa a widmo rejestrowanych fal elektromagnetycznych

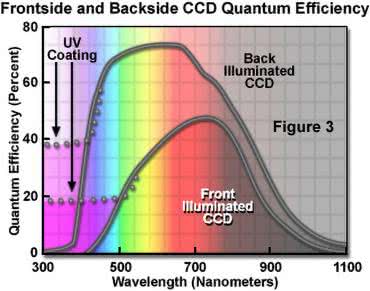

Kolejnym istotnym parametrem jest wydajność kwantowa (QE, ang. quantum efficiency), określana w procentach i wyrażająca efektywność konwersji światła na sygnał elektryczny. QE to nic innego, jak stosunek liczby „wyprodukowanych” fotoelektronów do liczby fotonów, które doprowadziły do ich wybicia. Idealna wydajność kwantowa wynosiłaby więc 100%, ale w rzeczywistości najlepsze przetworniki obrazu są w stanie osiągnąć maksymalny wskaźnik QE około 95%. Zwiększaniu wydajności kwantowej w oczywisty sposób sprzyja konstrukcja BSI.

W tym miejscu warto zwrócić uwagę na fakt, że oprócz klasycznych czujników obrazu (przeznaczonych do pracy w świetle widzialnym) na rynku dostępnych jest także wiele modeli sensorów oraz gotowych kamer, które dostosowane zostały do rejestracji scen w innych przedziałach widma elektromagnetycznego – zwykle jednak przy znacznie niższej wydajności kwantowej, na poziomie 50...60% (maks.). I nie chodzi tutaj tylko o popularne kamery zdolne do pracy w podczerwieni bliskiej (tak działają przecież niemal wszystkie współczesne kamery CCTV wyposażone w oświetlacze IR).

W ofertach niektórych producentów można bowiem znaleźć także modele oparte na półprzewodnikach innych niż krzem – np. InGaAs – i dzięki temu czułe na pasmo w zakresie od 900 nm do 1700 nm, od 1100 nm do 1900 nm czy też od 1200 do 2200 nm. Takie właśnie czujniki obrazu produkuje m.in. niemiecka firma Andanta (fotografia 14).

W sprzedaży dostępne są ponadto sensory CMOS do pracy w ultrafiolecie (np. IMX487 marki Sony – fotografia 15) czy nawet… matryce CCD do bezpośredniej akwizycji promieniowania rentgenowskiego (fotografia 16). Bezpośredniej – czyli z pominięciem konwencjonalnej techniki korzystającej ze scyntylatora przetwarzającego promieniowanie X na fotony światła widzialnego, rejestrowane następnie przez konwencjonalny czujnik obrazu.

Szumy w czujnikach obrazu

O metodach obniżania szumu pisaliśmy przy okazji omawiania czujników obrazu typu EMCCD i sCMOS. Dodajmy więc zatem, że na zwiększenie szumu rejestrowanego na obrazie wpływa szereg czynników, związanych zarówno z konstrukcją sensora, jak i warunkami jego pracy, w tym:

- Ustawienie czułości – im wyższa, tym silniejszy udział szumu w obrazie wyjściowym; o wpływie czułości (określanej w standardzie ISO) na jakość obrazu wiedzą doskonale osoby zajmujące się fotografią.

- Wielkość piksela – jej wpływ na poziom szumów opisaliśmy już wcześniej.

- Temperatura – wzrost temperatury sensora obrazu (a także współpracującej elektroniki) w oczywisty sposób podnosi całkowity poziom szumu i to w sposób niezależny od natężenia rejestrowanego światła – wynika to bowiem z prądu ciemnego fotoelementów oraz losowych zaburzeń występujących w pozostałej części struktury półprzewodnika. Warto jednak zwrócić uwagę na fakt, że znaczenie zyskuje tutaj nawet zjawisko samonagrzewania się kamery i to – co gorsza – nierzadko w sposób nierównomierny (fotografia 17).

- Wpływ układów odczytowych – szum powstaje nie tylko w samej matrycy, ale także w układach przetwarzania sygnałów analogowych (wzmacniacze, multipleksery, etc.) oraz w przetwornikach ADC. Z tego względu wysokiej klasy kamery, wyposażone w niskoszumne obwody odczytowe, są znacznie droższe, niż wynikałoby tylko z ceny samego czujnika obrazu.

- Niedoskonałości matrycy – oprócz szumu rozłożonego (przy zachowaniu jednakowej temperatury całego sensora) w sposób równomierny na powierzchni matrycy, w obrazach rejestrowanych przy ekstremalnie niskim natężeniu światła można także zaobserwować szumy określane mianem fixed pattern noise, wynikające z nieidealnej konstrukcji struktury półprzewodnikowej sensora. Widać to szczególnie wyraźnie w czujnikach niższej jakości, a także w sensorach o konstrukcji dzielonej (fotografia 18).

Subminiaturowe sensory obrazu

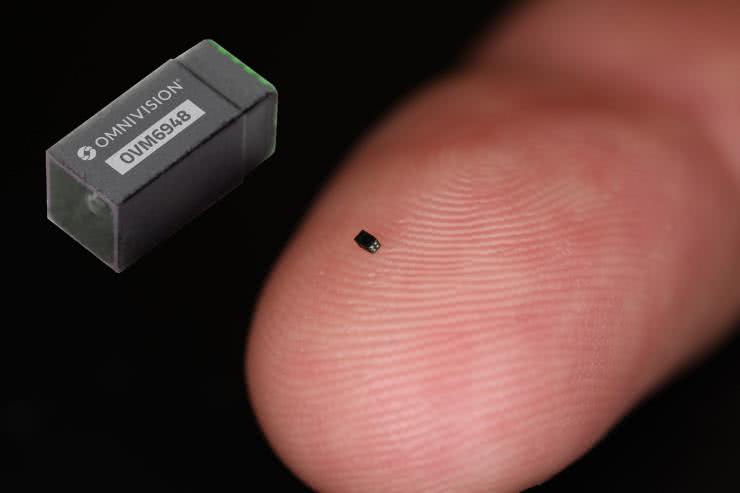

Podczas omawiania tematyki czujników obrazu nie sposób pominąć szczytowych osiągnięć w zakresie miniaturyzacji tych komponentów. Zaszczytne miano lidera należy się znanej firmie OMNIVISION, która w 2019 roku uzyskała wpis do Księgi Rekordów Guinnessa za wyprodukowanie najmniejszego na świecie, dostępnego komercyjnie czujnika obrazu. Model OVM6948 ma wprawdzie stosunkowo niewielką (jak na dzisiejsze standardy) rozdzielczość matrycy wynoszącą 40 kpx (200×200 px, akwizycja 30 fps), ale za to może poszczycić się fenomenalnie kompaktowymi rozmiarami: 0,65×0,65×1,158 mm (fotografia 19). Dzięki tak dalece posuniętej miniaturyzacji ta mikroskopijna kamera (mówimy tutaj bowiem o kompletnym module z wbudowaną optyką o kącie widzenia 120° i głębi ostrości 3...30 mm!) może być umieszczona w cewniku o średnicy na poziomie 1,0 mm, co daje ogromny potencjał w endoskopowych procedurach małoinwazyjnych. Tak doskonałe osiągi wymagały rzecz jasna optymalizacji każdego aspektu technologicznego – w kamerze zastosowano dwuliniowy interfejs danych (linia synchronizacji oraz analogowe wyjście obrazu), dzięki czemu obudowa modułu ma zaledwie… cztery piny.

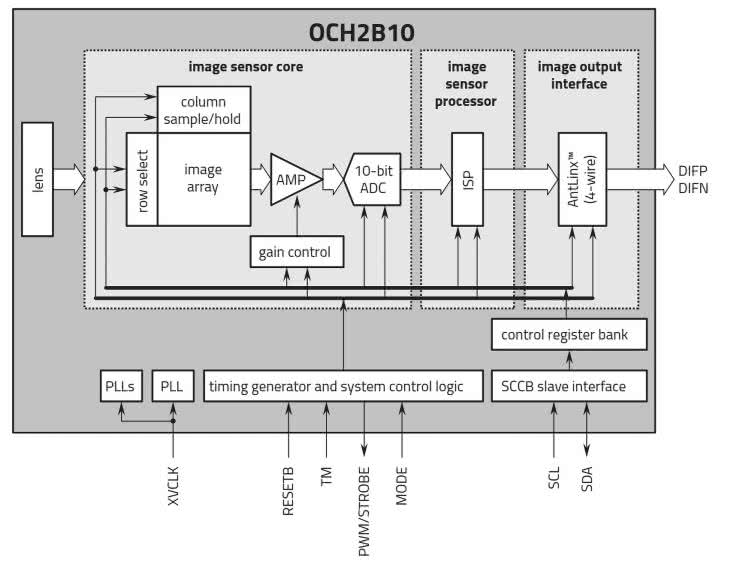

Ten sam producent wprowadził także na rynek inne moduły kamer, przeznaczone – podobnie jak OVM6948 – głównie do aplikacji medycznych. Obszerna linia produktowa CameraCubeChip obejmuje kilkanaście subminiaturowych modeli kamer, z których najlepsze osiągi w zakresie rozdzielczości oferuje OCH2B10 (fotografia 20).

Jej 2-megapikselowa matryca (1500×1500 px) może rejestrować obraz z szybkością 60 fps i ma wymiary zaledwie 2,565×2,565×3,634 mm. Moduł został opracowany głównie z myślą o niewielkich endoskopach jednorazowych. W tym przypadku mamy już do czynienia z konstrukcją w pełni cyfrową, wyposażoną w 1-bitowy przetwornik ADC, procesor obrazu i własnościowy interfejs komunikacyjny AntLinx (rysunek 23).

Czujniki przestrzeni vs sensory obrazu

Typowe zastosowanie standardowych kamer – nawet najlepszej jakości – nie umożliwia wiarygodnej oceny odległości poszczególnych obiektów (głębi sceny). Istnieje wprawdzie szereg technik pozwalających „obejść” ograniczenia układów obrazowania bazujących na klasycznych matrycach CMOS i CCD (analiza z użyciem światła strukturalnego, stereowizja czy też mapowanie trójwymiarowe na drodze stackingu zdjęć wykonywanych z niewielką głębią ostrości), ale każda z nich ma, oprócz oczywistych zalet, także szereg bardzo istotnych wad i ograniczeń.

Rozwój optoelektroniki i szybkich układów przetwarzania sygnałów doprowadził do powstania nowej kategorii czujników obrazu, które należy określić raczej mianem czujników przestrzeni. Z klasycznymi matrycami nie mają one jednak zbyt wiele wspólnego – praktycznie jedyną cechą zbliżającą czujniki obrazowe 3D do zwykłych sensorów obrazu jest konstrukcja oparta na ortogonalnej siatce pikseli. Wszystko inne – rodzaj fotoelementów, sposób ich podłączenia oraz (a raczej przede wszystkim) metoda przetwarzania uzyskiwanych z matrycy sygnałów – jest biegunowo odległe od tego, co opisaliśmy do tej pory.

Czujniki dToF – budowa i zasada działania

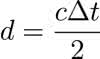

Czujniki przestrzeni bazują na optycznej realizacji metody, którą w ogólności zwykło się określać mianem time-of-flight (ToF), czyli na pomiarze czasu przelotu wiązki światła od emitera (najczęściej lasera) do obiektu i z powrotem, po odbiciu, do matrycy fotoelementów. Zastosowanie „własnego” oświetlacza, precyzyjnie zsynchronizowanego z macierzą odbiorczą, jest warunkiem koniecznym do realizacji pomiaru ToF z oczywistego względu: układ pomiarowy musi znać dokładny moment, w którym wiązka światła wyrusza w stronę obrazowanej sceny, by móc obliczyć różnicę czasu, a następnie – na jej podstawie – odległość poszczególnych punktów od kamery.

Szeroko rozpowszechnionym rodzajem oświetlacza w tym obszarze rynku są podczerwone lasery z pionową wnęką rezonansową (VCSEL od ang. Vertical Cavity Surface Emitting Laser), które swoją niebywałą popularność zawdzięczają przede wszystkim niedrogim, kompaktowym czujnikom odległości. Sensory tego typu bazują na tzw. bezpośredniej odmianie metody ToF, określanej jako dToF (ang. direct Time-of-Flight). U podstaw tej techniki leży dokładnie to samo równanie, które stosowane jest także w przypadku impulsowych radarów mikrofalowych, sonarów czy prostych dalmierzy ultradźwiękowych (1):

(1),

gdzie: d – odległość od obiektu do czujnika [m], c – prędkość fali w ośrodku, czyli w tym przypadku prędkość światła [m/s], Δt – różnica czasu pomiędzy rozpoczęciem nadawania impulsu światła laserowego a rozpoczęciem odbioru fali odbitej od przeszkody [s].

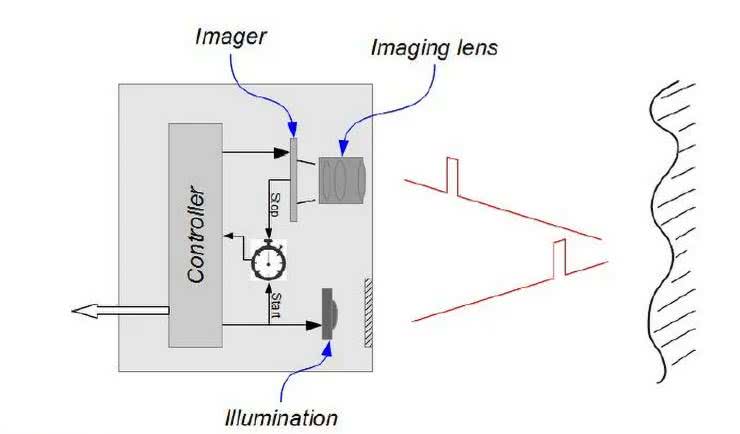

Układy sterujące czujników dToF (rysunek 24) wysyłają ultrakrótkie impulsy światła laserowego o czasie trwania na poziomie 0,2...5 ns. Ze względu na niską moc nadawania, krótki czas impulsu oraz nieuniknione straty (związane z rozproszeniem oraz absorpcją fotonów przez przeszkodę lub cząstki ośrodka), ilość odebranych fotonów jest znikoma. Z tego względu w roli fotoelementów stosowane są fotodiody lawinowe (APD) lub detektory jednofotonowe typu SPAD, których dodatkową zaletą jest bardzo krótki czas reakcji – konieczny, by móc zarejestrować tak wąskie impulsy światła laserowego.

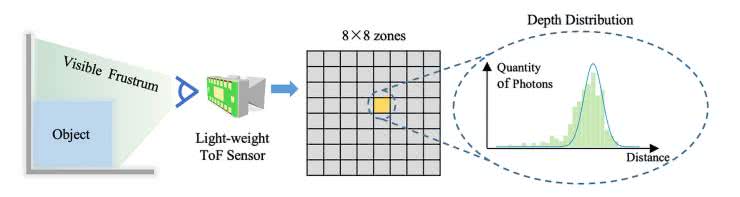

Redukcja szumu i wpływu zakłóceń zewnętrznych na wynik pomiaru jest realizowana poprzez wielokrotną akwizycję próbek i obróbkę ich na zasadzie analizy statystycznej – dostępne na rynku czujniki są wyposażone we wbudowane mikrokontrolery, których fabrycznie wgrane oprogramowanie przetwarza odebrane dane na drodze budowy histogramu i analizy piku jego obwiedni (rysunek 25).

Metoda dToF oferuje doskonałą dokładność i relatywnie szeroki zakres pomiarowy, ale ma niestety sporą wadę – w praktyce nadaje się do zastosowania jedynie w prostszych czujnikach z pojedynczym polem widzenia (FOV) lub w sensorach matrycowych o relatywnie niewielkiej rozdzielczości. Jednak i tutaj dokonuje się znaczący postęp – podczas gdy do niedawna szczytowym osiągnięciem w tym zakresie były sensory wielosegmentowe o rozdzielczości na poziomie kilkudziesięciu pikseli (np. 4×8 czy 8×8 – patrz fotografia 21), to najnowszy sensor, który niebawem ma trafić do sprzedaży – model VL53L9CA (fotografia 22) – oferuje już naprawdę przyzwoitą rozdzielczość rzędu 54×42 px i może dokonywać skanowania głębi sceny w zakresie od 5 cm do nawet 10 metrów z szybkością odświeżania do 60 fps.

W chwili pisania niniejszego artykułu nie są jednak dostępne szczegółowe dane dotyczące np. dokładności w poszczególnych podzakresach strefy detekcji czy też w różnych warunkach oświetleniowych (czujniki dToF niezbyt dobrze radzą sobie w silniejszym świetle słonecznym, czy nawet oświetleniu sztucznym). Można jednak być pewnym, że premiera układu VL53L9CA sporo „namiesza” na rynku czujników ToF, choć w tym segmencie pozycja firmy STMicroelectronics i tak jest już bardzo silna.

Kamery iToF – konstrukcja i metoda pomiarowa

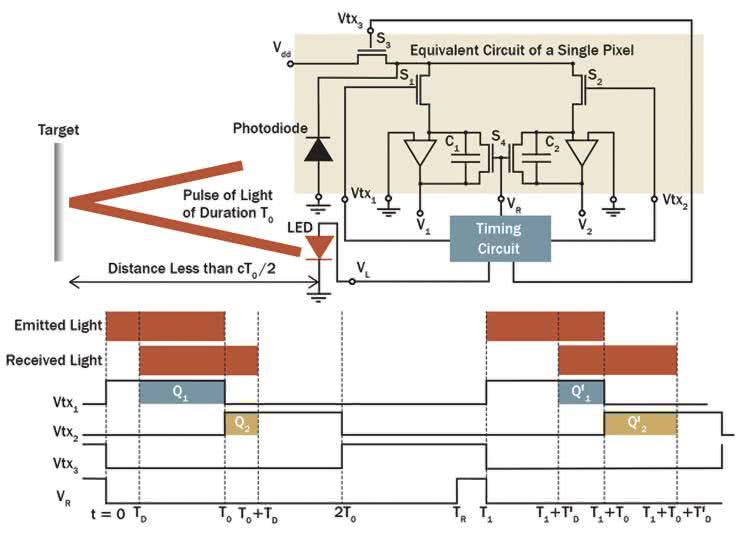

Pośrednia metoda ToF (iToF, ang. indirect ToF) bazuje już nie na krótkich impulsach światła laserowego, ale na oświetleniu obiektu falą ciągłą, zmodulowaną amplitudowo sygnałem o relatywnie wysokiej częstotliwości (zwykle w zakresie 20...100 MHz). Miarą odległości jest tutaj różnica fazy pomiędzy sygnałem nadanym a falą odebraną przez czuły fotoelement – na podstawie znajomości przesunięcia fazowego oraz prędkości światła wyliczana jest następnie odległość dzieląca obiekt (przeszkodę) od sensora. Metoda iToF pozwala znacząco zwiększyć rozdzielczość przestrzenną detektora i to do poziomu porównywalnego z przeciętnymi czujnikami obrazu typu CMOS bądź CCD.

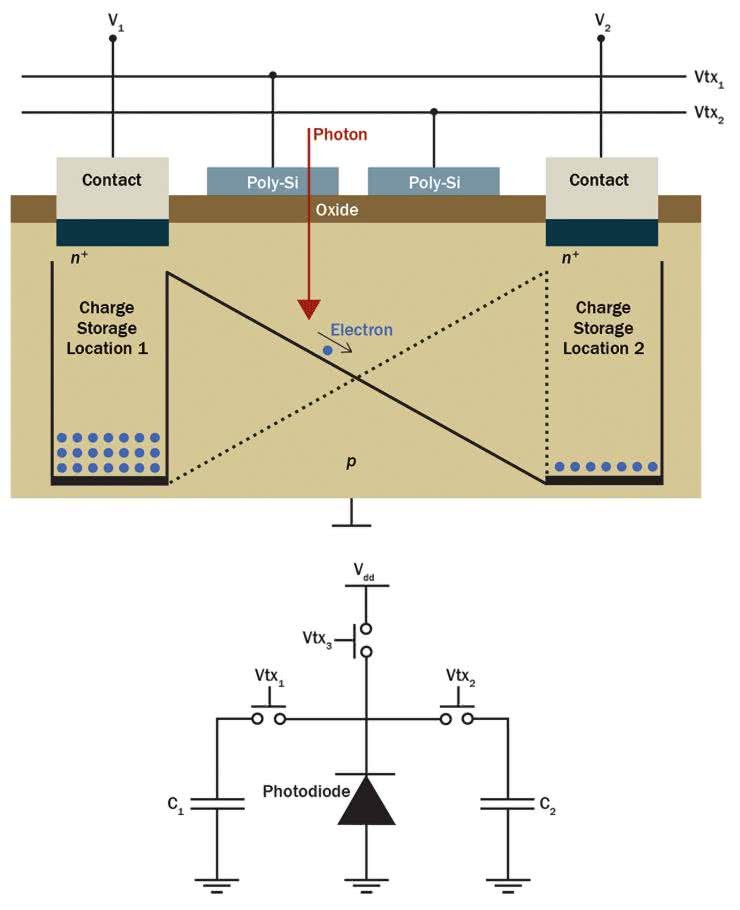

Co ciekawe, w konstrukcjach kamer iToF można znaleźć wyspecjalizowany rodzaj detektorów, określany mianem PMD (ang. Photonic Mixer Device, czyli tzw. fotoniczny mieszacz – patrz rysunek 26).

Detekcja fazy odebranej wiązki światła odbywa się tutaj na poziomie poszczególnych pikseli, tj. bez udziału zewnętrznych układów analogowych (mieszaczy, demodulatorów, etc.). Zasadę działania PMD schematycznie zilustrowano na rysunku 27. Foton padający na powierzchnię struktury krzemowej detektora powoduje wygenerowanie ładunku elektrycznego, który – w zależności od podanego z zewnątrz sygnału sterującego zsynchronizowanego z oświetlaczem – kierowany jest do jednego z dwóch kondensatorów. Stosunek napięć V1 i V2, będących efektem ładowania poszczególnych kondensatorów, zmienia się w zależności od przesunięcia fazowego pomiędzy sygnałem nadanym a odebranym przez dany piksel.

Najważniejsza część procesu demodulacji jest więc realizowana bezpośrednio na poziomie struktury półprzewodnikowej matrycy detektorów, zatem do jej pracy konieczny okazuje się w zasadzie tylko zewnętrzny układ synchronizacji oraz przetworniki ADC, odpowiedzialne za próbkowanie napięć z poszczególnych kondensatorów.

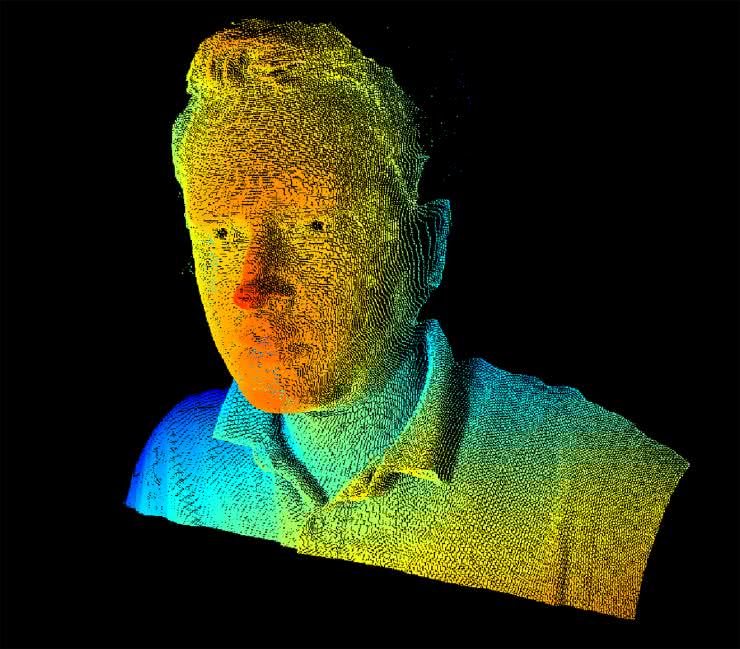

Technologia obrazowania głębi na bazie metody iToF jest w zasadzie bardzo młoda, ale na tyle obiecująca, że szereg producentów już teraz wdrożył dostępne „z półki” matryce iToF, które z wyglądu nie różnią się zasadniczo od klasycznych czujników obrazu CMOS bądź CCD. Firma STMicroelectronics już dwa lata temu udostępniała matrycę VD55H1 (fotografia 23) o naprawdę imponującej rozdzielczości 0,54 Mpx (672×804 px) i szybkości odświeżania do 120 fps. Tak wysoka rozdzielczość przestrzenna pozwala generować niezwykle szczegółowe mapy głębi sceny (rysunek 28) w sposób nieporównanie prostszy niż przy użyciu konwencjonalnych technik (np. skanowania laserowego).

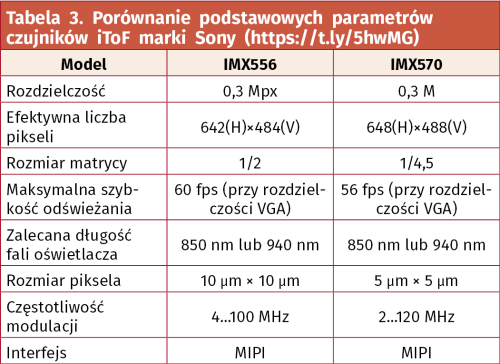

Konkurencją dla rozwiązania ST jest m.in. seria czujników przestrzeni IMX556 i IMX570 marki Sony (fotografia 24). Obydwa czujniki różnią się praktycznie wszystkimi parametrami (z wyjątkiem długości fali oświetlacza oraz rodzaju interfejsu komunikacyjnego) – porównanie najważniejszych cech technicznych obydwu sensorów można znaleźć w tabeli 3.

Podsumowanie

Pozyskiwanie obrazu jest nieodłącznym elementem naszej codzienności. Fotografia cyfrowa, badania naukowe, diagnostyka medyczna, robotyka mobilna, rynek pojazdów autonomicznych – to tylko niektóre obszary technologii, w których czujniki obrazu odgrywają niebywale ważną rolę. Nic więc dziwnego, że przez blisko sto lat intensywnego rozwoju zdołaliśmy przejść od prostych lamp analizujących do supernowoczesnych matryc o rozdzielczości 200 milionów punktów, wyspecjalizowanych urządzeń, zdolnych do rejestracji obrazów złożonych z pojedynczych fotonów, czy też kamer iToF, które z łatwością generują obrazy głębi sceny w czasie rzeczywistym. Najmniejsze kamery – opracowane do zastosowań medycznych – mają dziś wymiary na poziomie ułamka milimetra. Pomimo tak niebywałych osiągnięć współczesnej optoelektroniki, wciąż mamy problemy z wieloma zagadnieniami, które spędzają sen z powiek naukowcom i inżynierom – walczymy z prawami fizyki (chociażby z szumem termicznym), poszukujemy nowych materiałów zdolnych do rejestracji odległych zakątków widma elektromagnetycznego, sukcesywnie „podkręcamy” tempo akwizycji ramek obrazu. Ba! Zaprzęgamy nawet sztuczną inteligencję do zadań związanych z poprawianiem niedoskonałości technologii, od której wymagamy coraz więcej i więcej. Co czeka nas w przyszłości? Jedno jest pewne – sukcesywnie zbliżamy się do granicy wykonalności, poniżej której dalsze zmniejszanie pikseli i podwyższanie rozdzielczości nie będą już po prostu możliwe, a jeśli nawet – to i tak pozbawione będą jakiegokolwiek sensu. Fizyki jeszcze nikomu nie udało się oszukać.

inż. Przemysław Musz, EP

Zaloguj

Zaloguj