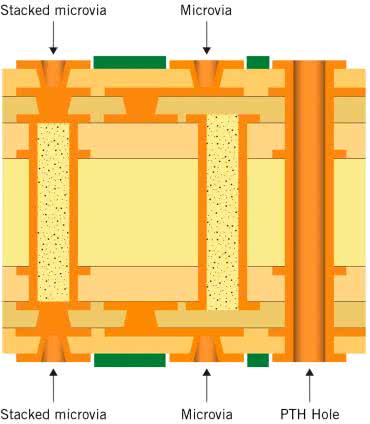

W materiale pt. Zagadnienia materiałowe w produkcji wielowarstwowych obwodów drukowanych omówiliśmy szereg aspektów, związanych z parametrami rdzeni, prepregów i folii miedzianej, stosowanych do budowy stosu PCB. Nie mniej ważne, niż odpowiedni dobór materiałów, są również kwestie efektywnego użycia dostępnej liczby warstw czy też użycia różnych rodzajów przelotek. Te ostatnie są zresztą najczęściej dyskutowanym zagadnieniem podczas omawiania płyt typu HDI (fotografia 1) - to właśnie dzięki rozbudowanej technologii produkcji przelotek możliwe jest ciągłe zwiększanie gęstości połączeń, nierzadko za pomocą najbardziej zaawansowanych technik, które do niedawna dostępne były tylko dla nielicznych światowych koncernów.

Budowa stosu z układowego punktu widzenia - warstwy sygnałowe, płaszczyzny masy i zasilania

Określenie liczby warstw jest zwykle jedną z pierwszych czynności, które wykonuje każdy projektant płyty wielowarstwowej. Na tę decyzję wpływają nie tylko czynniki techniczne, ale także ekonomiczne - pomimo że zdecydowana większość współczesnych fabryk PCB oferuje możliwość wytworzenia przynajmniej podstawowych rodzajów obwodów 4-, 6- czy 8-warstwowych, to wciąż ich cena jest znacznie wyższa niż w przypadku obwodów 2-warstwowych. I jak zwykle bywa, także tutaj kompromis jest rozwiązaniem najlepszym - zbyt duża liczba warstw niepotrzebnie zwiększa koszty i wydłuża czas produkcji, zaś zbyt mała - ogranicza możliwości projektanta zarówno w zakresie podstawowego trasowania ścieżek, jak i optymalizacji projektu pod względem kompatybilności elektromagnetycznej, jakości sieci zasilających czy też osiągów w kwestii odprowadzania nadmiaru ciepła.

Niektóre zasady dobrej praktyki projektowej obowiązują niemal zawsze, niezależnie od stopnia złożoności urządzenia oraz liczby warstw. Elementem każdej płyty wielowarstwowej o znaczeniu krytycznym dla poprawnego działania całości jest przynajmniej jedna, solidna płaszczyzna masy, pozbawiona (w miarę możliwości) jakichkolwiek większych wycięć. Zadań takiej warstwy jest wiele - pełni ona funkcję podstawowego ekranu oraz płaszczyzny odniesienia dla ścieżek paskowych i mikropaskowych, dystrybuuje potencjał "zerowy" dla wszystkich obwodów znajdujących się na płycie, a także przewodzi prądy powrotne, sprzężone z przebiegami przesyłanymi za pomocą ścieżek, znajdujących się na sąsiadujących warstwach sygnałowych. I właśnie ciągłość masy jest jednym z najistotniejszych zagadnień, poruszanych przez znawców tematyki EMC oraz integralności sygnałów, zwłaszcza w szybkich systemach cyfrowych.

Dobra masa to podstawa - znaczenie płaszczyzny masy dla EMC i integralności sygnałów

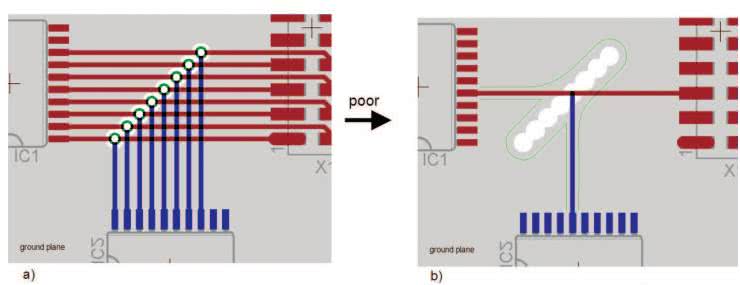

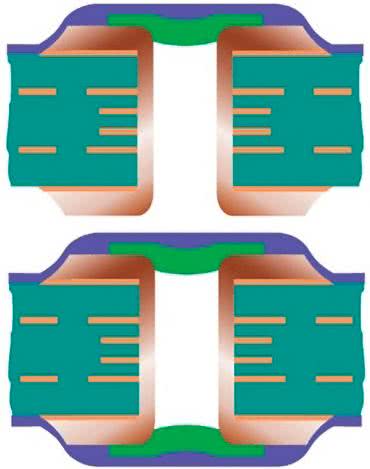

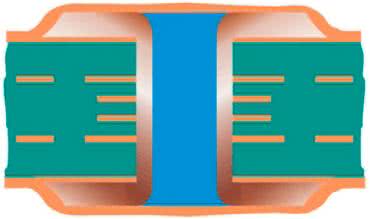

Przykładem typowego błędu, popełnianego niestety przez wielu projektantów, jest układanie przelotek sygnałowych w odstępach tak małych, że (przy przyjętych regułach DRC w zakresie odstępów izolacyjnych) antypady "zlewają się", co skutkuje powstaniem podłużnego obszaru pozbawionego połączenia z masą (rysunek 1). Choć pozornie ów błąd nie powinien stanowić większego problemu, to w rzeczywistości taka nieciągłość sprawia, że prąd powrotny musi "omijać" cały rząd przelotek, co prowadzi do wytworzenia swego rodzaju "pętli", obejmującej swoim zasięgiem niepotrzebnie spory obszar PCB.

Tymczasem już niewielka zmiana, polegająca na nieznacznym rozsunięciu przelotek i ustawieniu ich w dwóch naprzemiennych rzędach, sprawia, iż prądy powrotne mogą swobodnie przepływać pomiędzy antypadami (rysunek 2), co wydatnie ogranicza długość ścieżki prądowej - a to wystarczy, by zmniejszyć emisję zakłóceń i zredukować poziom szumów, propagowanych za pośrednictwem masy.

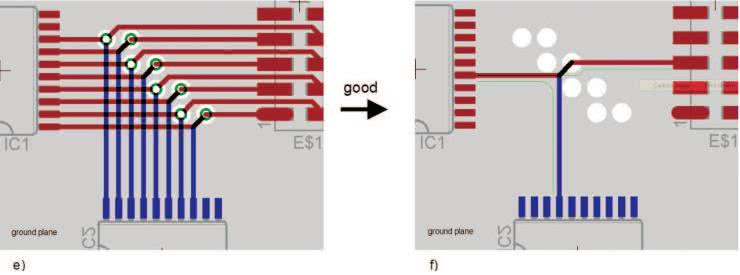

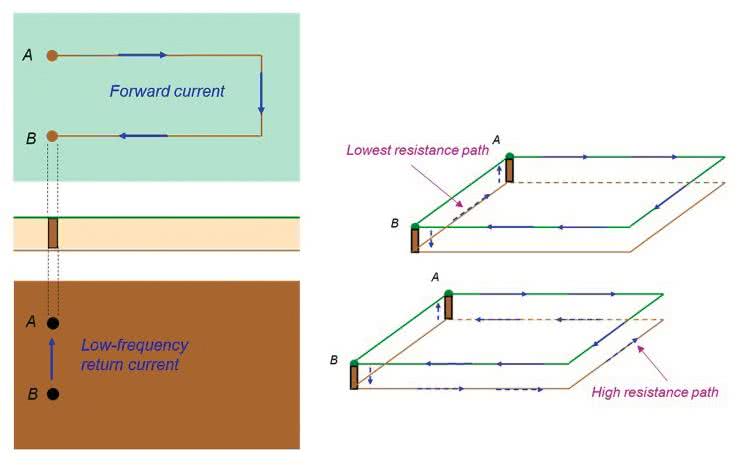

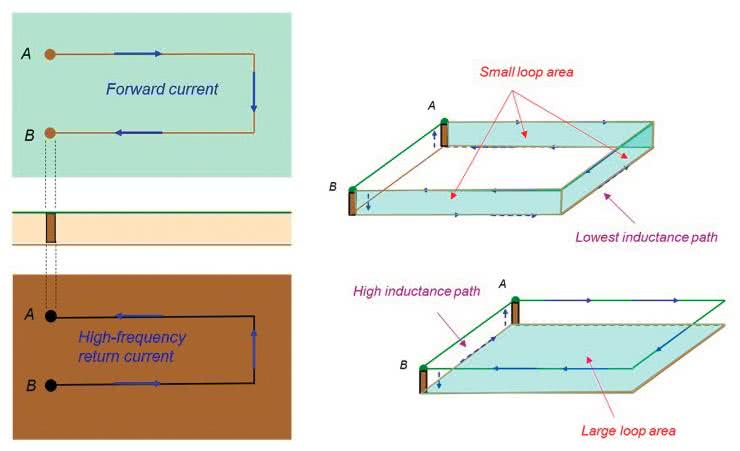

Opisane zjawisko warto zrozumieć dokładniej, gdyż dotyczy ono znacznie szerszego zakresu zagadnień projektowych niż tylko wspomnianych grup przelotek. Na rysunku 3 pokazano prosty, teoretyczny model obwodu, złożonego z dwóch punktów A i B, znajdujących się pod napięciem stałym lub przemiennym o niskiej częstotliwości i połączonych za pomocą pętli przewodnika na górnej warstwie oraz masy na dolnej.

Jak widać, choć trasa prądu na górnej warstwie jest wymuszona przez kształt ścieżki, to już na płaszczyźnie masy to ograniczenie nie istnieje - prąd powraca do punktu A drogą o najniższej rezystancji, czyli po prostu… wzdłuż odcinka B-A. W miarę wzrostu częstotliwości rośnie także znaczenie indukcyjności wypadkowej - preferowaną drogą prądu na płaszczyźnie masy będzie już trasa o najniższej indukcyjności, tj. taka, która - wraz z górną ścieżką sygnałową - zamyka pętlę o możliwie najmniejszym polu powierzchni. Takiej właśnie sytuacji odpowiada rysunek 4 - z uwagi na znikomą grubość dielektryka pole będzie najmniejsze, gdy droga powrotna będzie znajdowała się tuż pod ścieżką górną.

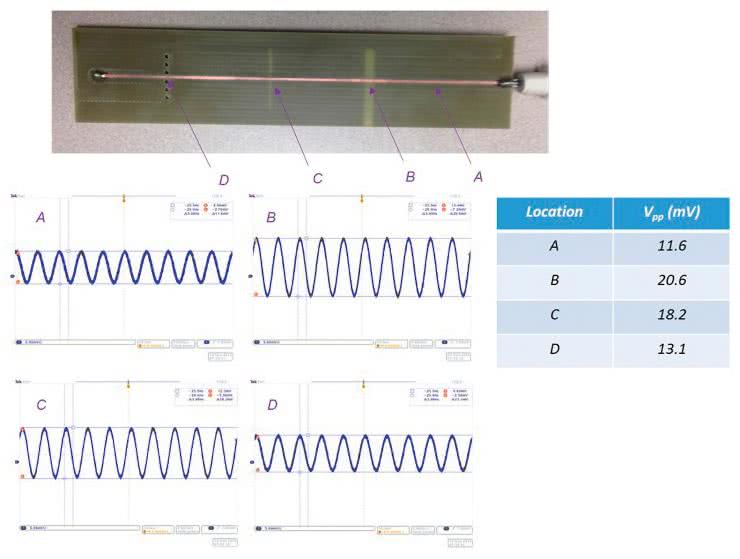

Słuszność powyższego opisu można zresztą bardzo łatwo udowodnić prostym eksperymentem. Na rysunku 5 pokazano oscylogramy, zarejestrowane w czterech punktach prostej płytki testowej, która w płaszczyźnie masy ma trzy przeszkody (widoczne na fotografii w punktach B, C i D). Gęstość prądu zmierzono w sposób pośredni, poprzez przyłożenie sondy pola bliskiego (typu H, czyli rejestrującej pole magnetyczne), podłączonej do wejścia oscyloskopu. Najsilniejszy sygnał zarejestrowano w punkcie B - tam prąd musi "przeciskać się" przez wąski pasek miedzi, pozostawiony tylko na jednym brzegu płytki. Przeszkoda umieszczona w punkcie C pozwala na przepływ prądu po obydwu stronach ubytku miedzi (tutaj amplituda sygnału jest już nieco niższa), zaś rząd otworów w punkcie D odpowiada opisanej wcześniej grupie przelotek (w tym przypadku jednak pozbawionych antypadów, a więc nieblokujących całkowicie przepływu prądu pomiędzy otworami - z tego względu amplituda sygnału jest tylko nieznacznie wyższa niż w punkcie referencyjnym A).

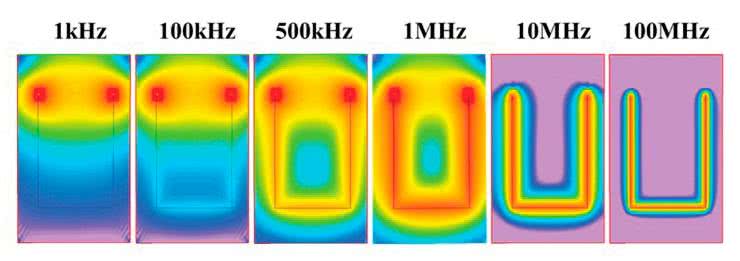

Warto jeszcze rzucić okiem na wyniki symulacji rozkładu gęstości prądu, pokazane na rysunku 6 - im wyższa częstotliwość, tym silniej prąd "skupia się" wokół ścieżki sygnałowej. Jak widać, już dla 100 kHz część prądu zaczyna "uciekać" z linii najmniejszego oporu i tworzyć "cień" ścieżki sygnałowej, zaś powyżej 1 MHz ów "cień" dominuje w coraz wyższym stopniu. Pokazane wyniki jasno pokazują, jak wielkie znaczenie dla obwodów wielowarstwowych ma solidna, jednolita płaszczyzna masy - swobodny przepływ prądów powrotnych pod ścieżkami prowadzącymi szybkie sygnały (zwłaszcza cyfrowe) pozwala nie tylko znacząco zmniejszyć natężenie zakłóceń RFI (im mniejsza pętla prądowa, tym słabsza emisja i mniejszy wpływ na pobliskie obwody), ale także może poprawić integralność sygnałów dzięki zachowaniu najmniejszej możliwej indukcyjności przy zadanej geometrii i długości ścieżki sygnałowej.

Konfiguracje stosu warstw w zależności od aplikacji

Z matematycznego punktu widzenia wraz ze zwiększaniem liczby warstw PCB drastycznie rośnie także liczba możliwych do zastosowania konfiguracji ich ułożenia. W praktyce zdecydowana większość płyt wielowarstwowych jest oparta na pewnych powtarzalnych schematach, sensownych z punktu widzenia czterech głównych czynników:

- integralności sygnałów,

- efektywności sieci zasilających,

- kontroli impedancji,

- kompatybilności elektromagnetycznej.

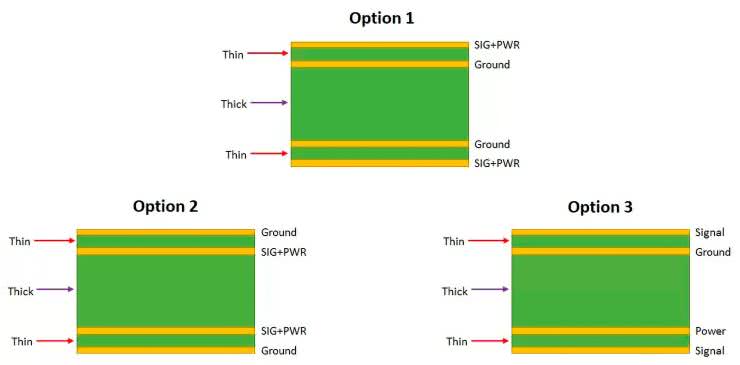

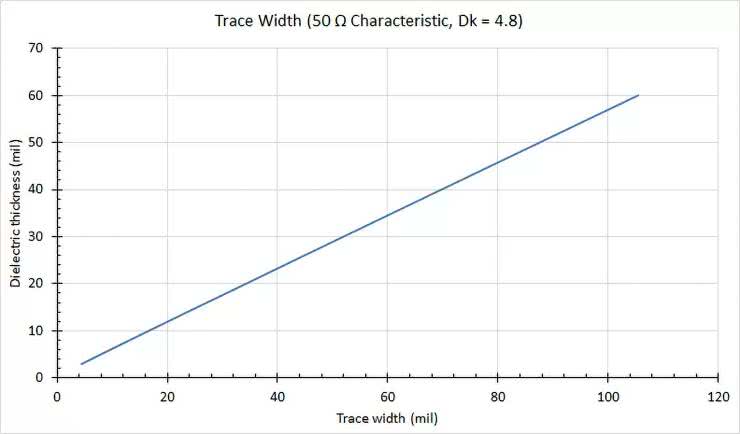

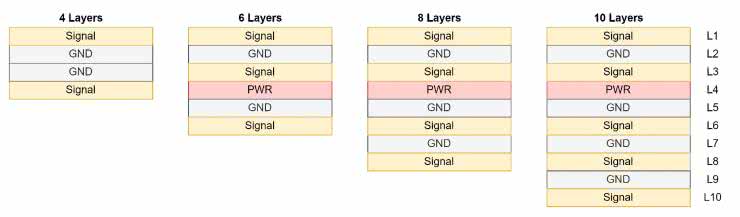

W przypadku PCB 4-warstwowych warte rozważenia są trzy główne koncepcje, pokazane schematycznie na rysunku 7. Opcja pierwsza używa dwóch wewnętrznych warstw do utworzenia płaszczyzn masy, zaś wszystkie ścieżki sygnałowe oraz zasilające są rozdysponowane na warstwach zewnętrznych. Taka konstrukcja pozwala na prowadzenie szybkich linii transmisyjnych (np. USB, HDMI czy LVDS), obwodów RF czy też wszelkiego rodzaju innych interfejsów, wymagających wysokiej częstotliwości pracy i dokładnie kontrolowanej impedancji. Ponieważ w wielu projektach stosowana jest budowa stosu typu foil build (więcej informacji na ten temat można znaleźć w artykule pt. Zagadnienia materiałowe w produkcji wielowarstwowych obwodów drukowanych), odległość pomiędzy płaszczyzną masy a warstwą zewnętrzną po tej samej stronie płytki drukowanej jest zwykle niewielka (i określona tylko przez finalną grubość prepregu). To zaś umożliwia wydatną redukcję szerokości ścieżek, która - dla ustalonej impedancji charakterystycznej i stałej dielektrycznej prepregu - zmienia się wprost proporcjonalnie do grubości dielektryka (patrz rysunek 8). Niestety, stos wg opcji 1 ma także swoje wady - wymusza konieczność zmieszczenia wszystkich sygnałów i ścieżek zasilania na dwóch warstwach, nie ekranuje linii mikropaskowych przed zewnętrznymi zakłóceniami RFI oraz nie zapewnia tłumienia zaburzeń elektromagnetycznych, promieniowanych przez obwody znajdujące się na zewnętrznych warstwach PCB. Doskonała jest natomiast separacja pomiędzy ścieżkami, znajdującymi się na warstwach top i bottom.

Opcja 2 według rysunku 7 jest dokładnym odwróceniem poprzednio opisanej koncepcji - tym razem sygnały i zasilanie znajdują się wewnątrz "kanapki", utworzonej przez zewnętrzne płaszczyzny masy. Takie rozwiązanie zapewnia perfekcyjne osiągi PCB pod względem emisji i podatności EMI, ale naraża linie sygnałowe na przesłuchy z warstwy leżącej naprzeciwko. Co ważne, także w tym przypadku istnieje możliwość prowadzenia szybkich ścieżek sygnałowych o kontrolowanej impedancji na dwóch warstwach, ale - niestety - z pewną dość istotną wadą: każde wyprowadzenie elementu SMD (oprócz pinów masy) musi być wprowadzone w głąb PCB za pomocą przelotki, co dodaje pewną indukcyjność i samo w sobie pogarsza nieco integralność sygnałów.

Opcja 3 jest natomiast najlepszym wyborem w przypadku urządzeń, w których liczba połączeń o kontrolowanej impedancji jest niewielka - wszelkie sygnały niskoczęstotliwościowe lub DC można zatem prowadzić na warstwie zewnętrznej przylegającej do płaszczyzny zasilania, a warstwę leżącą po stronie masy warto przeznaczyć do wszystkich bardziej wymagających połączeń. Ta konfiguracja stosu lepiej sprawdza się także w przypadku układów o większym poborze mocy, gdyż duża powierzchnia płaszczyzny zasilania pozwala na znaczne podwyższenie amperażu w porównaniu do (nawet szerokich) ścieżek, które prowadzone byłyby w warstwie sygnałowej. Mało tego - płaszczyznę zasilania można podzielić na kilka mniejszych obszarów, odpowiedzialnych za dystrybucję różnych napięć zasilania do poszczególnych części obwodu (rysunek 9).

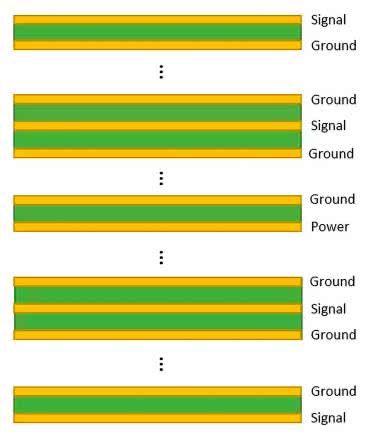

W przypadku liczby warstw przekraczającej 4 zasady przyporządkowania poszczególnych płaszczyzn do określonych celów są analogiczne, do pokazanych do tej pory. I tak każda warstwa sygnałowa powinna być w miarę możliwości oddzielona od pozostałych płaszczyzną masy, zaś płaszczyzna zasilania oraz jedna z mas powinny tworzyć parę, przedzieloną tylko cienką warstwą dielektryka (prepregu lub rdzenia o niewielkiej grubości). To ostatnie jest szczególnie ważne, zważywszy na doskonałe właściwości pojemności rozproszonej, tworzącej swego rodzaju jeden wielki kondensator odsprzęgający o powierzchni całej płytki. Takie rozwiązanie doskonale poprawia właściwości obwodu wielowarstwowego w zakresie integralności sygnałów oraz emisji RFI.

Porównanie klasycznych stosów 4-, 6-, 8- i 10-warstwowego pokazano na rysunku 10, natomiast ogólną zasadę ekstrapolacji opisanych powyżej reguł ilustruje rysunek 11.

Rodzaje przelotek

Przelotki stanowią jedno z fundamentalnych zagadnień w projektowaniu płyt wielowarstwowych. To właśnie szeroki wachlarz możliwości technologicznych, oferowanych przez najbardziej zaawansowanych producentów PCB w zakresie wytwarzania różnych typów przelotek, umożliwia ciągłe przesuwanie granic miniaturyzacji i sukcesywne zwiększanie gęstości połączeń.

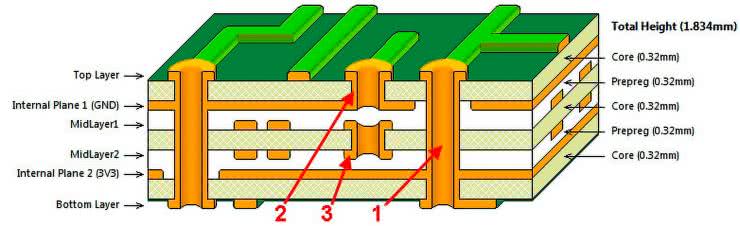

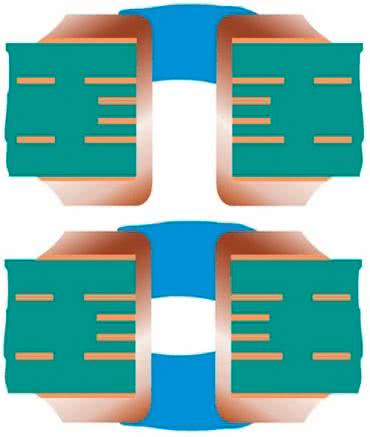

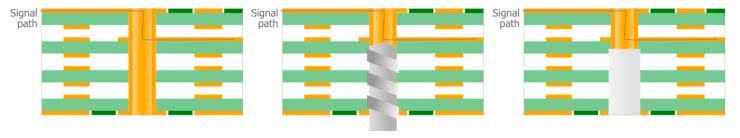

Na rysunku 12 pokazano schematycznie trzy podstawowe rodzaje przelotek, stosowanych w standardowych płytach wielowarstwowych. Przelotki określane mianem PTH to zwyczajne otwory metalizowane, przechodzące przez cały stos PCB - wykonywane dokładnie tak, jak otwory w padach elementów THT. Przelotki ślepe zaczynają się na jednej z warstw zewnętrznych i kończą wewnątrz stosu, zaś przelotki zagrzebane są całkowicie ukryte wewnątrz PCB. Zaletą tych dwóch ostatnich jest możliwość zaoszczędzenia miejsca na jednej, a nawet dwóch warstwach zewnętrznych, co niebywale ułatwia trasowanie ścieżek i rozmieszczanie komponentów na obszarach płytki o zwiększonej gęstości upakowania podzespołów.

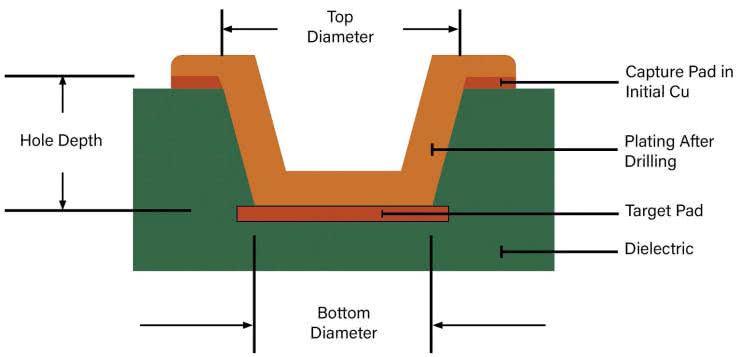

Kolejnym rodzajem przelotek, bez którego trudno wyobrazić sobie współczesną elektronikę, są tzw. mikroprzelotki - norma IPC-T-50M definiuje je jako ślepe przelotki o maksymalnym stosunku wymiarów (tzw. aspect ratio) równym 1:1 (tj. głębokość: średnica zewnętrzna - patrz rysunek 13), kończące się na padzie docelowym i mające głębokość nieprzekraczającą 0,25 mm (licząc od folii miedzianej, od której przelotka się zaczyna, aż do powierzchni padu docelowego).

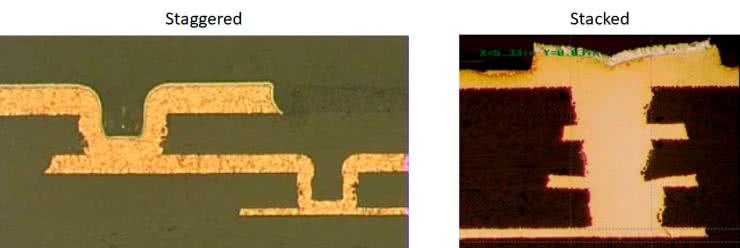

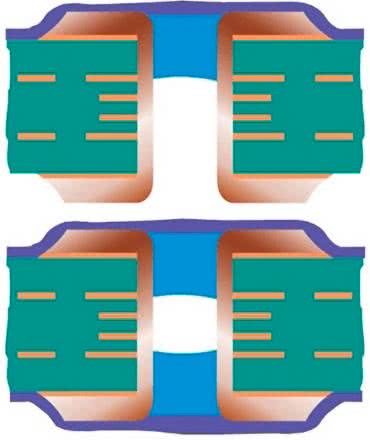

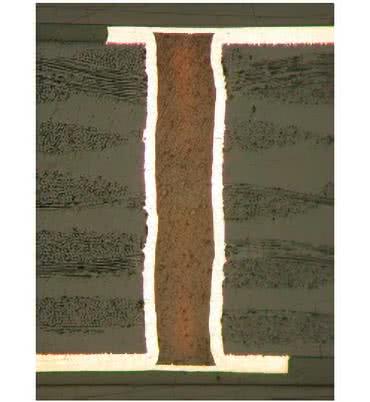

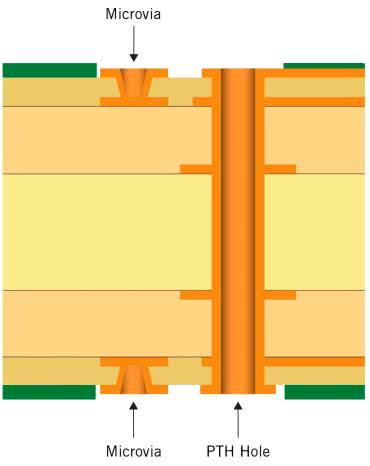

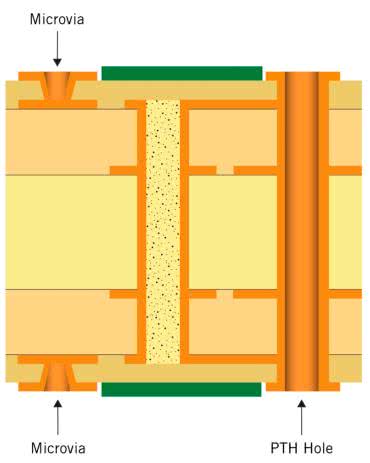

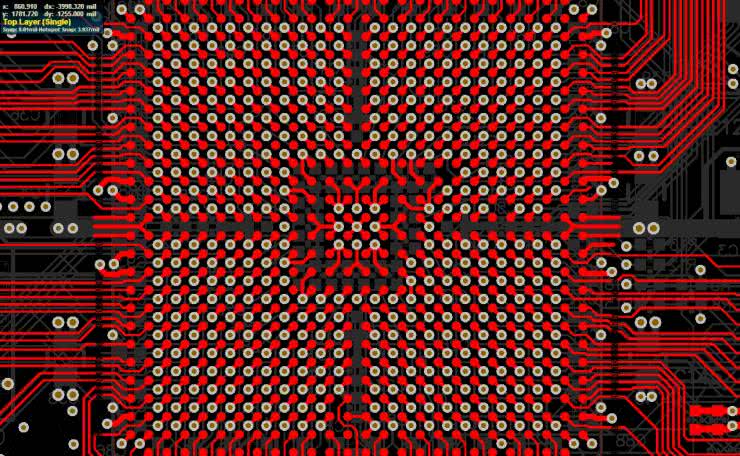

Podobną definicję znajdujemy także w standardzie IPC-6012. Warto zwrócić uwagę, że mikroprzelotki - w odróżnieniu od klasycznych przelotek PTH, ślepych oraz zagrzebanych - nie są łączone z dolną warstwą za pomocą wykonanego w niej otworu, ale niejako "przyklejają się" do pełnego padu swoim dnem. Taka konstrukcja ma swoje zalety - pozwala wykonywać naprawdę miniaturowe połączenia pomiędzy sąsiadującymi ze sobą warstwami, zaś połączenie kolejnych warstw jest możliwe z użyciem trzech technik: przelotek typu skip (tj. kończących się nie na sąsiadującej warstwie, lecz na kolejnej, z pominięciem warstwy pośredniczącej), staggered (kolejna przelotka zaczyna się na padzie, połączonym z padem docelowym przelotki leżącej o jedną warstwę wyżej) oraz stacked (dwie lub więcej przelotek jest ustawionych jedna na drugiej w postaci konstrukcji piętrowej) - patrz fotografia 2.

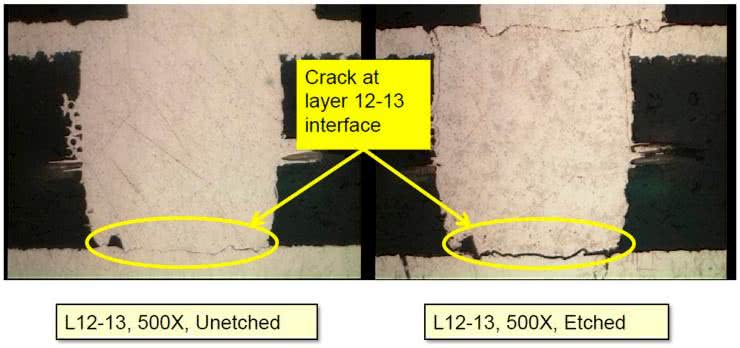

Niestety, pomimo niewątpliwych zalet, mikroprzelotki mają także swoje wady - zauważono bowiem, że ten typ łączenia warstw jest podatny na uszkodzenia termomechaniczne, powodujące oderwanie metalizacji przelotki od padu docelowego, co można zobaczyć na fotografii 3.

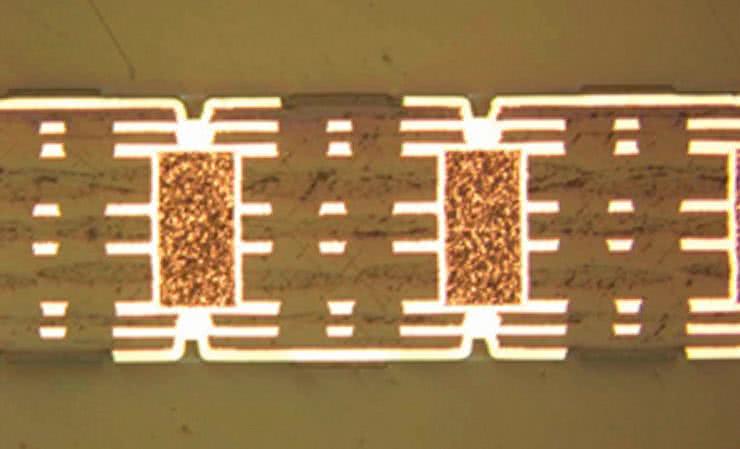

Oprócz zachowania prawidłowych warunków obróbki płyt bazujących na mikroprzelotkach, na niezawodność wpływa także liczba przelotek ustawionych piętrowo - zalecane są stosy co najwyżej dwóch przelotek, zaś w przypadku konieczności połączenia większej liczby warstw warto posiłkować się konstrukcją mieszaną (stacked-staggered). Warto także dodać, że mikroprzelotki mogą współpracować również ze standardowymi przelotkami zagrzebanymi, przy czym te ostatnie zawsze muszą zostać odpowiednio wypełnione - przykład takiej konstrukcji można zobaczyć na fotografii 4.

Kwestia wypełniania lub zabezpieczania przelotek z zewnątrz jest zresztą znacznie szersza i obejmuje siedem klas głównych, określonych w normie IPC-4761.

- Przelotki typu I wg IPC-4761 (rysunek 14) są wykonywane z użyciem tzw. tentingu, czyli pokrywania soldermaską z jednej lub obu stron; należy pamiętać, że nie jest to całkowite zabezpieczenie, a jedynie zgrubna osłona brzegów (pierścienia przelotki) - całkowite zatkanie otworu jest możliwe tylko dla przelotek bardzo małych (zwykle poniżej 0,3 mm), zaś większe otwory powodują wpływanie (stosunkowo rzadkiej) soldermaski do wnętrza i częściowe pokrywanie metalizacji. Jednostronne pokrycie (typ I-A) jest niezalecane z uwagi na ryzyko "pułapkowania" zanieczyszczeń chemicznych (np. resztek topnika o bardziej agresywnych właściwościach), mogących prowadzić do korozji metalizacji. Lepszą metodą jest zatem dwustronny tenting (typ I-B).

- Przelotki typu II wg IPC-4761 (rysunek 15) - w tym przypadku przelotki są pokrywane z jednej (II-A) lub dwóch stron (II-B) nie tylko podstawową soldermaską (tzw. suchą), ale także dodatkową warstwą soldermaski "mokrej" - takie rozwiązanie zapewnia lepszą osłonę wnętrza otworu przed czynnikami zewnętrznymi (oczywiście tylko w przypadku II-B, gdyż II-A nie jest rekomendowany z opisanego wcześniej powodu).

- Przelotki typu III wg IPC-4761 (rysunek 16) - tzw. przelotki zatykane (III-A, III-B) za pomocą dielektryka, np. epoksydu. Takie zabezpieczenie (zastosowane dwustronnie) całkowicie redukuje ryzyko penetracji przelotki przez lutowie lub zanieczyszczenia.

- Przelotki typu IV wg IPC-4761 (rysunek 17) - modyfikacja przelotek typu III z użyciem dodatkowego pokrycia za pomocą soldermaski mokrej (IV-A, IV-B).

- Przelotki typu V wg IPC-4761 (rysunek 18) - w tym przypadku światło otworu jest wypełniane dielektrykiem na całej długości.

- Przelotki typu VI wg IPC-4761 (rysunek 19) - modyfikacja przelotek typu V z dodatkowym pokryciem soldermaską suchą lub mokrą.

- Przelotki typu VII wg IPC-4761 (rysunek 20) - najdroższa w realizacji i najbardziej złożona technologicznie metoda, polegająca na wypełnieniu wnętrza przelotki, a następnie zastosowaniu metalizacji na całej jej średnicy.

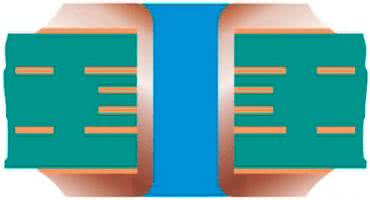

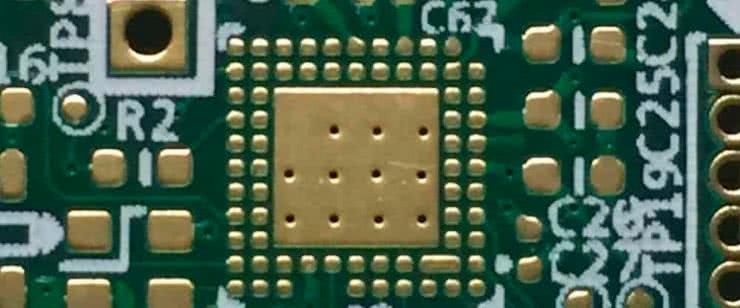

Warto dodać, że przelotki mogą być wypełniane nie tylko dielektrykiem, ale także przewodzącym polimerem (zwykle na bazie zawiesiny miedzi lub srebra w żywicy epoksydowej), a nawet… miedzią. Ten ostatni rodzaj wypełnienia jest szczególnie cenny z uwagi nie tylko na znaczną poprawę warunków elektrycznych (obniżenie rezystancji, wzrost obciążalności prądowej), ale także doskonałe parametry termiczne. Dlatego też przelotki wypełnione miedzią stanowią idealne rozwiązanie w przypadku chłodzenia elementów dużej mocy, np. układów scalonych SMD z padem termicznym. Należy pamiętać, że zastosowanie przelotek w padzie (ang. via-in-pad) jest możliwe tylko wtedy, gdy zostaną one uprzednio poddane tzw. planaryzacji, czyli procesowi polegającemu na mechanicznej obróbce powierzchni zewnętrznej przelotki tak, by licowała ona z powierzchnią pozostałych padów. Przekrój tak wykonanej przelotki można zobaczyć na fotografii 5.

Obwody HDI

Podstawowa definicja obwodów HDI (ang. High Density Interconnect) określa je jako płytki drukowane o gęstości połączeń (przypadającej na jednostkę powierzchni) wyższej w porównaniu do konwencjonalnych PCB. W rzeczywistości HDI to synonim nowoczesnych, wysoce zaawansowanych obwodów, wytwarzanych z użyciem technik dalece wykraczających poza ogólne standardy produkcji PCB. Typowym widokiem, spotykanym na płytkach HDI, są ultraminiaturowe komponenty pasywne w rozmiarach 0201, 01005, a nawet mniejszych (fotografia 6) oraz układy scalone w obudowach BGA, CSP itp.

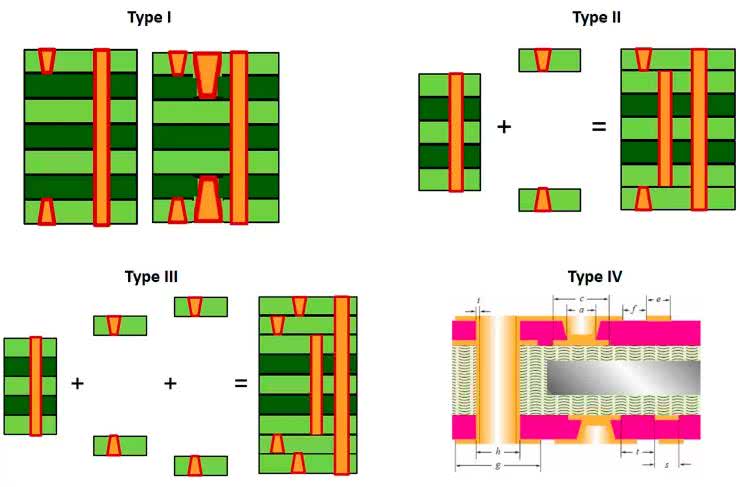

Norma IPC-2226 definiuje sześć odmian obwodów HDI, zaś główną rolę w rozróżnieniu poszczególnych typów PCB grają przelotki. Trzy podstawowe typy obwodów (I, II, III) mają następującą konstrukcję:

- struktura HDI typu I wg IPC-2226 (rysunek 21) dopuszcza stosowanie przelotek typu PTH oraz mikroprzelotek na warstwach zewnętrznych,

- struktura HDI typu II wg IPC-2226 (rysunek 22) stanowi rozszerzenie typu I o przelotki zagrzebane, wykonywane metodą standardową,

- struktura HDI typu III wg IPC-2226 (rysunek 23) rozszerza typ II o mikroprzelotki zagrzebane, zaczynające się na warstwach leżących bezpośrednio pod warstwami zewnętrznymi (a zatem wchodzą tutaj w grę także przelotki typu stacked i staggered).

Choć taki podział może wydawać się nieco sztuczny, to w istocie ma on naprawdę jasny sens praktyczny. Aby lepiej zrozumieć filozofię trzech opisanych rodzajów PCB, warto przyjrzeć się schematom procesów produkcji, pokazanym na rysunku 24. Płytki typu I są laminowane w jednym, wspólnym procesie - otwory mikroprzelotek mogą być wykonane w warstwach zewnętrznych jeszcze przed sprasowaniem całego stosu, zaś otwory PTH - już po laminacji. W przypadku typu II stosowany jest już proces laminacji sekwencyjnej - najpierw powstaje zestaw warstw o numerach od 2 do (n-1), potem mogą nastąpić wiercenia przelotowe (które staną się podstawą przelotek zagrzebanych), a na samym końcu dodawane są warstwy zewnętrzne z otworami pod mikroprzelotki. Typ III korzysta z tej samej filozofii, ale laminacja odbywa się w trzech sekwencjach, stąd możliwość wytworzenia także mikroprzelotek zagrzebanych, rozpoczynających się na warstwach 2 i (n-1).

Na rysunku 24 można także zobaczyć schemat płytki typu IV wg IPC-2226. W tej konfiguracji (spotykanej w praktyce nieporównanie rzadziej niż typy I...III) wnętrze płytki stanowi tzw. rdzeń pasywny - niebiorący udziału w budowie obwodów, a jedynie pełniący funkcję radiatora, kompensatora rozszerzalności termicznej pozostałych warstw czy też dodatkowego ekranu.

Typ V wg IPC-2226 to już tzw. obwody bezrdzeniowe (rysunek 25). Wszystkie warstwy są wykonywane parami, z mikroprzelotkami łączącymi odpowiednie punkty obwodu, leżącego po obydwu stronach każdego z dielektryków. Na koniec wszystkie arkusze są laminowane w ramach pojedynczego procesu (co odróżnia go od laminacji sekwencyjnej, stosowanej w typach II i III), zaś ewentualne połączenia pomiędzy warstwami leżącymi na sąsiadujących ze sobą arkuszach są wykonywane z użyciem… pasty przewodzącej prąd elektryczny.

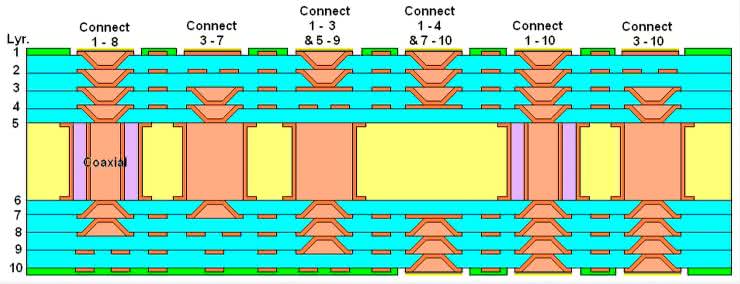

Najbardziej złożonym typem struktury płyt HDI jest typ VI, określany mianem ELIC (od ang. Every Layer InterConnect bądź any-layer HDI). Jak sama nazwa wskazuje, możliwe jest połączenie ze sobą dowolnych zestawów sąsiadujących ze sobą warstw, gdyż wszystkie przejścia są wykonywane za pomocą mikroprzelotek piętrowych. Jak nietrudno zauważyć, sama definicja tej struktury stoi w opozycji do opisanego wcześniej zalecenia, aby unikać piętrowych zestawów zawierających więcej niż dwie mikroprzelotki (standard IPC-2226 powstał przed opracowaniem ww. zalecenia). Warto dodać, że nieliczni producenci oferują niebywale zaawansowaną technologię, określaną czasem mianem coaxial via lub via-in-via, polegającą na budowie przelotki… wewnątrz większej przelotki, wypełnionej uprzednio dielektrykiem. Przewiercenie utwardzonego izolatora i ponowna metalizacja umożliwia zatem "przepuszczenie" koncentrycznej przelotki w świetle innej, o nieco większej średnicy. Taką skomplikowaną strukturę pokazano schematycznie na rysunku 26.

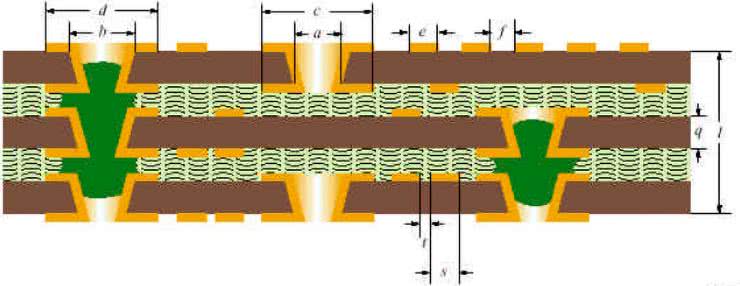

Omawiając złożoną tematykę przelotek, nie sposób nie wspomnieć o jeszcze jednej technice, określanej mianem CDD (ang. Controlled Depth Drilling) lub back-drilled via. Celem tej metody jest ograniczenie niepotrzebnie długiej części przelotki PTH, która łączy tylko kilka warstw położonych po jednej stronie PCB. Przelotka jest zatem wykonywana tak, jak zwykły otwór metalizowany na całej grubości płytki, po czym precyzyjnie ustawiona wiertarka numeryczna… usuwa niepotrzebną część metalizacji za pomocą wiertła (o średnicy nieznacznie większej niż średnica otworu bazowego), wprowadzonego na ściśle określoną głębokość. Schemat procesu pokazano na rysunku 27. A jaki sens ma rozwiercanie utworzonej wcześniej metalizacji? Po pierwsze, poprawia się w ten sposób integralność sygnałów, gdyż odbicia z używanej części przelotki pogarszają warunki transmisji. Po drugie, "wisząca" część metalizacji pełni funkcję miniaturowej anteny, która może nie tylko zwiększać emisję zakłóceń RFI, ale także podwyższać podatność czułego obwodu na przesłuchy z innych źródeł EMI.

Zagadnienia projektowania obwodów dla układów BGA

Układy w obudowach BGA są nierozerwalnie związane z technologią HDI, umożliwiają bowiem znaczną miniaturyzację PCB przy zachowaniu dużej liczby wyprowadzeń (często znacznie przekraczającej 100). Im większa macierz padów, tym więcej warstw może być potrzebnych do wyprowadzenia wszystkich niezbędnych linii sygnałowych i zasilających, zaś wraz ze zmniejszaniem rastra wyprowadzeń coraz trudniejsze może być zachowanie niezbędnych odstępów minimalnych oraz szerokości ścieżek, możliwych do wykonania przez wybranego producenta PCB. W przypadku układów o rastrze powyżej 0,5 mm dobrym i stosunkowo prostym rozwiązaniem (przynajmniej z technologicznego punktu widzenia) jest zastosowanie layoutu określanego mianem dog-bone. Polega on na połączeniu każdego z padów z niewielką przelotką, umieszczoną dokładnie pośrodku wolnej przestrzeni między sąsiadującymi padami - taka konstrukcja przypomina kształtem psią kość, stąd też charakterystyczna nazwa tej metody wyprowadzania pinów (tzw. fanoutu). Przykład można zobaczyć na rysunku 28 - warto dodać, że ogromną pomocą dla projektantów są funkcje programów EDA, zapewniające automatyczny fanout padów (taką opcję można znaleźć m.in. w środowisku Altium Designer).

Drugą metodą na wyprowadzenie padów BGA do warstw leżących głębiej w stosie PCB jest zastosowanie przelotek w padach (via-in-pad), rzecz jasna wykonanych z dokładną planaryzacją (fotografia 7).

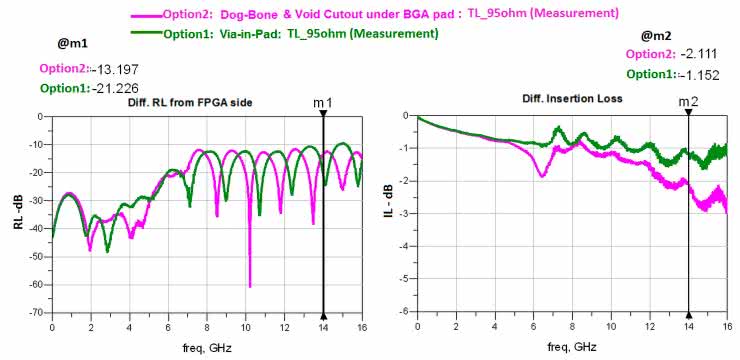

Choć to rozwiązanie jest znacznie bardziej złożone technologicznie (wymaga bowiem najbardziej rozbudowanego procesu z użyciem przelotek typu VII), to zapewnia szereg zalet: umożliwia pracę z rastrem BGA nawet znacznie poniżej 0,5 mm, znacząco poprawia odprowadzanie ciepła, podwyższa rating napięciowy (umożliwia bowiem pełne wykorzystanie dostępnych odstępów izolacyjnych), a jednocześnie - co też ważne - poprawia osiągi w zakresie integralności sygnałów. Choć na pierwszy rzut oka może się to wydawać mało prawdopodobne, nawet tak króciutki odcinek ścieżki w topologii fanoutu typu dog-bone (mający długość poniżej 1 mm) stanowi już dodatkową indukcyjność, której efekty są w pełni mierzalne. Za dowód niech posłużą wykresy z pomiarów porównawczych, dostępne w dokumentacji FPGA marki Intel - badanie strat odbiciowych i wtrąceniowych, przeprowadzone dla fanoutów via-in-pad oraz dog-bone, jasno wskazują wyższość tych pierwszych w zakresie ultraszybkich sygnałów cyfrowych i analogowych (zwłaszcza w paśmie powyżej 10 GHz - patrz rysunek 29).

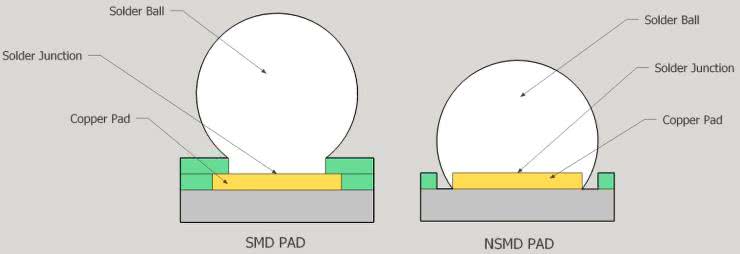

W przypadku padów BGA należy zwrócić uwagę na rodzaj zastosowanej techniki ograniczania powierzchni lutu (rysunek 30). Dostępne są dwie metody: SMD (ang. Solder Mask Defined) oraz NSMD (ang. Non-Solder Mask Defined). W pierwszym przypadku średnica padu jest nieco większa, zaś ogranicza ją odpowiednio ukształtowane wycięcie w soldermasce, w drugim zaś powierzchnię lutu definiuje faktyczny rozmiar padu, podczas gdy otwarcie soldermaski jest nieco szersze i w formie wąskiego pierścienia odsłania częściowo samo podłoże (prepreg lub rdzeń). W większości przypadków preferowaną metodą jest użycie padów NSMD, z uwagi na nieco prostszy proces produkcyjny (niewymagający wyśrubowanej precyzji nakładania soldermaski) oraz lepszy kontakt lutowia z powierzchnią padu.

PCB sztywno-giętkie

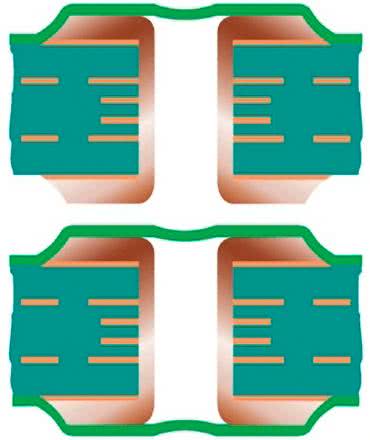

Na koniec zahaczymy jeszcze krótko o kolejny, niezwykle złożony temat obwodów sztywno-giętkich (rigid-flex - fotografia 8).

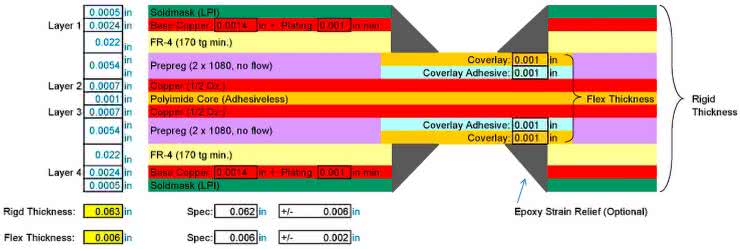

Oprócz prostych płytek, pełniących funkcję rozmaitych adapterów bądź fragmentów wewnętrznego okablowania urządzeń, spotkać można także bardzo rozbudowane konstrukcje, które zarówno w części sztywnej, jak i elastycznej, mają strukturę wielowarstwową. Przykład takiego rozwiązania pokazano na rysunku 31 - dwuwarstwowa część giętka łączy dwie czterowarstwowe płytki, oparte na prepregach typu no-flow oraz usztywnieniach w postaci symetrycznie rozmieszczonych po obu stronach arkuszy FR4. Warto zwrócić uwagę na dwie istotne cechy: po pierwsze, konstrukcja stosu zmienia się w momencie przejścia z części sztywnej na giętką - zamiast prepregu występuje tutaj specjalna warstwa klejąca (określana mianem bondply), łącząca miedź z osłoną, wykonaną np. na bazie poliimidu. Z tego samego materiału jest także wykonany rdzeń części elastycznej, który z oczywistych przyczyn przechodzi przez stos na całej długości zestawienia. Po drugie, wspomniany interfejs stanowi punkt o krytycznym znaczeniu dla niezawodności połączeń, więc dobrym rozwiązaniem może być zastosowanie dodatkowej "odgiętki" w postaci cienkiej warstwy żywicy epoksydowej, wypełniającej narożniki utworzone przez pionowe ścianki części sztywnych oraz pokrycie części elastycznej.

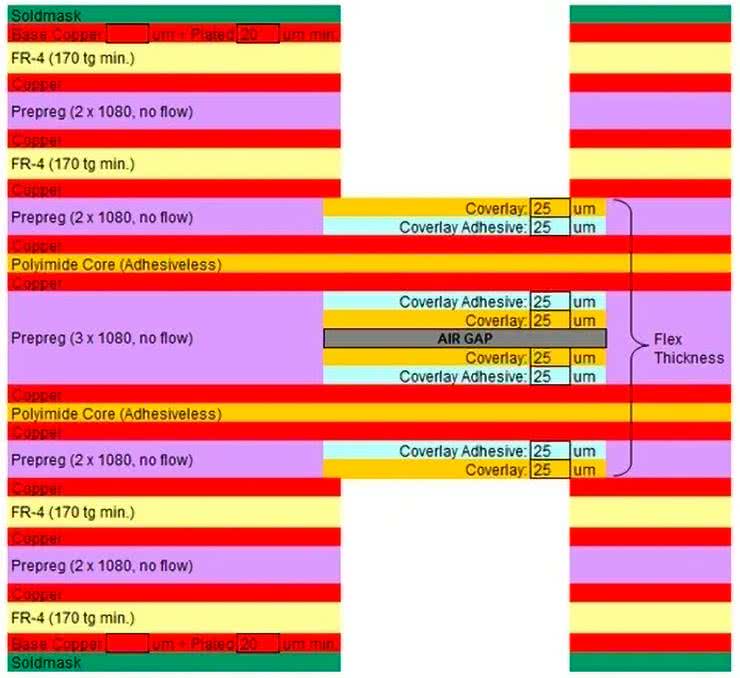

Znacznie bardziej rozbudowany obwód zaprezentowano na rysunku 32 - w tym przypadku części sztywne mają już po 12 warstw, zaś część elastyczna składa się z dwóch "taśm" dwuwarstwowych, przedzielonych cienką warstwą powietrza. Takie rozwiązanie zapewnia swego rodzaju "odciążenie mechaniczne", ale zarazem wymusza bardziej złożoną konstrukcję całości.

Oprócz konstrukcji stosu, podczas projektowania obwodów wielowarstwowych typu rigid-flex należy oczywiście wziąć pod uwagę szereg innych aspektów DFM. Odpowiedni dobór materiałów (w tym specjalnych prepregów, zdolnych do trwałego łączenia podłoży poliimidowych - zwykle kaptonu lub analogicznych materiałów - z miedzią), właściwe prowadzenie ścieżek (przy zachowaniu "łagodnej" geometrii i w miarę możliwości równoległej struktury głównych ścieżek) czy wreszcie dokładnie przemyślane umieszczenie ewentualnych komponentów, lutowanych na części elastycznej (z uwzględnieniem odpowiednich promieni gięcia w docelowym miejscu instalacji) to tylko wybrane spośród czynników, których uwzględnienie jest konieczne do osiągnięcia wymaganej niezawodności oraz akceptowalnych kosztów produkcji.

Podsumowanie

W artykule poruszyliśmy najważniejsze zagadnienia, związane z projektowaniem obwodów wielowarstwowych. Technologia nieustannie zmierza w kierunku coraz większej miniaturyzacji i wciąż przełamuje kolejne granice gęstości upakowania elementów na zaskakująco kompaktowych płytkach. Dziś mikroprzelotki o rozmiarach rzędu ułamka milimetra nie stanowią problemu dla tysięcy producentów PCB na całym świecie, a coraz więcej z nich oferuje już możliwości wytwarzania płyt, określanych mianem Ultra-HDI. Świat elektroniki (zwłaszcza konsumenckiej, np. smartfonów) powoli przestawia się na technologie semi-addytywne (SAP i mSAP), związane z wykonywaniem niewiarygodnie precyzyjnych obwodów drukowanych, których produkcja z użyciem standardowych procesów technologicznych byłaby już całkowicie niemożliwa. Ta tematyka wykracza jednak poza ramy niniejszego przeglądu fundamentalnych zagadnień techniki płyt wielowarstwowych - w niedalekiej przyszłości z pewnością powrócimy jednak do naszych Czytelników z opisami zaawansowanych technologii, stosowanych w supernowoczesnych płytkach drukowanych.

inż. Przemysław Musz, EP

Zaloguj

Zaloguj