Analogowy sygnał napięciowy jest podatny na zakłócenia i z tym się (na ogół) nikt nie kłóci. Nie lubi on sąsiedztwa urządzeń cyfrowych, transformatorów sieciowych, silnych źródeł pola elektromagnetycznego oraz... przerywania mu drogi przepływu prądu. O ile na wiele rzeczy mamy wpływ na etapie projektowania układu (ponieważ możemy umieścić cyfrowe sterowanie czy zasilacze odpowiednio daleko), o tyle samego przełączania już nie unikniemy. Wybór źródeł sygnału, wyciszanie czy pasywna regulacja głośności – w tych miejscach układu dokonujemy bezpośredniej ingerencji w sygnał.

Istnieją dedykowane do tego celu, analogowe klucze scalone, które mają w swojej strukturze odpowiednio sterowanie tranzystory polowe, lecz w sprzęcie audio z wysokiej półki są one niemal niespotykane. Wysoka rezystancja w stanie przewodzenia, relatywnie słaba izolacja po rozłączeniu, zniekształcenia – z tych względów klucze analogowe nie są podzespołami mile widzianymi. Znacznie częściej spotyka się elementy stykowe, jak chociażby przekaźniki. Niska rezystancja przewodzenia, bardzo wysoka rezystancja po rozwarciu, dobra separacja kanałów, znikomy wpływ sterowania na przewodzony sygnał – sporo zalet! Warto jednak pamiętać o kilku praktycznych zasadach aplikacyjnych.

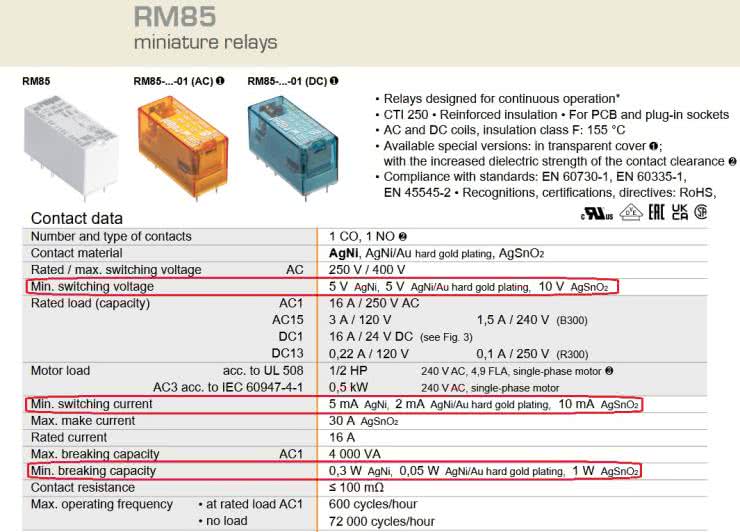

Pierwszą z nich, której (przyznaję) sam się nie trzymałem w początkach swojej elektronicznej działalności, jest stosowanie przekaźników sygnałowych w torze sygnałowym. Typowe przekaźniki elektromagnetyczne, dostępne za symboliczne „2 złote”, mają określony minimalny prąd przewodzenia i/lub napięcie między stykami – rysunek 1. Chodzi o to, by powstające iskrzenie cyklicznie usuwało warstwę osadzających się tlenków, siarczków i innych trudno przewodzących zanieczyszczeń. Jeżeli parametry te nie są spełnione – czyli przekaźnik nie operuje odpowiednio wysoką mocą przełączaną – jakość styku się pogarsza: rośnie rezystancja i pojawiają się trzaski. Dotyczy to zwłaszcza przekaźników o otwartej, nieuszczelnionej obudowie. Miałem taką sytuację lata temu, więc nie polecam opisywanego rozwiązania.

Z tego powodu przekaźniki sygnałowe mają styki z innego materiału (nie śniedzieją same z siebie, za to łatwiej jest je uszkodzić przy załączaniu obciążeń o wysokiej pojemności) oraz hermetycznie zamknięte obudowy, jak na fotografii 1. Często nie mają określonego minimalnego prądu czy napięcia – to jest bardzo dobra wiadomość. Z kolei ich parametry maksymalne są na tyle wysokie, że w torze sygnałowym można nie zwracać na nie większej uwagi, choć nie jest to także uniwersalna reguła. Przykładowo załączanie dodatkowych rezystorów anodowych (wysokie napięcia) czy katodowych (wysokie prądy udarowe z powodu ładowania pojemności kondensatorów katodowych) potrafią dać się we znaki.

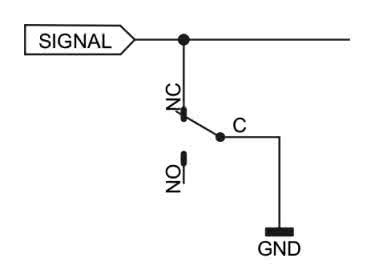

Użycie przekaźnika elektromagnetycznego do zwierania sygnału z masą, czyli do realizacji funkcji wyciszania (mute), jest bardzo często spotykane – rysunek 2. Niska rezystancja takiego zwarcia daje zadowalający efekt w postaci stłumienia sygnału poniżej poziomu szumu. Jednak są sytuacje, w których impedancja wyjściowa stopnia „wyciszanego” jest bardzo niska. Tak dzieje się, na przykład, kiedy źródłem jest transformator lub wzmacniacz operacyjny. Wtedy rezystancja rzędu 100 mΩ, a w praktyce nieco więcej, z uwagi na połączenia, staje się już niewystarczająca do uzyskania dzielnika o zadowalającym stopniu podziału. Dodatkowo jeżeli taki przekaźnik jest włączony w konfiguracji COM-NC, zyskujemy „gratis” blokadę wszystkich niepożądanych stanów przejściowych, które mają miejsce podczas uruchamiania urządzenia.

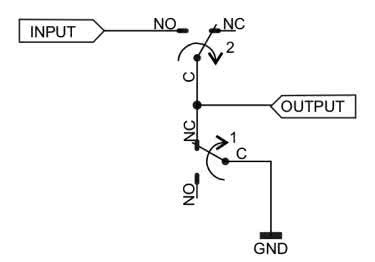

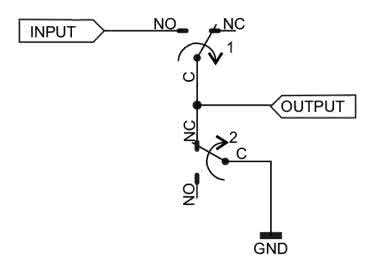

W takich sytuacjach proponuję nie kopać się z koniem, czyli nie łączyć po 2, 3 lub więcej par styków równolegle, bo nie ma to najmniejszego sensu – ich powolne zużywanie się będzie pogarszało jakość tłumienia. Lepiej wtedy najpierw zewrzeć wyjście do masy, a dopiero potem odłączyć je od źródła sygnału, zgodnie z rysunkiem 3. Mamy wtedy chwilę, w trakcie której sygnał przenika, choć mocno ściszony, lecz potem zostaje on odłączony od źródła, na dodatek bez stuknięcia w głośnikach (spowodowanego przerwaniem ciągłości obwodu).

Przy załączaniu sygnału z powrotem trzeba przyjąć kolejność odwrotną – najpierw doprowadzamy sygnał, a dopiero potem rozłączamy zwarcie z masą (rysunek 4), co ma również wpływ na polaryzację następnego stopnia, gdyż jego wejście ani przez chwilę nie wisi w powietrzu. Nie może też to być jeden przekaźnik, którego styk wspólny przełącza się między NO i NC, ponieważ kotwiczka w trakcie przelotu nie jest z nim połączona, co – sprawdziłem boleśnie nieraz – daje nieprzyjemne stuknięcie w głośnikach. Wiele osób projektujących osprzęt do audio zapomina o tak prostych regułach, co przekłada się potem na pogorszone walory użytkowe, gdyż w trakcie przełączania są słyszalne stuki, trzaski, brumienie, tudzież odłączony sygnał nie jest zupełnie wyciszony.

W technice audio – wcale nie tak rzadko – można spotkać sygnałowe przekaźniki bistabilne. Są one stosowane głównie w dwóch aplikacjach. Po pierwsze tam, gdzie regulator głośności i/lub selektor wejść pracuje zasilany z baterii lub – znacznie częściej – wbudowanego akumulatora, co ma na celu całkowite uniemożliwienie przenikania zakłóceń z sieci do sygnału. Nie wdaję się w dyskusję, na ile jest to mierzalne lub słyszalne, po prostu niektórzy melomani mają takie upodobanie. Użycie przekaźników bistabilnych wydaje się tam oczywiste z punktu widzenia energooszczędności całego urządzenia. Pojedyncze przestawienie styków, wymagające zasilenia cewki przez kilkanaście milisekund, umożliwia przekazywanie sygnału w zadanej konfiguracji przez dowolnie długi czas.

Drugim miejscem, w którym takie podzespoły występują, są urządzenia sieciowe – lecz tam dążymy do redukcji wpływu zasilania cewek na sygnał. W takiej opcji możliwe jest użycie przekaźników bistabilnych, ponieważ ich cewki mogą być odłączone od zasilania po zmianie stanu styków. Nie mówię tu o jedynie zrównaniu potencjałów wyprowadzeń cewek (co prowadzi do zaniku przepływu prądu), lecz o odłączeniu ich od zasilania. Również i w tym miejscu nie wdaję się w polemikę, na ile ma to znaczenie – niektórzy twierdzą, że ma dla brzmienia, ale z technicznego punktu widzenia nie jest to nieprawidłowe.

Stosując przekaźniki bistabilne o dostatecznie czułych cewkach, można pokusić się o sterowanie ich z wyjść układów logicznych. Przykładowo popularny przekaźnik AZ832P1-2C-5DE od firmy Zettler ma pojedynczą cewkę o rezystancji 250 Ω, przystosowaną do zasilania napięciem 5 V. W celu dokonania przełączenia trzeba zmienić biegunowość jej zasilania. Taka rezystancja oznacza, że przez cewkę popłynie prąd o natężeniu 20 mA. Jeszcze lepiej sprawa wygląda z AZ832P1-2C-5DSE, który jest czulszą wersją pierwowzoru – ma cewkę o rezystancji aż 330 Ω, co przekłada się na pobór prądu wynoszący jedynie 15 mA.

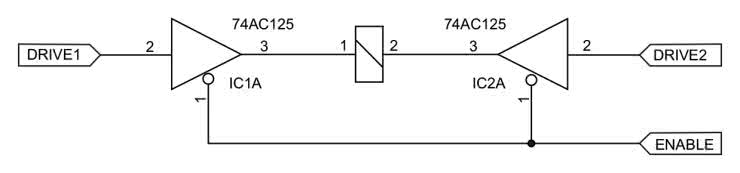

Takimi elementami można sterować wprost z wyprowadzeń bufora trójstanowego, na przykład popularnego 74AC125. Jego wydajność prądowa wynosi aż 24 mA, a ponadto układ ma wbudowane diody zabezpieczające na swoich wyjściach, więc dodatkowe elementy nie są konieczne. Za pewną wadę można uznać niepomijalne napięcia przewodzenia (zwłaszcza w stanie wysokim), więc do zasilania polecam nieco wyższe napięcie, na przykład 5,3…5,5 V. Wtedy jeden taki układ scalony w pełni obsługuje dwa przekaźniki, dając możliwość całkowitego odłączenia cewki od zasilania. Przykładowe połączenie znajduje się na rysunku 5.

Ale to nie wszystko, bowiem do bipolarnego sterowania przekaźnikami bistabilnymi często używam… driverów MOSFET. Mają wysoką wydajność prądową, a ponieważ pracują tylko przez chwilę, nie zdążą się jakkolwiek w tym czasie nagrzać.

Michał Kurzela, EP

Bibliografia:

Zaloguj

Zaloguj